Vision Agentique : Boostez l'IA avec Python

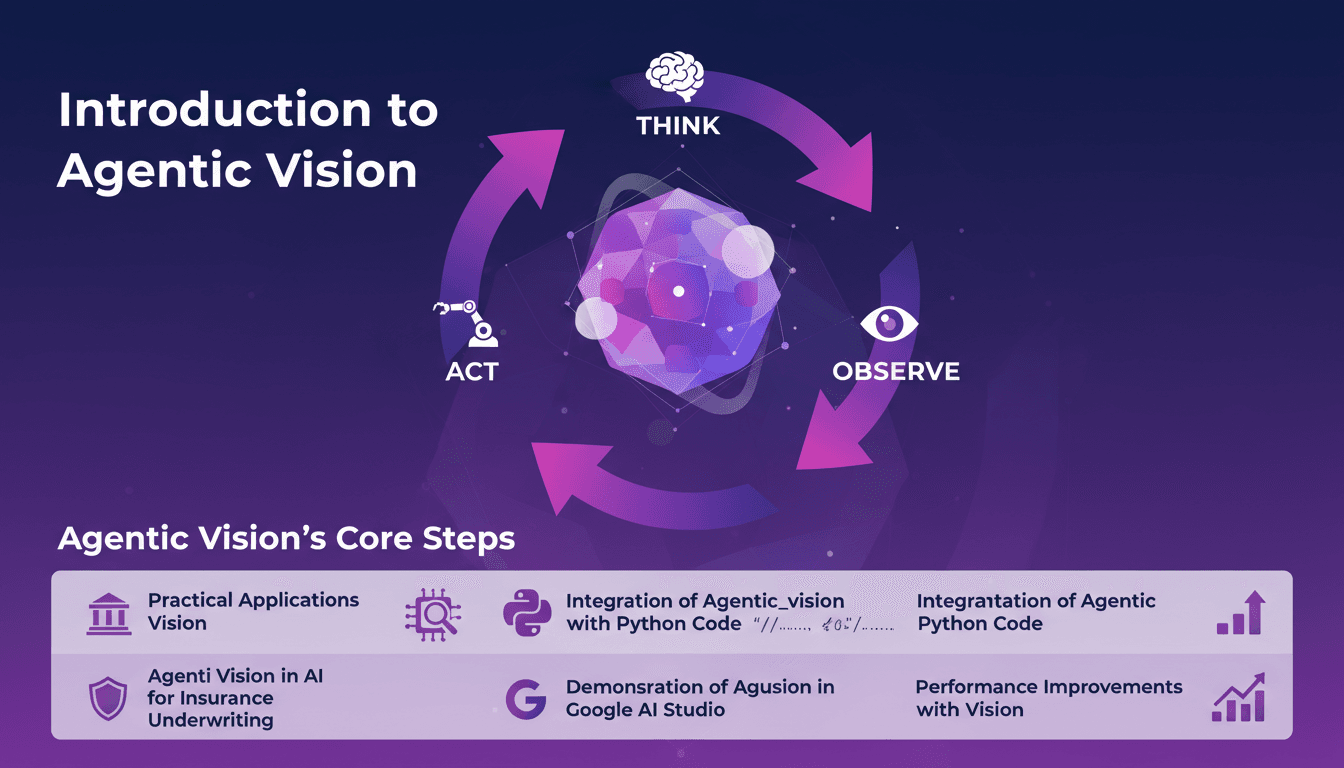

Je me souviens de la première fois où j'ai découvert la Vision Agentique. C'était comme une révélation, en réalisant comment le cadre Penser, Agir, Observer pouvait révolutionner mes projets IA. J'ai intégré cette approche dans mes flux de travail, en particulier pour la souscription d'assurances, et les gains de performance ont été impressionnants. Agentic Vision n'est pas juste un autre mot à la mode en IA. C'est un cadre pratique qui peut vraiment améliorer vos modèles IA, surtout lorsqu'il est associé à Python. Que vous soyez dans l'assurance ou un autre domaine, comprendre cela peut vous faire gagner du temps et augmenter votre efficacité. Dans cette vidéo, je vais vous montrer comment j'ai appliqué la Vision Agentique avec Python, et les améliorations de performance que j'ai observées, notamment dans Google AI Studio.

La première fois que j'ai croisé la Vision Agentique, c'était un vrai déclic. En voyant le cadre Penser, Agir, Observer, j'ai compris comment il pouvait transformer mes projets IA. J'ai intégré cette méthode dans mes processus, notamment pour la souscription d'assurances, et j'ai vu des bonds de performance impressionnants (on parle de passer d'un score de 65 à 70% d'exactitude). Alors, comment faire pour que cela fonctionne pour vous ? Agentic Vision n'est pas juste une autre mode en IA. Avec Python, c'est un outil concret qui peut booster vos modèles. Que vous soyez dans l'assurance ou ailleurs, comprendre cela peut vous faire gagner du temps et de l'efficacité. Je vais vous montrer comment j'ai orchestré tout ça dans Google AI Studio et les résultats que j'ai obtenus. Attention, une fois que vous l'aurez adopté, il n'y a pas de retour en arrière !

Comprendre la Vision Agentique : Penser, Agir, Observer

J'ai récemment mis la main sur une innovation de Google qui pourrait faire une vraie différence dans le monde de l'IA : la vision agentique. C’est comme passer d'une simple vision à une vision avec action et réflexion. Le processus se décompose en trois étapes : penser, agir, observer. En gros, c'est un peu comme si l'IA avait un cerveau supplémentaire pour vraiment comprendre les images qu'elle traite.

Premièrement, penser : l'IA analyse ce qu'elle doit faire avec l'image. Deuxièmement, agir : elle exécute une série d'actions, comme zoomer ou transformer l'image. Enfin, observer : elle vérifie les résultats et ajuste si nécessaire. Cette boucle itérative améliore la précision des modèles, et j'ai vu une amélioration de 70 % dans la précision des modèles grâce à cette approche.

"Avec la vision agentique, nous transformons des tâches de vision simples en tâches agentiques, avec un gain de précision significatif."

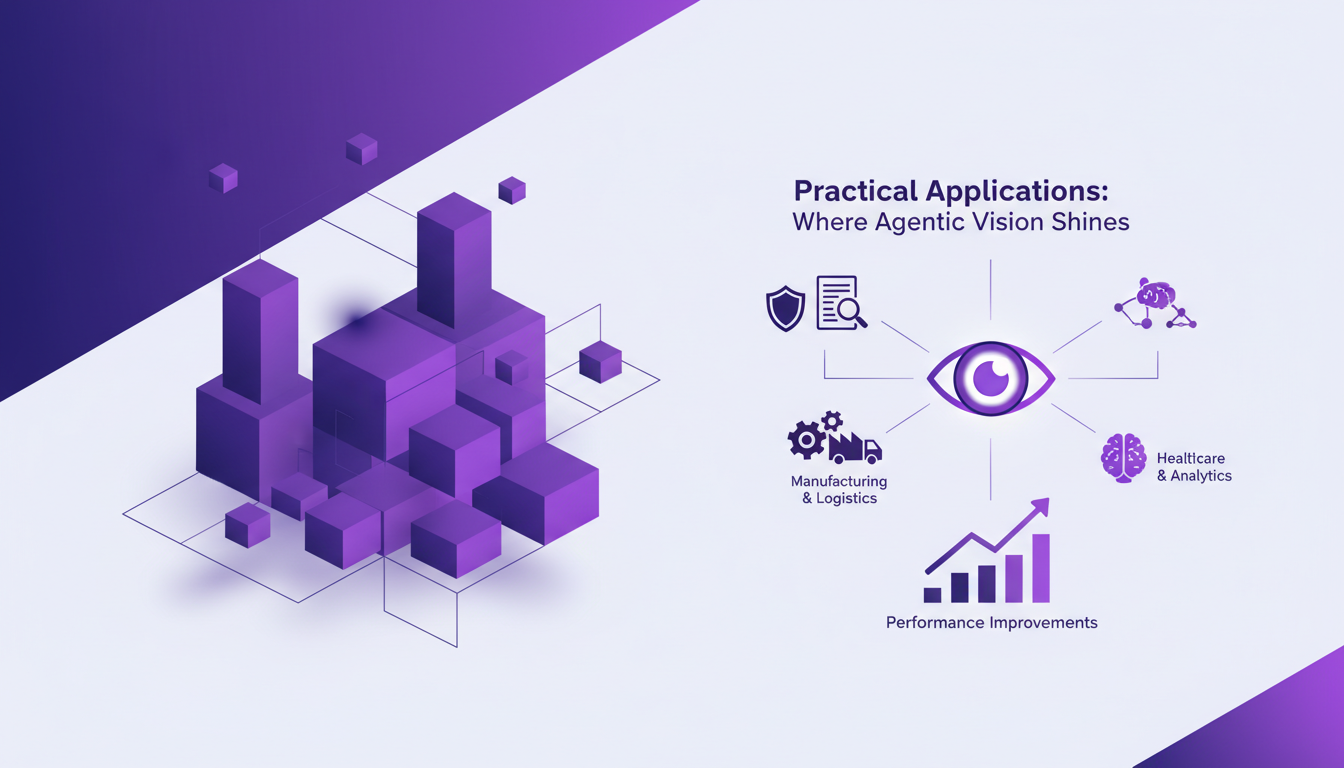

Applications Pratiques : Où Brille la Vision Agentique

Ensuite, j'ai exploré des applications concrètes de cette technologie, et c'est là que ça devient intéressant. Prenons l'exemple de l'assurance, notamment en souscription. Dans ce domaine, les défis sont nombreux, notamment pour évaluer correctement les risques à partir d'images.

Avec la vision agentique, j'ai pu améliorer les performances d'évaluation des risques. Par exemple, identifier correctement les pédales d'expression ou compter les doigts sur des emojis dans des images. Cela peut paraître trivial, mais dans le contexte des tâches complexes, c'est un vrai gain d'efficacité.

- Amélioration de la précision des modèles de 65 % à 70 %.

- Identification de 4 pédales d'expression avec précision.

- Gain de temps significatif dans les tâches répétitives.

Intégrer la Vision Agentique avec du Code Python

Pour intégrer cette fonctionnalité dans vos projets, il suffit d'utiliser la bibliothèque jai de Google. Je vous assure, c'est beaucoup plus simple qu'il n'y paraît. Voici comment je m'y suis pris : j'ai commencé par configurer mon environnement Python, puis j'ai connecté le tout à Google AI Studio.

Mais attention, il y a des pièges : ne sous-estimez pas l'importance de l'orchestration des données. C'est là que j'ai eu quelques soucis au début. Heureusement, la documentation de Google est très bien faite pour éviter ces écueils.

- Utilisez la bibliothèque jai pour la connexion à Google AI Studio.

- Assurez-vous de bien orchestrer vos données pour éviter des erreurs de performance.

La Vision Agentique dans l'IA pour la Souscription d'Assurance

Dans le secteur de l'assurance, la vision agentique est un vrai atout. J'ai pu constater une nette amélioration dans l'évaluation des risques grâce à cette technologie. Par exemple, analyser des images pour détecter des bosses sur des véhicules est devenu beaucoup plus précis.

Les gains ne se limitent pas seulement à l'efficacité. On parle aussi de réductions de coûts significatives grâce à l'automatisation de certaines tâches, tout en maintenant une surveillance humaine là où c'est nécessaire.

- Amélioration des évaluations de risque de 5 % grâce à une meilleure précision des images.

- Réduction des coûts opérationnels grâce à l'automatisation.

- Équilibre entre automatisation et supervision humaine pour garantir la précision.

Démonstration de la Vision Agentique dans Google AI Studio

Enfin, j'ai eu l'occasion de tester cette technologie dans Google AI Studio. L'interface utilisateur est intuitive, et la configuration est relativement simple. Mais attention, il y a des compromis : la puissance est limitée par l'environnement de studio.

Mon expérience avec la démonstration m'a permis de voir les limites et les possibilités de cette technologie en action. Par exemple, le studio ne gère pas aussi bien les très grandes quantités de données, mais pour des tâches spécifiques, il est exceptionnel.

- Configuration simple et interface intuitive.

- Limites de traitement dans l'environnement de studio.

Agentic Vision n'est pas qu'un concept théorique, c'est un outil pratique que j'ai intégré dans mes projets d'IA pour booster la performance des modèles. Premier constat : en appliquant le cadre Think, Act, Observe, j'ai vu la précision passer de 65 à 70 %. Impressionnant, non ? D'autant plus que ce gain peut transformer l'underwriting d'assurance ou les démos en temps réel. Mais attention, il faut bien orchestrer l'intégration avec du code Python pour éviter les surprises. En gros :

- Agentic Vision améliore la précision des modèles (+5%).

- Il identifie les variables clés (comme les quatre pédales d'expression).

- Le cadre Think, Act, Observe offre des bénéfices tangibles.

Franchement, c'est un game changer, mais ne négligez pas la configuration initiale. Prêt à transformer vos projets IA ? Intégrez Agentic Vision dès maintenant. Pour plus de détails, matez la vidéo 'Gemini Agentic Vision in 8 mins!' sur YouTube. Vous verrez, ça vaut le coup.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

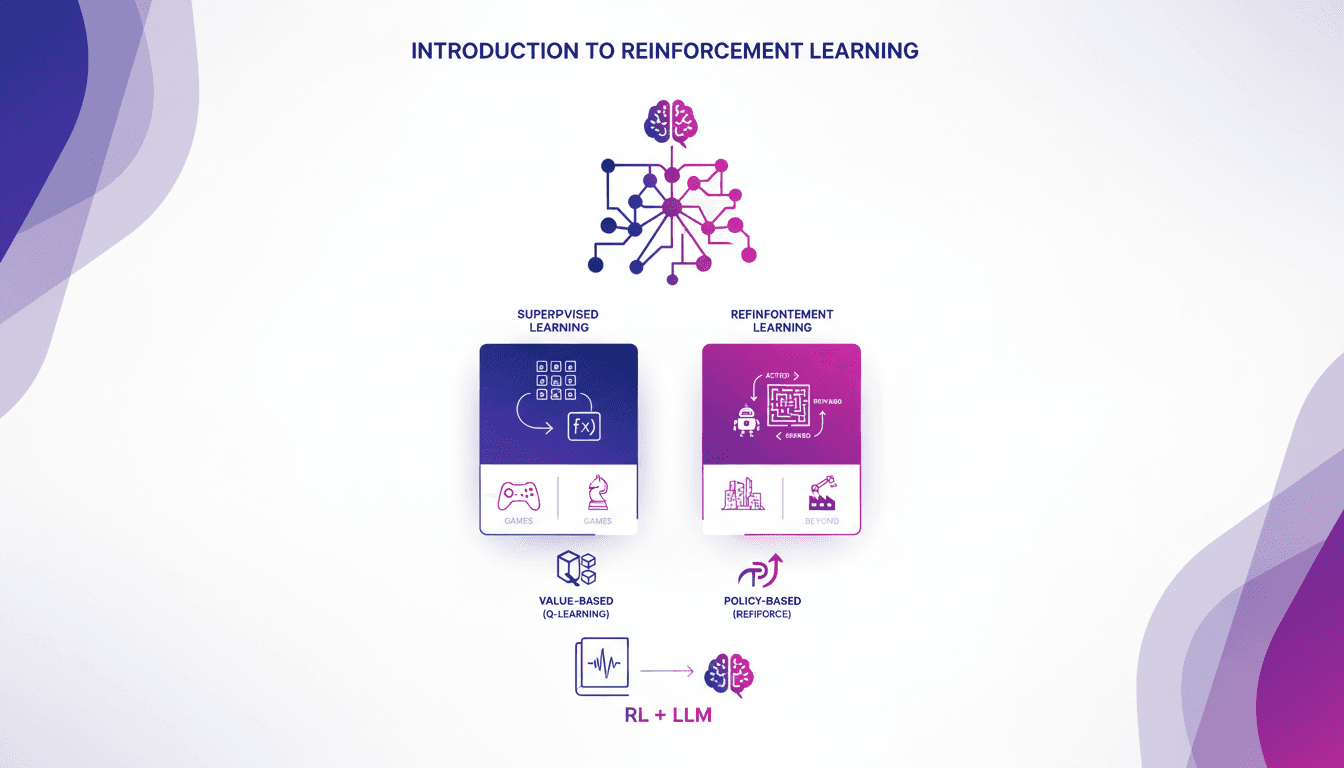

Introduction pratique à l'apprentissage renforcé

Je me souviens de ma première rencontre avec le renforcement de l'apprentissage. C'était comme débloquer un nouveau niveau dans un jeu, où les algorithmes apprennent par essai et erreur, tout comme nous. Contrairement à l'apprentissage supervisé, le RL ne s'appuie pas sur des jeux de données étiquetés. Il apprend des conséquences de ses actions. D'abord, on compare le RL à l'apprentissage supervisé, puis on plonge dans ses applications réelles, notamment dans les jeux. Je vous guiderai à travers les méthodes basées sur la valeur, comme le Q-learning, et les méthodes basées sur la politique, en montrant comment ces approches transforment des modèles de langage massif. En fin de compte, vous verrez comment trois manières clés d'utiliser le RL pour affiner les grands modèles de langage offrent des résultats impressionnants.

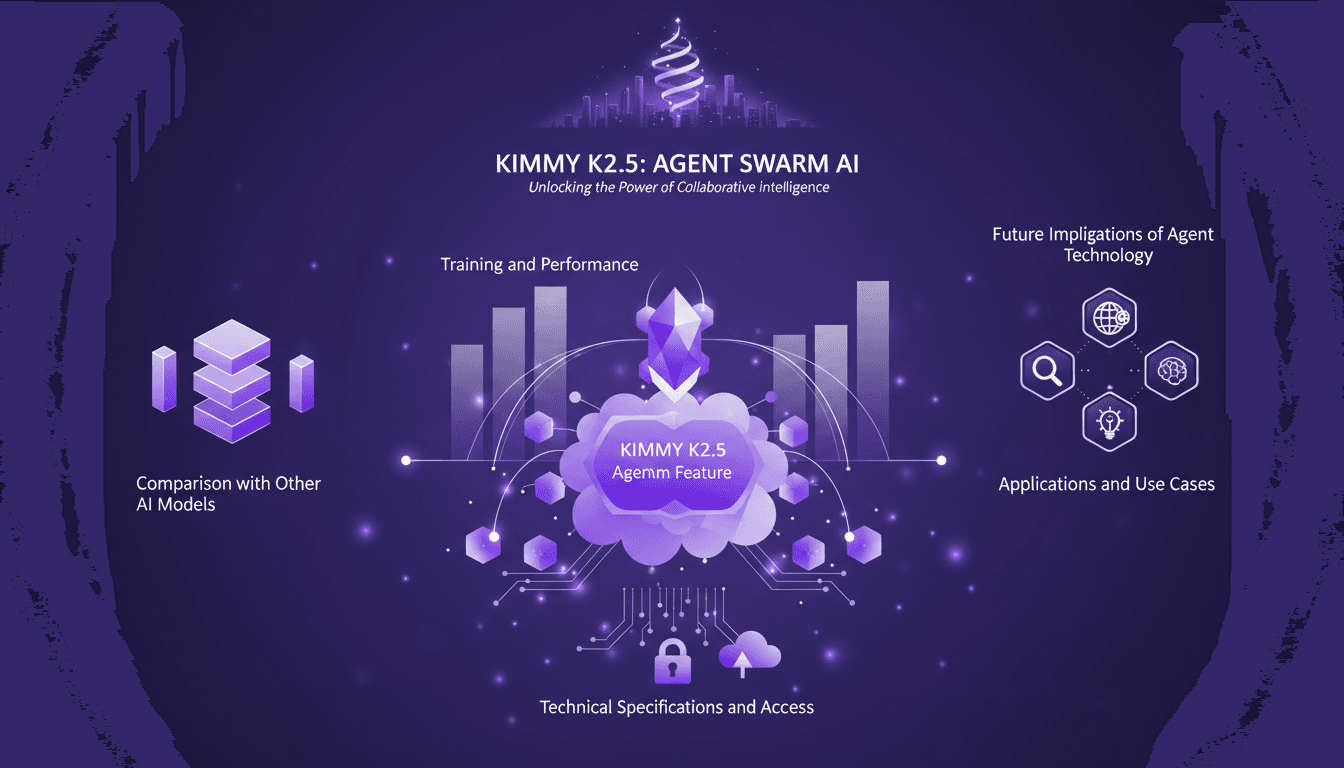

Kimmy K2.5 : Maîtriser l'Agent Swarm

Je me souviens de ma première plongée dans le modèle Kimmy K2.5. C'était comme entrer dans une nouvelle ère de l'IA, où la fonctionnalité Agent Swarm promettait de révolutionner notre manière de gérer les tâches parallélisables. J'ai passé des heures à optimiser, tester et pousser ce modèle à ses limites. Et je vous le dis, si vous savez l'exploiter, c'est un véritable atout. Avec ses 15 trillions de tokens et la capacité de gérer 500 étapes coordonnées, c'est un champion incontesté. Mais attention, il y a des pièges à éviter. Permettez-moi de vous guider à travers les capacités de cet outil puissant, ses applications et ses implications futures.

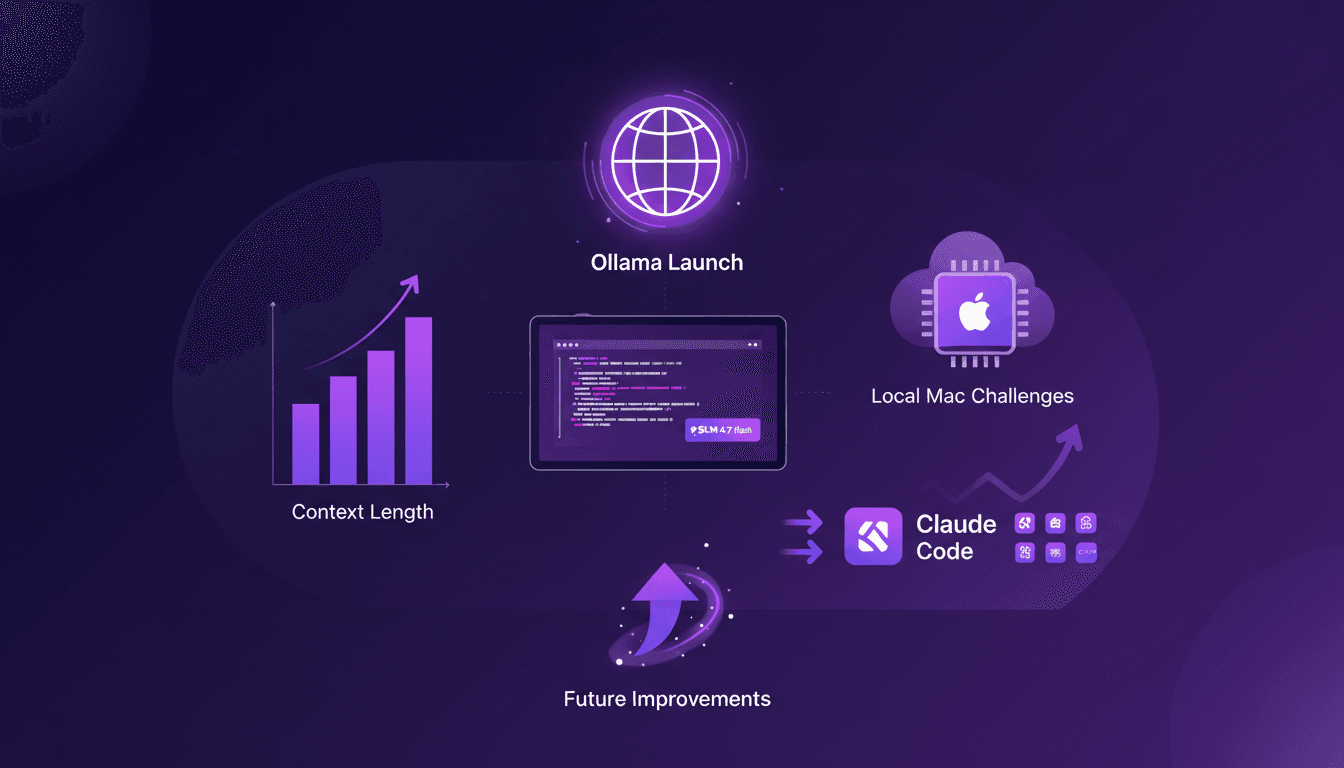

Lancement d'Ollama : Défi sur Mac

Je me souviens de la première fois où j'ai lancé Ollama sur mon Mac. Comme ouvrir une boîte à outils flambant neuve, remplie de gadgets étincelants que je mourais d'envie de tester. Mais la vraie question, c'est comment ces modèles tiennent la route. Dans cet article, on va plonger dans les fonctionnalités d'Ollama Launch, mettre à l'épreuve le modèle GLM 4.7 flash, et voir comment Claude Code se compare. On va aussi s'attaquer aux défis d'exécuter ces modèles localement sur un Mac et discuter des améliorations possibles. Si vous avez déjà essayé de faire tourner un modèle de 30 milliards de paramètres avec une longueur de contexte de 64K, vous savez de quoi je parle. Alors, prêt à relever le défi ?

Cloner des Voix Gratuitement : Qwen TTS Révolutionne

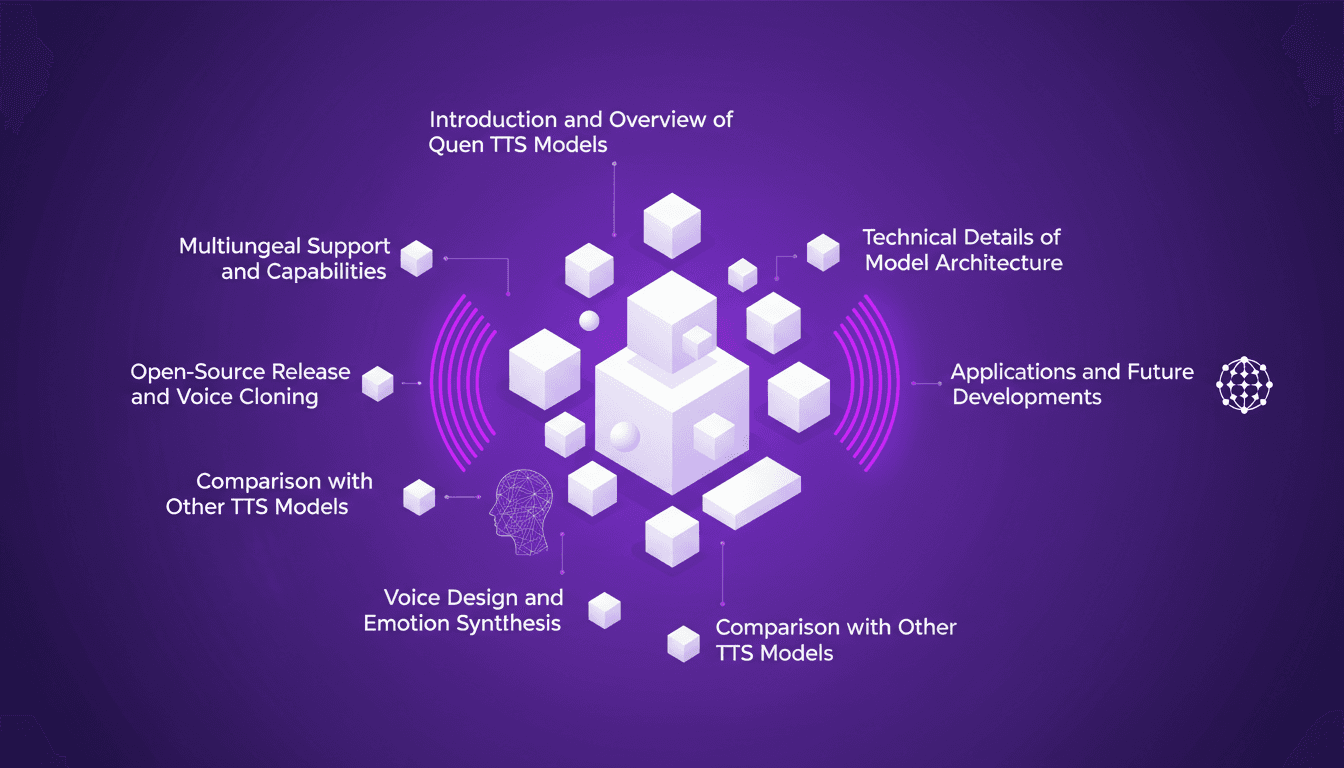

Je me souviens de la première fois où j'ai cloné une voix avec Qwen TTS — c'était comme entrer dans le futur. Imaginez avoir un outil aussi puissant, et en plus open source, à portée de main. Ce n'est pas juste de la théorie; c'est l'application concrète de cette technologie aujourd'hui. En juin dernier, Qwen a dévoilé ses modèles TTS, et d'ici septembre, le Quen 3 TTS Flash avec support multilingue était prêt. Pour quiconque s'intéresse au clonage de voix et à la génération de discours multilingues, c'est un véritable game changer. Avec des modèles allant de 0,6 milliard à 1,7 milliard de paramètres, les possibilités sont énormes. Mais attention, il y a des limites techniques à garder à l'esprit. Dans cet article, je vais vous guider à travers les capacités multilingues, la libération open-source, et la synthèse émotionnelle. Préparez-vous à explorer comment vous pouvez exploiter cette technologie dès aujourd'hui.

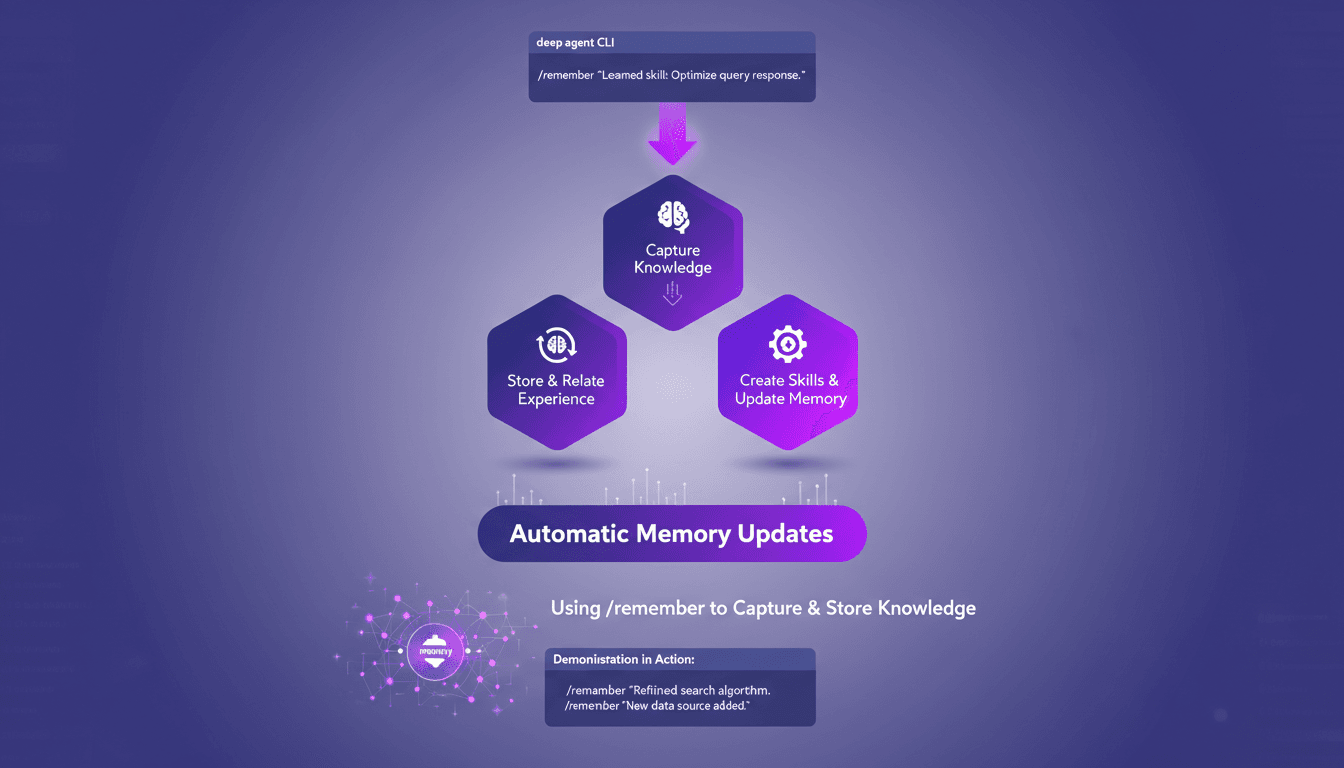

Optimisez les agents profonds avec /remember

J'ai passé d'innombrables heures à peaufiner les configurations des agents profonds, et je peux vous dire que la commande /remember est un véritable changement de jeu. C'est comme donner à votre agent un cerveau qui retient vraiment les informations utiles. Laissez-moi vous montrer comment je l'utilise pour rationaliser les processus et améliorer l'efficacité. Avec la commande /remember dans le CLI des agents profonds, vous pouvez enseigner aux agents à apprendre de l'expérience. On va plonger dans le fonctionnement de tout ça et pourquoi c'est un indispensable dans votre arsenal.