Kimmy K2.5 : Maîtriser l'Agent Swarm

Je me souviens de ma première plongée dans le modèle Kimmy K2.5. C'était comme entrer dans une nouvelle ère de l'IA, où la fonctionnalité Agent Swarm promettait de révolutionner notre manière de gérer les tâches parallélisables. J'ai passé des heures à optimiser, tester et pousser ce modèle à ses limites. Et je vous le dis, si vous savez l'exploiter, c'est un véritable atout. Avec ses 15 trillions de tokens et la capacité de gérer 500 étapes coordonnées, c'est un champion incontesté. Mais attention, il y a des pièges à éviter. Permettez-moi de vous guider à travers les capacités de cet outil puissant, ses applications et ses implications futures.

Je me souviens de ma première plongée dans le modèle Kimmy K2.5. C'était comme entrer dans une nouvelle ère de l'IA. On parle d'une véritable machine de guerre avec 15 trillions de tokens et la capacité de gérer 500 étapes coordonnées. Mais attention, ce n'est pas pour les débutants. J'ai passé des heures à l'optimiser, à le tester, à le pousser dans ses retranchements. Et croyez-moi, j'ai eu des surprises (certaines bonnes, d'autres moins). La fonctionnalité Agent Swarm est ce qui m'a le plus impressionné. Elle permet d'orchestrer des tâches parallélisables de manière efficace, et c'est là que réside sa vraie magie. Pourtant, il ne suffit pas de l'activer et d'espérer des miracles. Il faut savoir où et comment l'utiliser, et c'est là que mon expérience entre en jeu. Je vais vous montrer comment j'ai maîtrisé l'Agent Swarm, les performances que j'ai obtenues par rapport à d'autres modèles, et les applications qui ont transformé mes workflows. Et surtout, je vais vous partager les écueils à éviter pour ne pas vous faire avoir comme je l'ai été au début.

Comprendre le modèle Kimmy K2.5

En tant que praticien, plongeons dans l'architecture du Kimmy K2.5, un modèle phare de Moonshot AI. Ce qui attire immédiatement l'attention, c'est le chiffre impressionnant de 15 trillions de tokens sur lesquels il a été entraîné. Cela inclut non seulement du texte, mais aussi des images visuelles et des vidéos. Cette quantité massive de données permet au modèle d'être multimodal, une caractéristique qui le rend extrêmement polyvalent dans différentes tâches. Mais attention, l'entraînement sur une telle échelle a aussi ses contraintes, notamment en termes de ressources nécessaires pour déployer le modèle efficacement.

L'agent orchestrateur joue un rôle crucial ici. Il est responsable de la gestion des tâches, coordonnant jusqu'à 500 étapes avec des sous-tâches parallélisables. C'est un véritable atout pour les projets complexes où la gestion de multiples processus en parallèle peut faire la différence entre succès et échec. Cependant, il est essentiel de ne pas surcharger cet agent orchestrateur, car cela pourrait entraîner des problèmes de performance.

Exploiter la fonctionnalité Agent Swarm

Passons maintenant à l'Agent Swarm, une fonctionnalité qui permet de coordonner jusqu'à 500 étapes avec des sous-agents auto-dirigés. En pratique, cela signifie que des tâches complexes peuvent être décomposées en sous-tâches parallélisables, chacune gérée par son propre agent. C'est un changement de jeu dans des scénarios réels où le temps est un facteur critique.

Par exemple, dans des applications de développement front-end, l'Agent Swarm excelle à gérer des tâches comme la génération de code vidéo à partir d'images. Mais attention, sous la barre des 100 millions d'utilisateurs, l'utilisation de l'Agent Swarm peut être un compromis en termes de ressources. Cela nécessite une orchestration soigneuse pour éviter de gaspiller des ressources précieuses.

Entraînement et aperçus de performances

Dans mon workflow personnel pour optimiser l'entraînement du Kimmy K2.5, j'ai découvert que le réglage précis des hyperparamètres est essentiel. Les benchmarks de performances montrent que le modèle peut surpasser des concurrents comme OpenAI dans des tâches spécifiques, mais il est crucial de comprendre où se trouvent ses forces et ses faiblesses.

Les pièges courants incluent la surcharge des ressources, ce qui peut ralentir l'ensemble du processus. Il est souvent plus rapide d'exécuter des tests en petits lots plutôt que de tenter de tout orchestrer en une seule fois. Cela équilibre les performances avec les contraintes de ressources.

Comparer Kimmy K2.5 avec d'autres modèles

Comparons maintenant le Kimmy K2.5 avec ses concurrents. Ce qui se démarque, c'est sa capacité multimodale et sa gestion de l'Agent Swarm. Par exemple, dans des tâches multilingues, il surpasse des modèles comme OpenAI et Gemini. Cependant, il a ses limites, notamment dans les cas où la coordination précise des tâches est moins critique.

Pour l'avenir, intégrer Kimmy K2.5 dans votre stratégie IA peut offrir un avantage concurrentiel, à condition de bien comprendre ses capacités et limites. C'est là que des ressources comme Practical Intro to Reinforcement Learning peuvent être utiles.

Applications et implications futures

Enfin, examinons où Kimmy K2.5 fait déjà un impact aujourd'hui. Il est particulièrement efficace dans des domaines comme le codage visuel et le développement front-end. Les futures applications de la technologie Agent Swarm sont prometteuses, avec des implications potentielles dans des domaines comme l'analyse de données massives.

Pour naviguer dans les spécifications techniques et les options d'accès, Kimmy propose des solutions flexibles, comme l'accès via Open Router. Cependant, il est crucial de comprendre les restrictions d'utilisation, notamment en ce qui concerne le nombre d'utilisateurs. En regardant vers l'avenir, la capacité de l'Agent Swarm à traiter des tâches complexes en parallèle représente une avancée significative dans le domaine de l'IA.

Kimmy K2.5, c'est pas juste une question de puissance brute, c'est surtout comment tu l'utilises. J'ai orchestré des tâches complexes avec, et honnêtement, ça change la donne – surtout quand tu jongles avec des sous-tâches parallélisables. Mais attention, c'est pas sans limites. D'abord, pense à bien comprendre ces limites pour vraiment tirer le meilleur parti de cette bête. Quelques points clés : avec moins de 100 millions d'utilisateurs, tu es dans la zone verte. Le modèle phare K2.5 est entraîné sur 15 trillions de tokens – c'est énorme. Mais, n'oublie pas, le potentiel est immense si tu sais l'apprivoiser. Prêt à intégrer Kimmy K2.5 dans ton workflow ? Commence à explorer ses capacités aujourd'hui et vois comment ça transforme ton approche de l'IA. Pour un aperçu plus poussé, mate la vidéo complète 'Kimi K2.5 - The Agent Swarm Champion' sur YouTube. Franchement, ça vaut le détour pour comprendre à fond comment cette tech peut booster ton quotidien.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Lancement d'Ollama : Défi sur Mac

Je me souviens de la première fois où j'ai lancé Ollama sur mon Mac. Comme ouvrir une boîte à outils flambant neuve, remplie de gadgets étincelants que je mourais d'envie de tester. Mais la vraie question, c'est comment ces modèles tiennent la route. Dans cet article, on va plonger dans les fonctionnalités d'Ollama Launch, mettre à l'épreuve le modèle GLM 4.7 flash, et voir comment Claude Code se compare. On va aussi s'attaquer aux défis d'exécuter ces modèles localement sur un Mac et discuter des améliorations possibles. Si vous avez déjà essayé de faire tourner un modèle de 30 milliards de paramètres avec une longueur de contexte de 64K, vous savez de quoi je parle. Alors, prêt à relever le défi ?

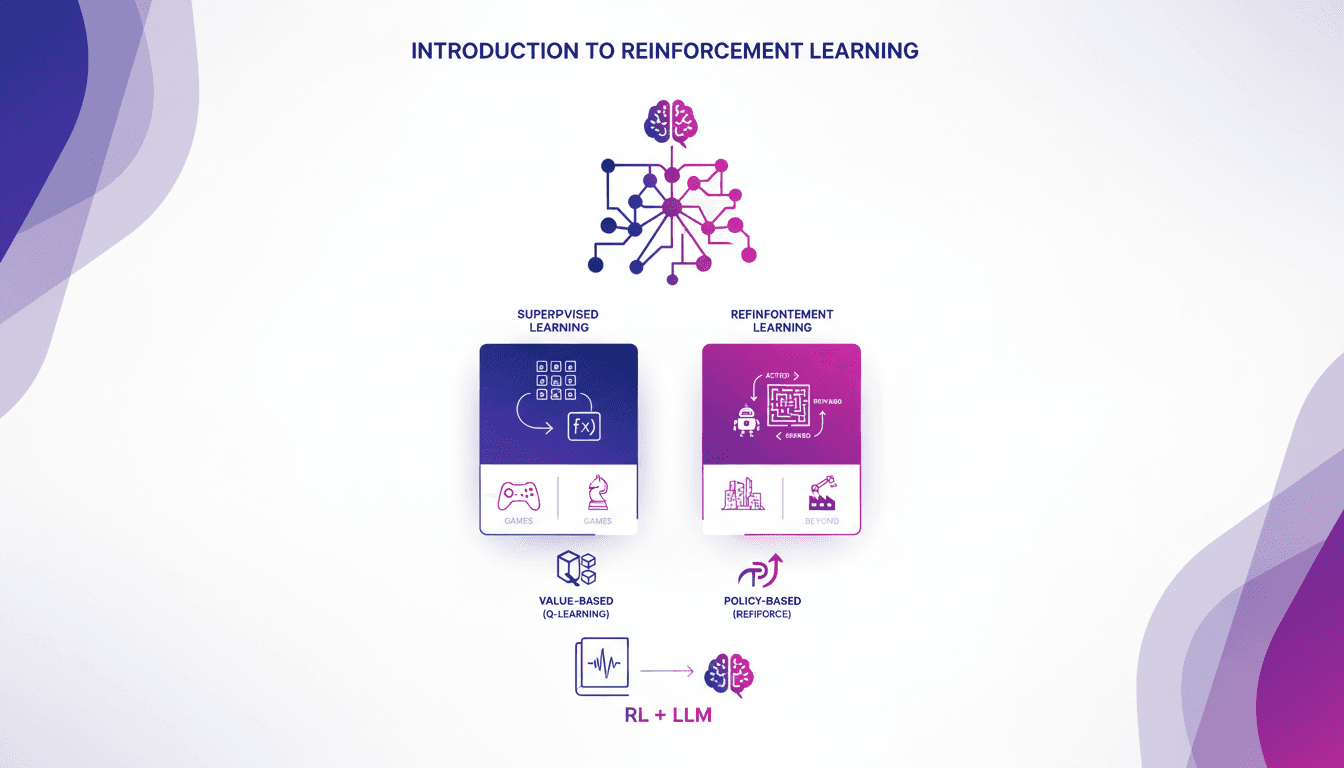

Introduction pratique à l'apprentissage renforcé

Je me souviens de ma première rencontre avec le renforcement de l'apprentissage. C'était comme débloquer un nouveau niveau dans un jeu, où les algorithmes apprennent par essai et erreur, tout comme nous. Contrairement à l'apprentissage supervisé, le RL ne s'appuie pas sur des jeux de données étiquetés. Il apprend des conséquences de ses actions. D'abord, on compare le RL à l'apprentissage supervisé, puis on plonge dans ses applications réelles, notamment dans les jeux. Je vous guiderai à travers les méthodes basées sur la valeur, comme le Q-learning, et les méthodes basées sur la politique, en montrant comment ces approches transforment des modèles de langage massif. En fin de compte, vous verrez comment trois manières clés d'utiliser le RL pour affiner les grands modèles de langage offrent des résultats impressionnants.

Cloner des Voix Gratuitement : Qwen TTS Révolutionne

Je me souviens de la première fois où j'ai cloné une voix avec Qwen TTS — c'était comme entrer dans le futur. Imaginez avoir un outil aussi puissant, et en plus open source, à portée de main. Ce n'est pas juste de la théorie; c'est l'application concrète de cette technologie aujourd'hui. En juin dernier, Qwen a dévoilé ses modèles TTS, et d'ici septembre, le Quen 3 TTS Flash avec support multilingue était prêt. Pour quiconque s'intéresse au clonage de voix et à la génération de discours multilingues, c'est un véritable game changer. Avec des modèles allant de 0,6 milliard à 1,7 milliard de paramètres, les possibilités sont énormes. Mais attention, il y a des limites techniques à garder à l'esprit. Dans cet article, je vais vous guider à travers les capacités multilingues, la libération open-source, et la synthèse émotionnelle. Préparez-vous à explorer comment vous pouvez exploiter cette technologie dès aujourd'hui.

Techniques Diffusion ML: Appliquées et Optimisées

Depuis que je suis plongé dans le machine learning en 2012, j'ai vu des techniques venir et partir, mais les modèles de diffusion sont un vrai changement de jeu. Et ce n'est pas juste pour les académiciens—je parle d'applications concrètes qui peuvent transformer votre flux de travail. La diffusion en ML n'est pas un simple mot à la mode. C'est un cadre fondamental qui redéfinit notre approche de l'IA, de la modélisation d'images au traitement de données complexes. Pour les fondateurs et les praticiens, comprendre et appliquer ces techniques peut vous faire gagner du temps et augmenter votre efficacité. Avec seulement 15 lignes de code, vous pouvez mettre en place un processus de machine learning puissant. Si vous êtes prêt à explorer l'avenir de l'IA, c'est le moment de maîtriser la diffusion.

Mesurer Productivité Dev avec METR: Défis

J'ai passé des heures à essayer de quantifier la productivité des développeurs, et quand j'ai entendu Joel Becker parler de METR, ça m'a frappé. La manière dont METR mesure les 'Long Tasks' et la productivité des développeurs open source est un vrai changement de jeu. À l'approche de 2030, on parle de plafonnement potentiel de la croissance du calcul. Comprendre comment on mesure et améliore la productivité devient crucial. METR propose une perspective unique pour relever ces défis, en particulier dans les environnements open source. C'est fascinant de voir comment l'IA peut transformer notre façon de travailler, bien qu'elle ait ses limites, notamment dans la gestion du code hérité. Mais attention, ne surutilisez pas l'IA pour automatiser chaque tâche. Elle a encore du chemin à faire, surtout en robotique et en fabrication. Joel nous montre comment naviguer dans ce paysage complexe, en mettant en lumière l'impact de la familiarité des outils sur la productivité. Plongeons dans ces insights qui peuvent réellement transformer nos workflows.