Cloner des Voix Gratuitement : Qwen TTS Révolutionne

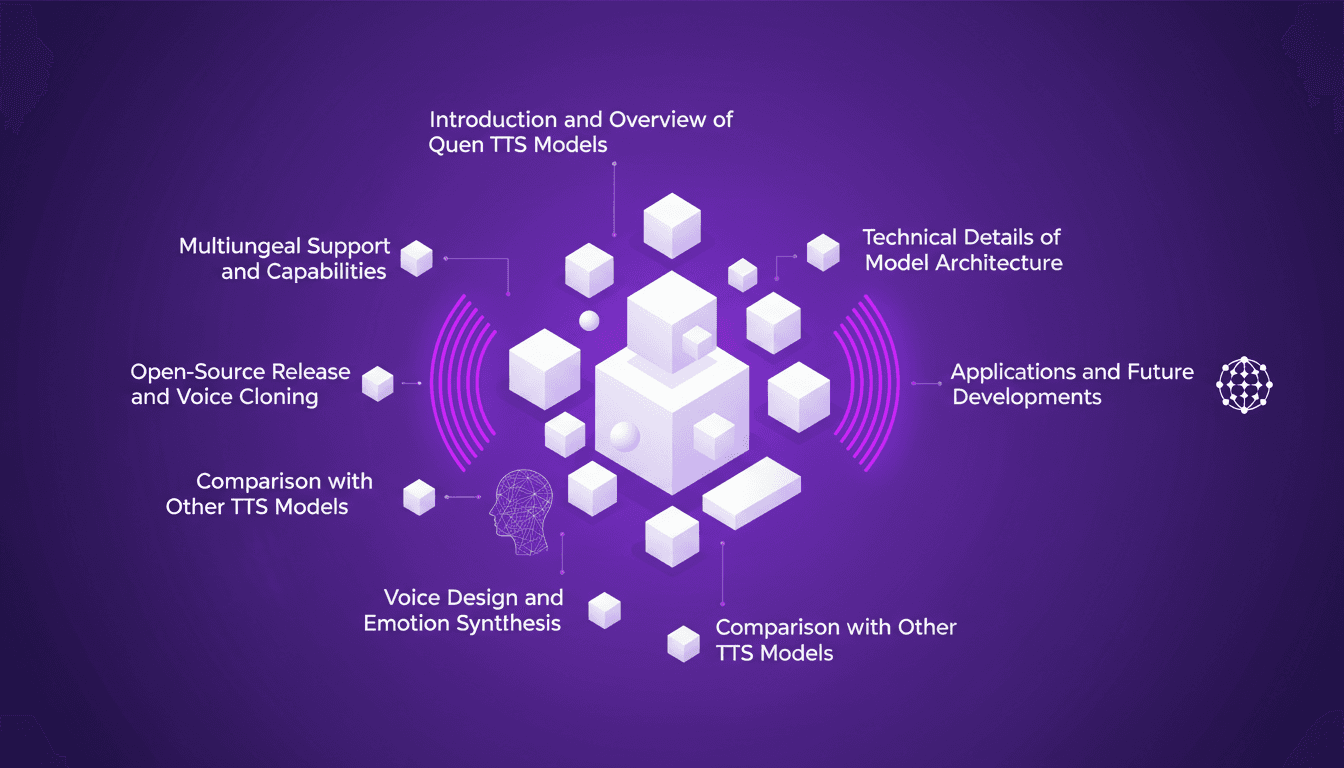

Je me souviens de la première fois où j'ai cloné une voix avec Qwen TTS — c'était comme entrer dans le futur. Imaginez avoir un outil aussi puissant, et en plus open source, à portée de main. Ce n'est pas juste de la théorie; c'est l'application concrète de cette technologie aujourd'hui. En juin dernier, Qwen a dévoilé ses modèles TTS, et d'ici septembre, le Quen 3 TTS Flash avec support multilingue était prêt. Pour quiconque s'intéresse au clonage de voix et à la génération de discours multilingues, c'est un véritable game changer. Avec des modèles allant de 0,6 milliard à 1,7 milliard de paramètres, les possibilités sont énormes. Mais attention, il y a des limites techniques à garder à l'esprit. Dans cet article, je vais vous guider à travers les capacités multilingues, la libération open-source, et la synthèse émotionnelle. Préparez-vous à explorer comment vous pouvez exploiter cette technologie dès aujourd'hui.

Je me souviens de la première fois où j'ai cloné une voix avec Qwen TTS — c'était comme faire un bond dans le futur. D'un coup, j'avais accès à un outil incroyablement puissant, et qui plus est, open source. Ce n'est pas une simple théorie, c'est une révolution pour ceux qui veulent s'approprier la technologie du clonage de voix aujourd'hui. Quand Qwen a annoncé ses modèles TTS en juin dernier, je me suis dit que ça allait changer la donne. Et puis en septembre, le Quen 3 TTS Flash est arrivé avec son support multilingue. Avec des modèles allant de 0,6 milliard à 1,7 milliard de paramètres, il y a de quoi faire. Mais attention, il y a des pièges à éviter, comme les limites techniques. Dans cet article, je vais vous expliquer comment je pilote cette technologie, de la prise en main des capacités multilingues à la synthèse émotionnelle. C'est un outil que vous pouvez exploiter dès aujourd'hui, mais ne vous laissez pas brûler par l'excitation sans connaître les limites.

Commencer avec les Modèles Qwen TTS

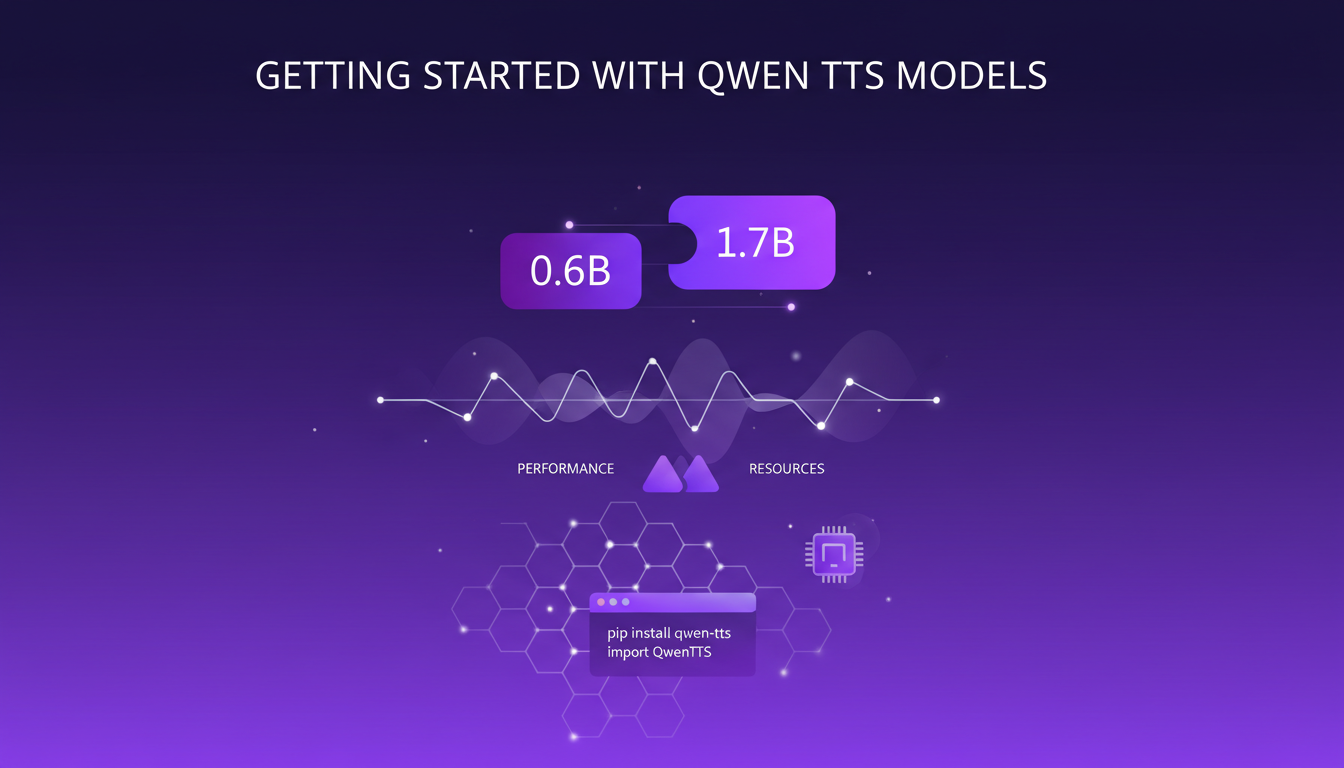

Quand j'ai commencé à expérimenter avec les modèles Qwen TTS, la première chose qui m'a frappé, c'était la diversité des options. Vous avez les modèles plus petits de 0.6b et les plus grands de 1.7B. Le choix entre ces deux dépend vraiment de votre cas d'utilisation. Le modèle plus petit est parfait pour des tâches rapides et légères, tandis que le plus grand offre une puissance incroyable, notamment pour le clonage vocal.

Configurer votre environnement pour Qwen TTS n'est pas sorcier, mais attendez-vous à quelques défis initiaux. Par exemple, j'ai découvert que la gestion des ressources est cruciale, surtout avec le modèle de 1.7B. Je me suis fait avoir une fois, pensant que mon setup pouvait tout gérer sans transpirer. Erreur de débutant !

Explorer les Capacités Multilingues

Avec le support pour 10 langues, 9 dialectes, et 49 tambas, les capacités multilingues de Qwen TTS sont impressionnantes. Cela ouvre des portes incroyables pour toucher un public mondial. Mais, attention, intégrer ces langues n'est pas trivial. J'ai d'abord sous-estimé la complexité de la mise en place, pensant naïvement que tout fonctionnerait comme sur des roulettes.

Pour mettre en œuvre le TTS multilingue, vous devez vraiment comprendre les besoins de votre public cible et choisir les langues en conséquence. Mais ne vous éparpillez pas trop non plus, car chaque langue ajoutée complexifie l'architecture.

- Définissez vos langues cibles clairement dès le départ.

- Testez chaque langue individuellement pour éviter les surprises.

- Tenez compte du support technique nécessaire pour chaque langue.

Publication Open-Source et Clonage Vocal

La décision de Quen de rendre leurs modèles open-source change la donne pour les développeurs. Je peux maintenant cloner une voix sans les contraintes habituelles des API propriétaires. Cela dit, le chemin vers un clonage vocal parfait n'est pas sans embûches. Il m'a fallu quelques essais pour comprendre les nuances du processus.

Voici comment je m'y prends :

- Préparation d'un échantillon vocal propre et clair.

- Utilisation des outils de Quen pour créer un modèle initial.

- Ajustement fin pour obtenir un résultat réaliste.

Plongée Technique : Architecture du Modèle

Comprendre l'architecture de Qwen TTS est essentiel pour tirer le maximum des modèles. Ce qui m'a marqué, c'est l'approche end-to-end du système de formation. Cela signifie que vous pouvez entraîner le modèle de bout en bout sans avoir besoin d'intermédiaires complexes. Mais attention, la personnalisation n'est pas toujours simple.

Le modèle de 0.6B est un bon point de départ pour les petites applications, tandis que le 1.7B est plus adapté aux tâches complexes, comme la synthèse d'émotions. Cependant, vouloir tout personnaliser peut vite devenir une perte de temps si l'on n'est pas vigilant.

Applications et Développements Futurs

Les applications actuelles de Qwen TTS vont du gaming à l'accessibilité. J'ai personnellement utilisé ces modèles pour créer des voix personnalisées dans des jeux vidéo, et les résultats ont été bluffants. La conception de voix et la synthèse d'émotions ajoutent une dimension supplémentaire, donnant vie aux personnages comme jamais auparavant.

Mais ce qui m'excite le plus, ce sont les tendances futures dans la technologie TTS. Avec l'innovation constante, nous devons toujours équilibrer entre innovation et mise en œuvre pratique. Le potentiel est énorme, mais il faut rester pragmatique pour ne pas se perdre dans la complexité technologique.

En conclusion, Qwen TTS ne se contente pas de changer les règles du jeu, il redéfinit les standards de l'industrie. Mais comme toujours, restez vigilant et adaptez les technologies à vos besoins spécifiques.

Plonger dans Qwen TTS, c'est comme ouvrir la boîte de Pandore de la synthèse vocale. D'abord, ces modèles de 0.6b et 1.7B offrent une flexibilité impressionnante avec le support multilingue, parfait pour les développeurs audacieux. Ensuite, avec son cœur open-source, on peut vraiment bidouiller et adapter aux besoins spécifiques. Mais attention, plus le modèle est puissant, plus l'orchestration doit être maîtrisée. Les performances peuvent dégringoler si mal gérées.

Ce que je trouve vraiment excitant, c'est la perspective de cloner n'importe quelle voix, gratuitement. Si ça ne vous donne pas envie d'explorer, je ne sais pas ce qui le fera. Mais rappelez-vous, chaque avancée technologique vient avec ses défis.

Prêt à cloner votre première voix ? Allez donc voir la vidéo originale "Clone ANY Voice for Free — Qwen Just Changed Everything" sur YouTube. Ça vaut le détour pour vraiment comprendre tout le potentiel (et les pièges) de Qwen TTS.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

TTS Ultra Rapide sur CPU: Clonage Vocal 2026

Je me souviens encore de ma première tentative avec un modèle de synthèse vocale sur mon CPU grand public. C'était lent, frustrant, comme un retour vers le passé. Mais le modèle TTH a changé la donne. Imaginez atteindre des performances TTS ultra-rapides sur un matériel standard, avec en prime un clonage vocal bluffant. Dans cet article, je vous guide à travers cette innovation de 2026 : de la configuration technique aux comparaisons avec d'autres modèles, et comment vous pouvez intégrer cela dans vos projets. Si vous êtes développeur ou simplement un passionné, vous allez vouloir voir ça.

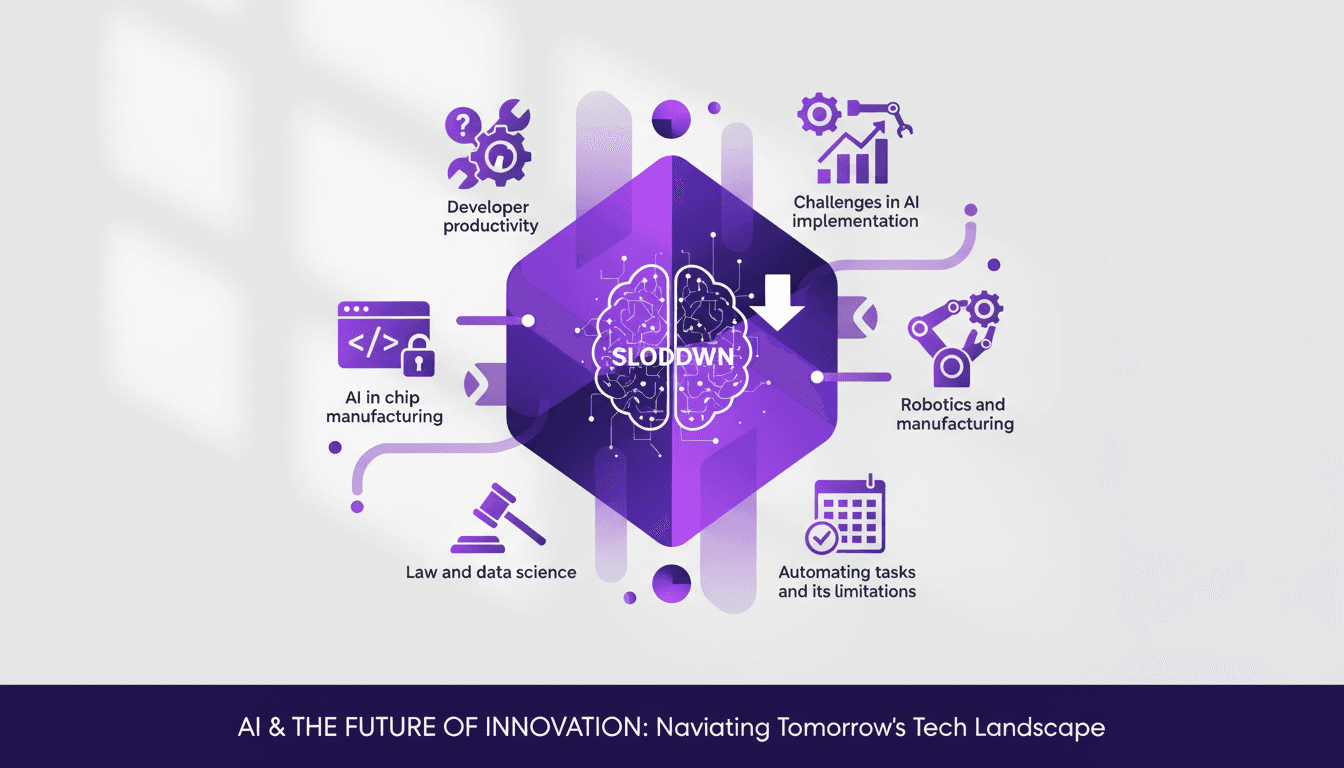

Mesurer Productivité Dev avec METR: Défis

J'ai passé des heures à essayer de quantifier la productivité des développeurs, et quand j'ai entendu Joel Becker parler de METR, ça m'a frappé. La manière dont METR mesure les 'Long Tasks' et la productivité des développeurs open source est un vrai changement de jeu. À l'approche de 2030, on parle de plafonnement potentiel de la croissance du calcul. Comprendre comment on mesure et améliore la productivité devient crucial. METR propose une perspective unique pour relever ces défis, en particulier dans les environnements open source. C'est fascinant de voir comment l'IA peut transformer notre façon de travailler, bien qu'elle ait ses limites, notamment dans la gestion du code hérité. Mais attention, ne surutilisez pas l'IA pour automatiser chaque tâche. Elle a encore du chemin à faire, surtout en robotique et en fabrication. Joel nous montre comment naviguer dans ce paysage complexe, en mettant en lumière l'impact de la familiarité des outils sur la productivité. Plongeons dans ces insights qui peuvent réellement transformer nos workflows.

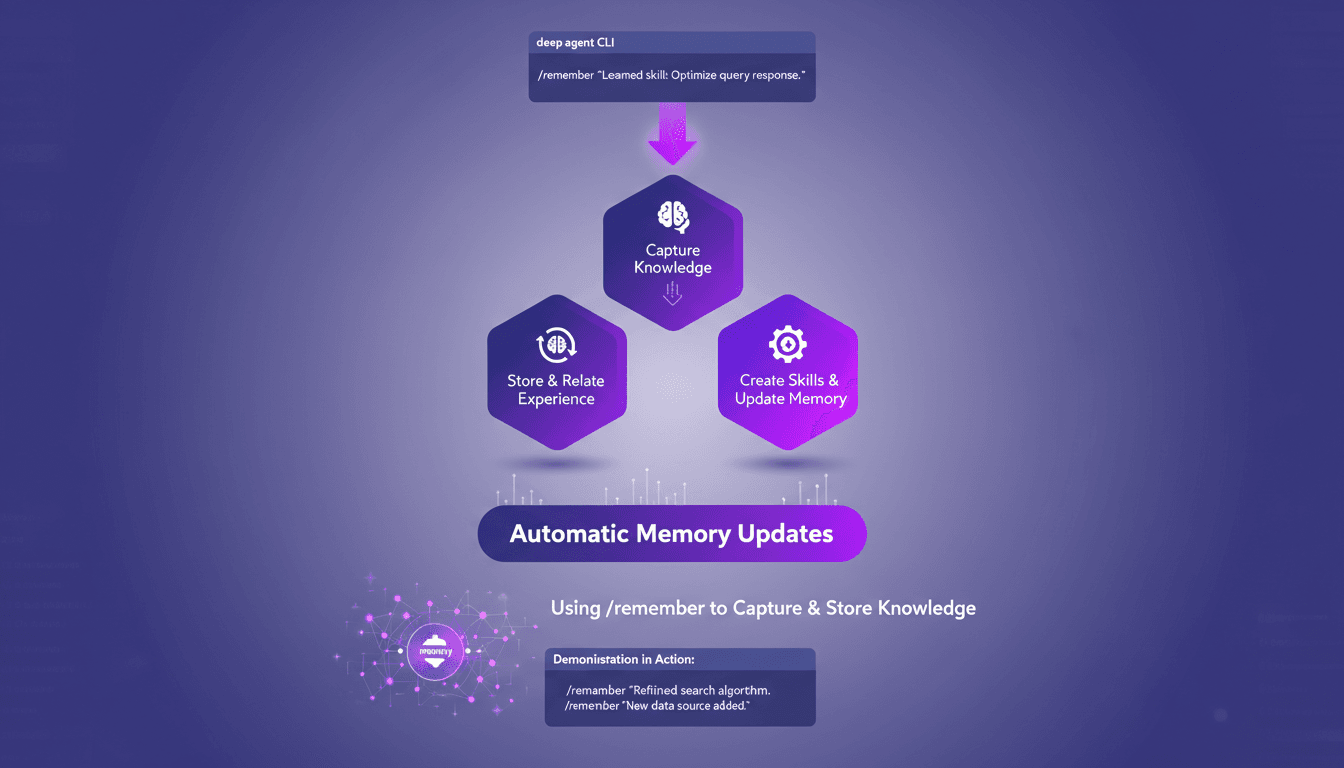

Optimisez les agents profonds avec /remember

J'ai passé d'innombrables heures à peaufiner les configurations des agents profonds, et je peux vous dire que la commande /remember est un véritable changement de jeu. C'est comme donner à votre agent un cerveau qui retient vraiment les informations utiles. Laissez-moi vous montrer comment je l'utilise pour rationaliser les processus et améliorer l'efficacité. Avec la commande /remember dans le CLI des agents profonds, vous pouvez enseigner aux agents à apprendre de l'expérience. On va plonger dans le fonctionnement de tout ça et pourquoi c'est un indispensable dans votre arsenal.

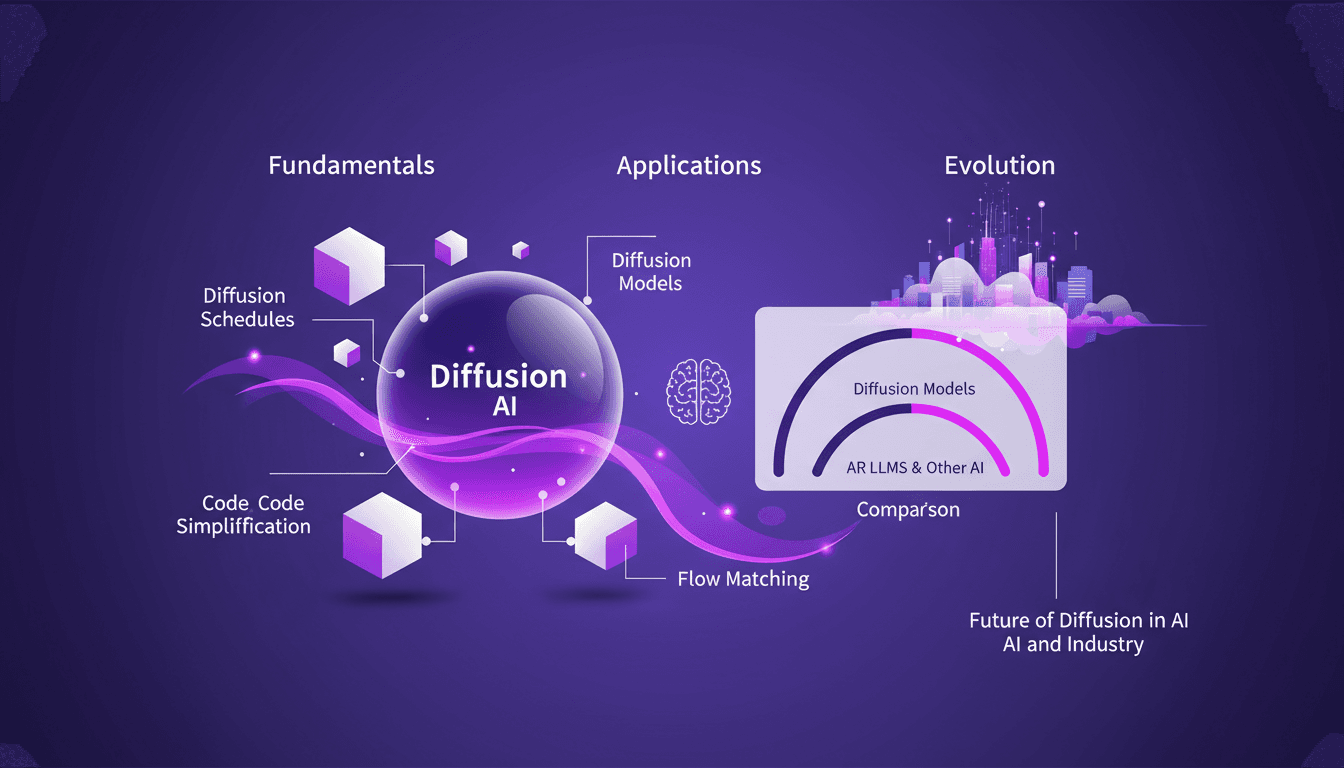

Techniques Diffusion ML: Appliquées et Optimisées

Depuis que je suis plongé dans le machine learning en 2012, j'ai vu des techniques venir et partir, mais les modèles de diffusion sont un vrai changement de jeu. Et ce n'est pas juste pour les académiciens—je parle d'applications concrètes qui peuvent transformer votre flux de travail. La diffusion en ML n'est pas un simple mot à la mode. C'est un cadre fondamental qui redéfinit notre approche de l'IA, de la modélisation d'images au traitement de données complexes. Pour les fondateurs et les praticiens, comprendre et appliquer ces techniques peut vous faire gagner du temps et augmenter votre efficacité. Avec seulement 15 lignes de code, vous pouvez mettre en place un processus de machine learning puissant. Si vous êtes prêt à explorer l'avenir de l'IA, c'est le moment de maîtriser la diffusion.

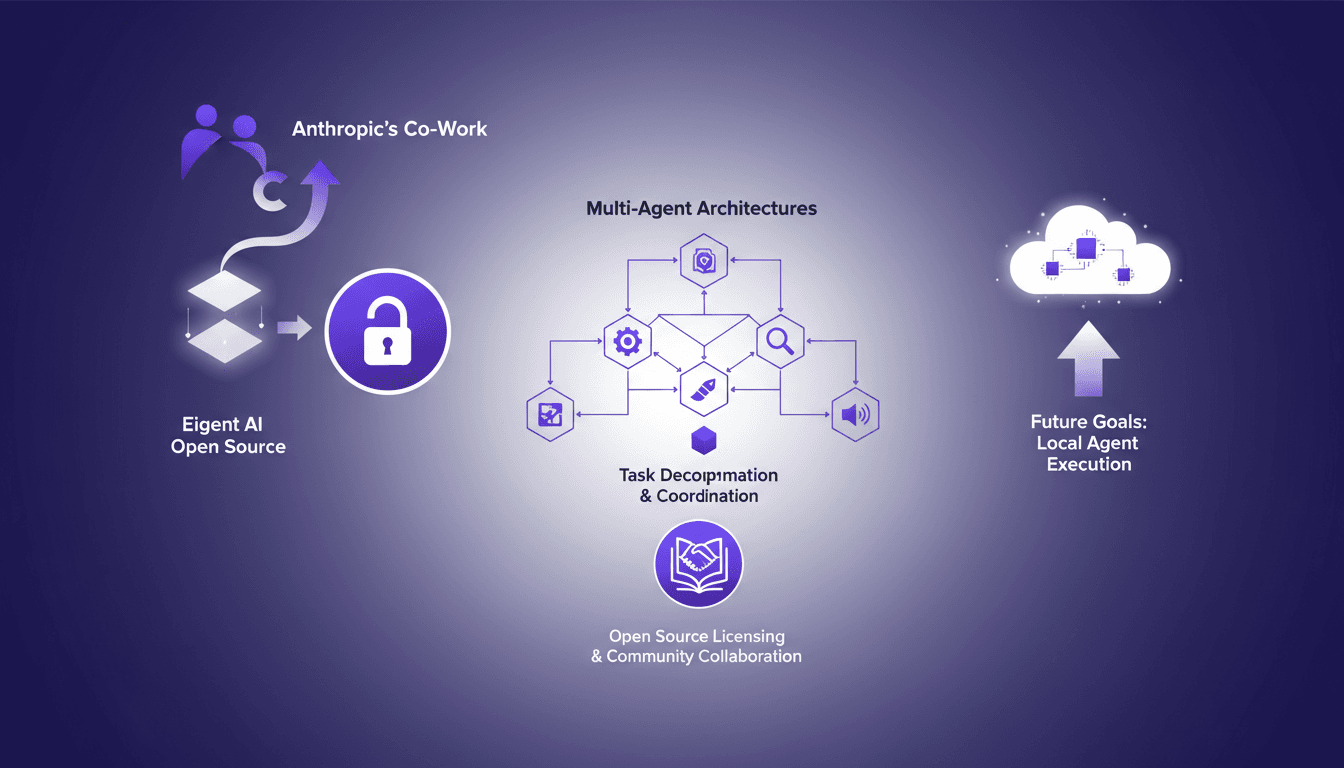

Projets Open Source: Eigent AI défie Claude Cowork

Je me souviens du jour où Eigent AI a décidé d'ouvrir notre produit en open source. C'était un pari audacieux, motivé par la sortie du co-work d'Anthropic. Cette décision a transformé notre approche des architectures multi-agents. En ouvrant notre architecture, nous voulions tirer parti de la collaboration communautaire et améliorer nos systèmes multi-agents. Le défi était de taille mais les résultats ont été à la hauteur, notamment en termes de décomposition de tâches et de coordination via DAG. Si vous vous demandez comment cela a bouleversé notre processus de développement, plongeons ensemble dans cette transformation.