Projets Open Source: Eigent AI défie Claude Cowork

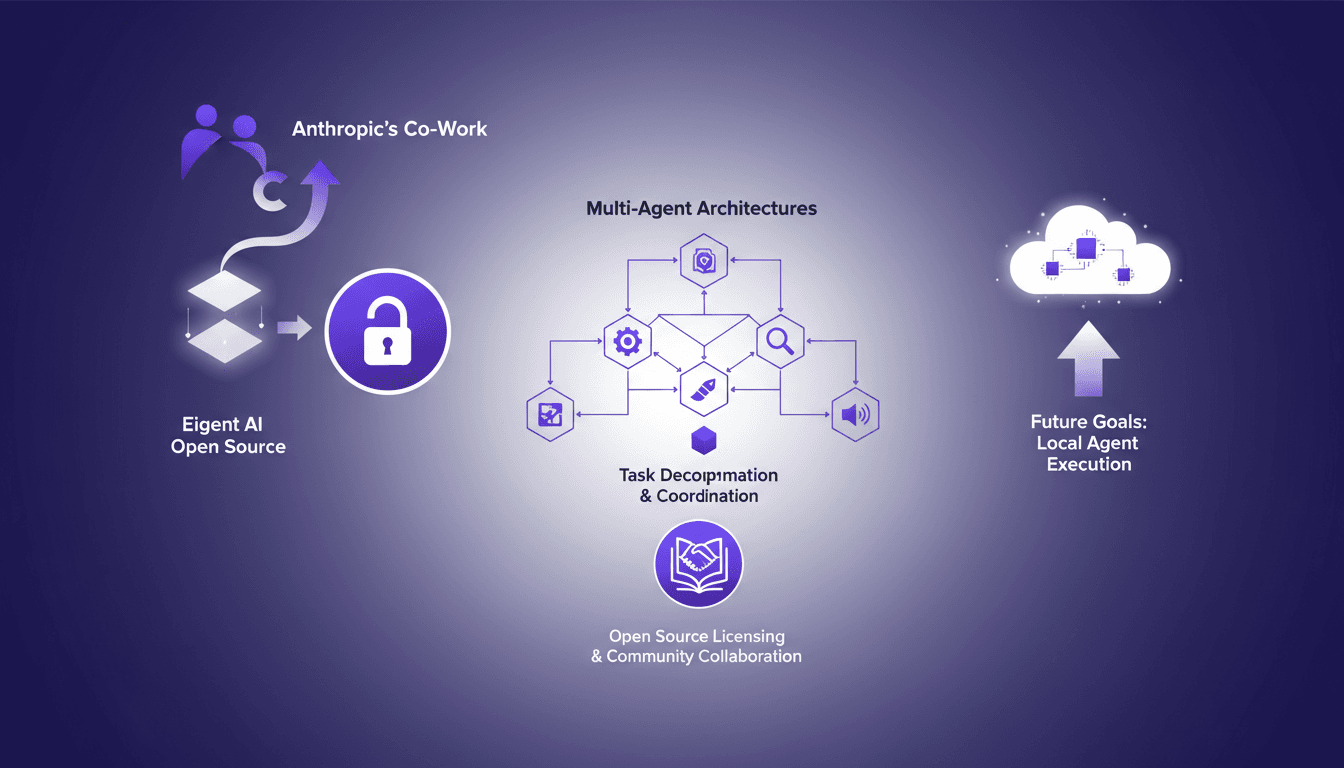

Je me souviens du jour où Eigent AI a décidé d'ouvrir notre produit en open source. C'était un pari audacieux, motivé par la sortie du co-work d'Anthropic. Cette décision a transformé notre approche des architectures multi-agents. En ouvrant notre architecture, nous voulions tirer parti de la collaboration communautaire et améliorer nos systèmes multi-agents. Le défi était de taille mais les résultats ont été à la hauteur, notamment en termes de décomposition de tâches et de coordination via DAG. Si vous vous demandez comment cela a bouleversé notre processus de développement, plongeons ensemble dans cette transformation.

Je me souviens du jour où Eigent AI a décidé de passer notre produit en open source. Inspiré par la sortie du co-work d'Anthropic, ce fut un tournant ambitieux. Cette décision a redéfini notre manière d'aborder les architectures multi-agents. D'abord, nous avons ouvert notre architecture pour encourager la collaboration communautaire et tirer parti des idées extérieures. Imaginez des agents spécialisés qui se coordonnent via des DAG. C'est là qu'on a vraiment vu l'impact. Bien sûr, ce n'était pas sans défis : gérer les licences open source, s'assurer que la communauté s'implique, et surtout, éviter de se faire avoir par les pièges du sur-engouement initial. Mais les bénéfices ? Des systèmes plus robustes et une évolution rapide grâce à des collaborations inattendues. Alors, si vous êtes dans le même bateau et que vous vous demandez comment piloter une telle transformation, je vais vous montrer comment nous avons navigué à travers ces eaux et ce que cela signifie pour l'avenir de l'exécution locale des agents.

Le Lancement de Co-Work par Anthropic : Un Catalyseur de Changement

Quand Anthropic a lancé son co-work, ça a créé une vraie onde de choc dans le monde des startups. Ce n'était pas juste un nouvel outil, c'était un vrai changement de paradigme. Les startups, souvent agiles mais vulnérables, ont dû s'adapter rapidement. Et c'est là qu'Eigent AI a pris une décision radicale : tirer parti du potentiel de l'open-source. Au lieu de paniquer, ils ont vu une opportunité d'innover différemment. C'est comme si le tweet qui a généré 1,7 million de vues était le signal qu'il fallait saisir. Pourtant, cette nouvelle ère apporte aussi son lot de défis, notamment en termes de gestion de la propriété intellectuelle et de collaboration ouverte.

Le Pari Audacieux d'Eigent AI : Open-Source de Notre Produit

Pourquoi avons-nous choisi la voie de l'open-source sous licence Apache 2 ? Pour moi, c'était évident. Permettre à la communauté de contribuer, c'est booster l'innovation et l'efficacité. Mais attention, l'open-source n'est pas une panacée. Il s'agit d'équilibrer le contrôle et la collaboration. J'ai appris de Camel AI, qui avait déjà développé un modèle il y a trois ans. Ils ont montré que l'ouverture peut catalyser des avancées, mais qu'elle nécessite aussi une gestion rigoureuse.

Démystifier les Architectures Multi-Agents chez Eigent AI

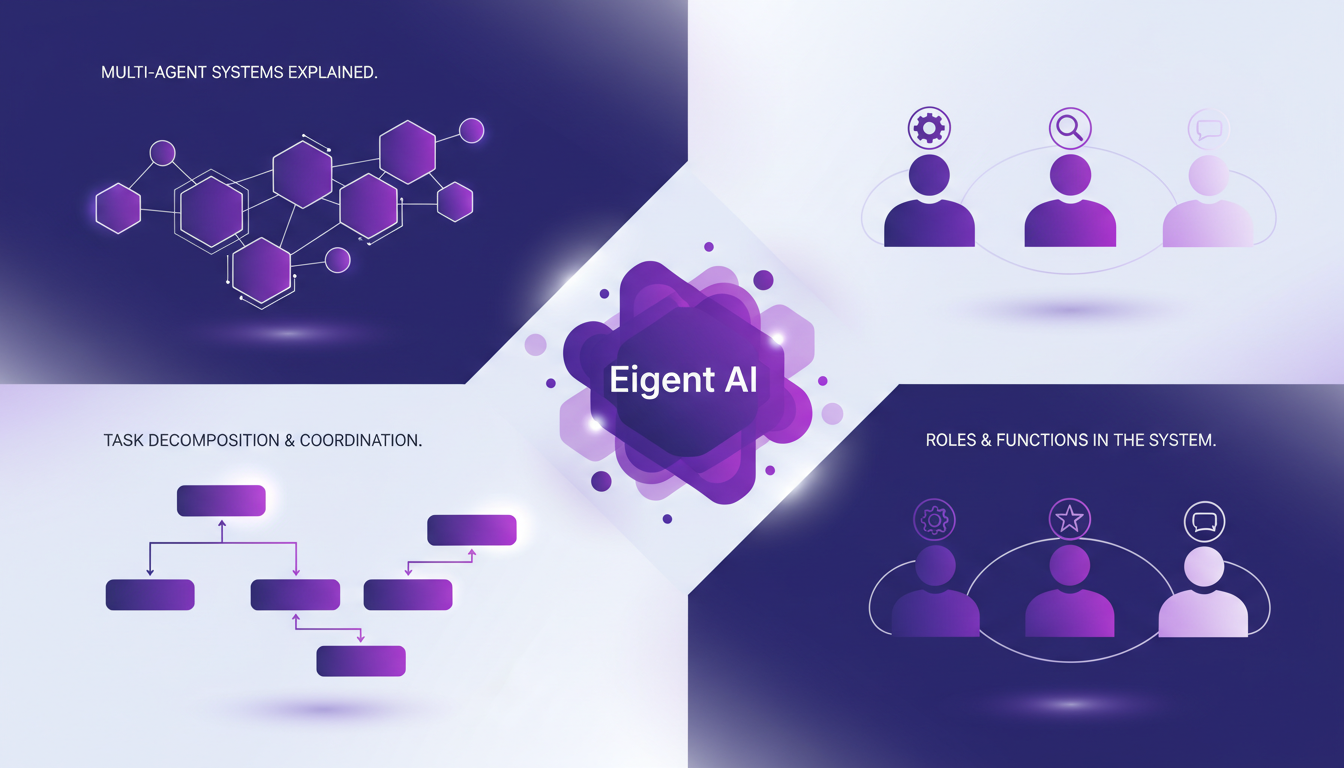

L'architecture des systèmes multi-agents, c'est tout un art. On parle de graphes acycliques dirigés (DAG) pour décomposer et coordonner les tâches. Chaque agent a un rôle spécifique, un peu comme des ouvriers spécialisés sur un chantier. En s'inspirant de Camel AI, on sait qu'on peut potentiellement gérer jusqu'à un million d'agents. Mais attention, plus il y a d'agents, plus la coordination devient complexe. Il faut alors penser à l'échelle et à l'efficience énergétique.

Agents Spécialisés et Leurs Fonctions

Chez Eigent AI, on a quatre agents spécialisés prêts à l'emploi. Le développeur, le navigateur, le traitement de documents et le multimodal. Chacun d'eux effectue des tâches d'entreprise variées avec Gemini 3. L'intégration avec les APIs de Playwright booste leur fonctionnalité. Cela dit, il ne faut pas abuser de ces agents, sinon on risque de perdre en performance. Parfois, il vaut mieux des agents moins nombreux mais plus efficaces.

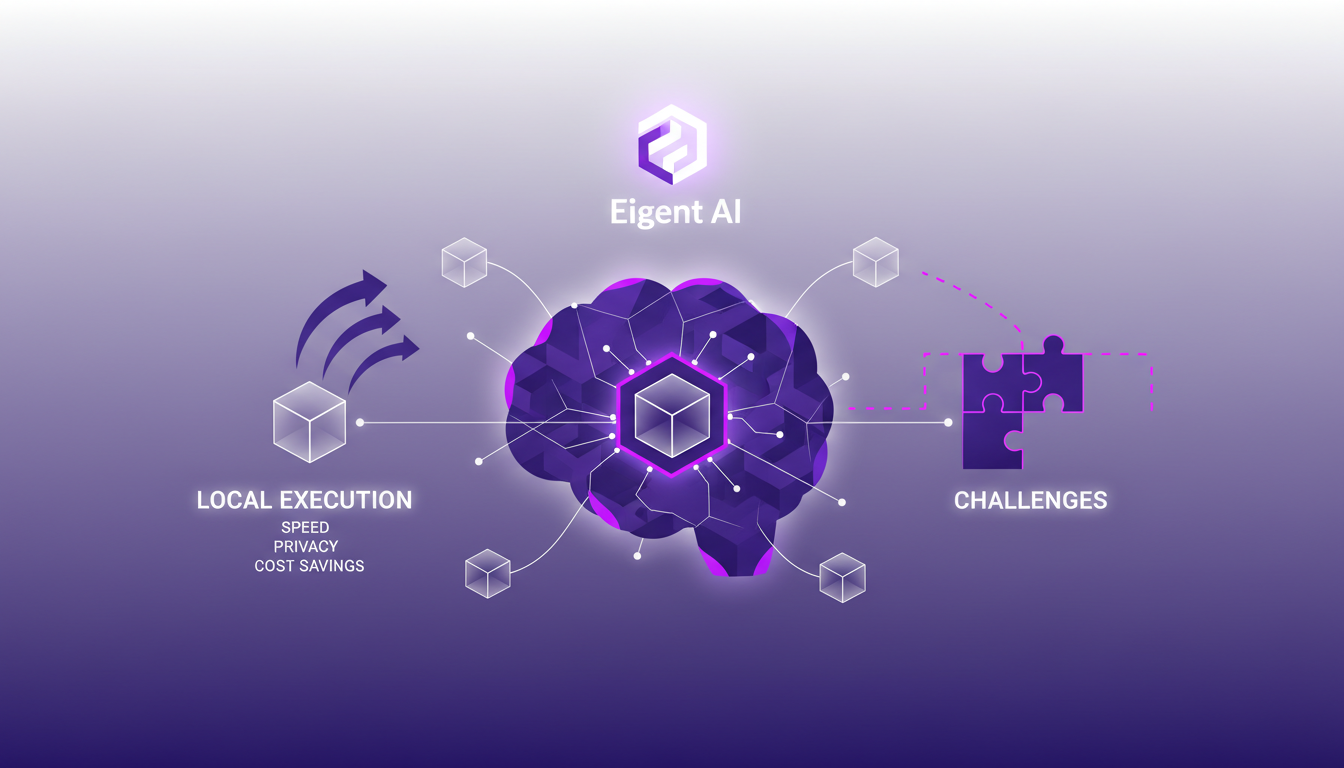

Objectifs Futurs : Exécution Locale des Agents

Notre vision à long terme chez Eigent AI, c'est de faire tourner nos systèmes localement sur des ordinateurs. Pourquoi ? Pour la vitesse, la confidentialité et les économies. Mais attention, l'intégration locale sans accroc est un vrai défi. Il faut anticiper les problèmes de compatibilité et d'optimisation. Notre ambition est d'étendre les capacités et la portée de nos agents, tout en garantissant une exécution fluide et sécurisée.

En conclusion, Eigent AI se positionne comme un acteur majeur dans le domaine des architectures multi-agents. Avec des choix audacieux et une ouverture à l'innovation collaborative, nous traçons la voie vers l'avenir des systèmes d'IA. Mais chaque avancée s'accompagne de nouveaux défis et il est crucial de rester vigilant et adaptable.

Ouvrir l'architecture d'Eigent AI, ça a vraiment tout changé. J'ai vu comment l'open source peut débloquer de nouvelles possibilités et rassembler une communauté autour d'une vision commune. C'est excitant, mais attention, ce n'est pas sans défis. Par exemple, coordonner jusqu'à un million d'agents, c'est super ambitieux mais demande une décomposition de tâches très fine avec des DAG.

- 1,7 million de vues sur un tweet, c'est énorme, ça montre l'intérêt.

- Le modèle de Camel AI, couvert il y a 3 ans, prend tout son sens aujourd'hui.

- Le potentiel d'échelle avec jusqu'à un million d'agents, c'est fou, mais complexe.

L'avenir est prometteur si on continue de collaborer. Ensemble, on peut redéfinir ce qui est possible dans les systèmes multi-agents. Alors, rejoignez-nous dans cette aventure open source. Contribuez, collaborez, et pour une plongée plus en profondeur, regardez la vidéo originale : Eigent AI prenant Claude Cowork. Vous allez voir, ça vaut le coup !

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

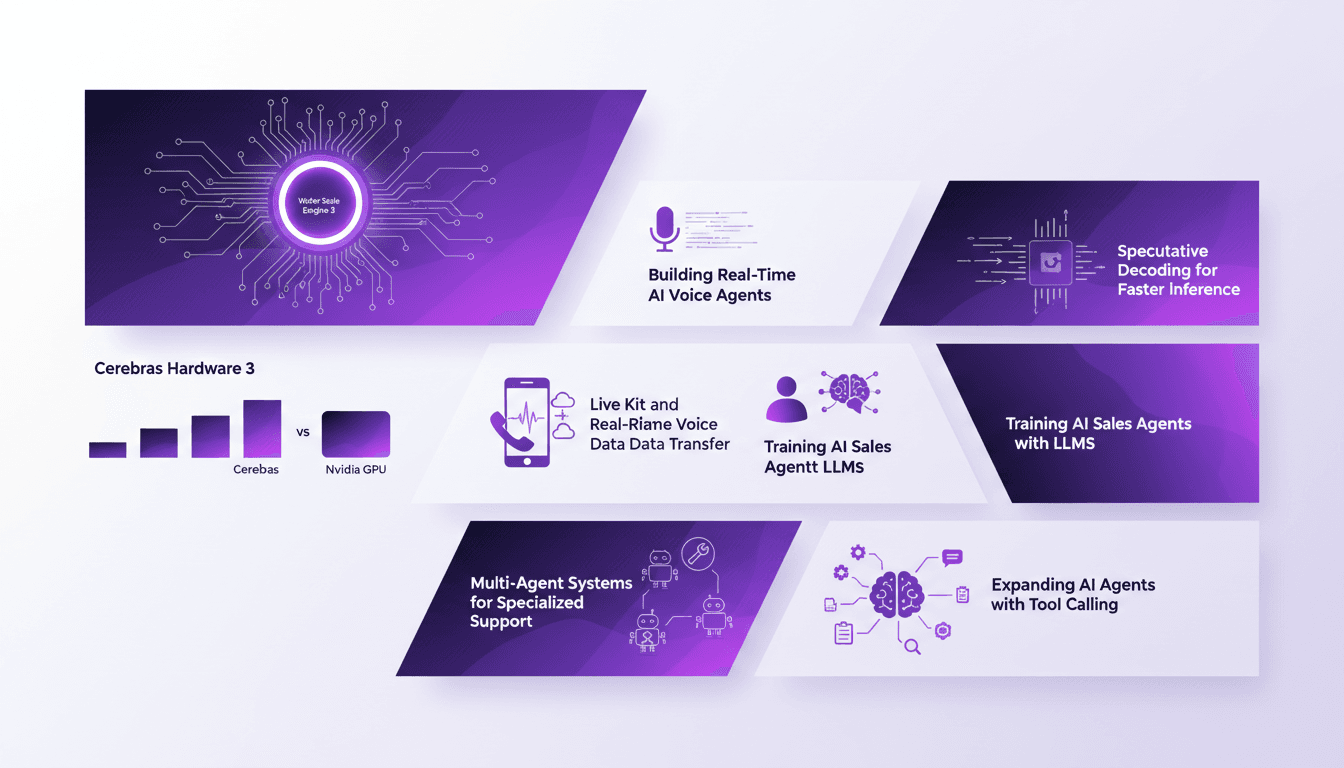

Construire un Agent AI en Temps Réel avec Cerebras

Je me souviens encore de la première fois où j'ai connecté un système Cerebras à mon workflow AI. La vitesse était époustouflante, mais j'ai vite compris que ce n'était pas qu'une question de vitesse. Il s'agit d'orchestrer efficacement chaque élément, du décodage spéculatif au transfert de données vocales en temps réel. Avec le Wafer Scale Engine 3 de Cerebras, on repousse les limites de l'inférence AI et des applications en temps réel. Dans cet article, je vous emmène dans les coulisses de la construction d'un agent de vente AI en temps réel, utilisant du matériel Cerebras, en comparant notamment avec les GPU Nvidia. On décode ensemble comment le décodage spéculatif et la technologie Live Kit transforment l'expérience utilisateur. Accrochez-vous, car on va parler de comment entraîner des agents de vente AI avec des LLMs et développer des systèmes multi-agents pour un support spécialisé. C'est parti !

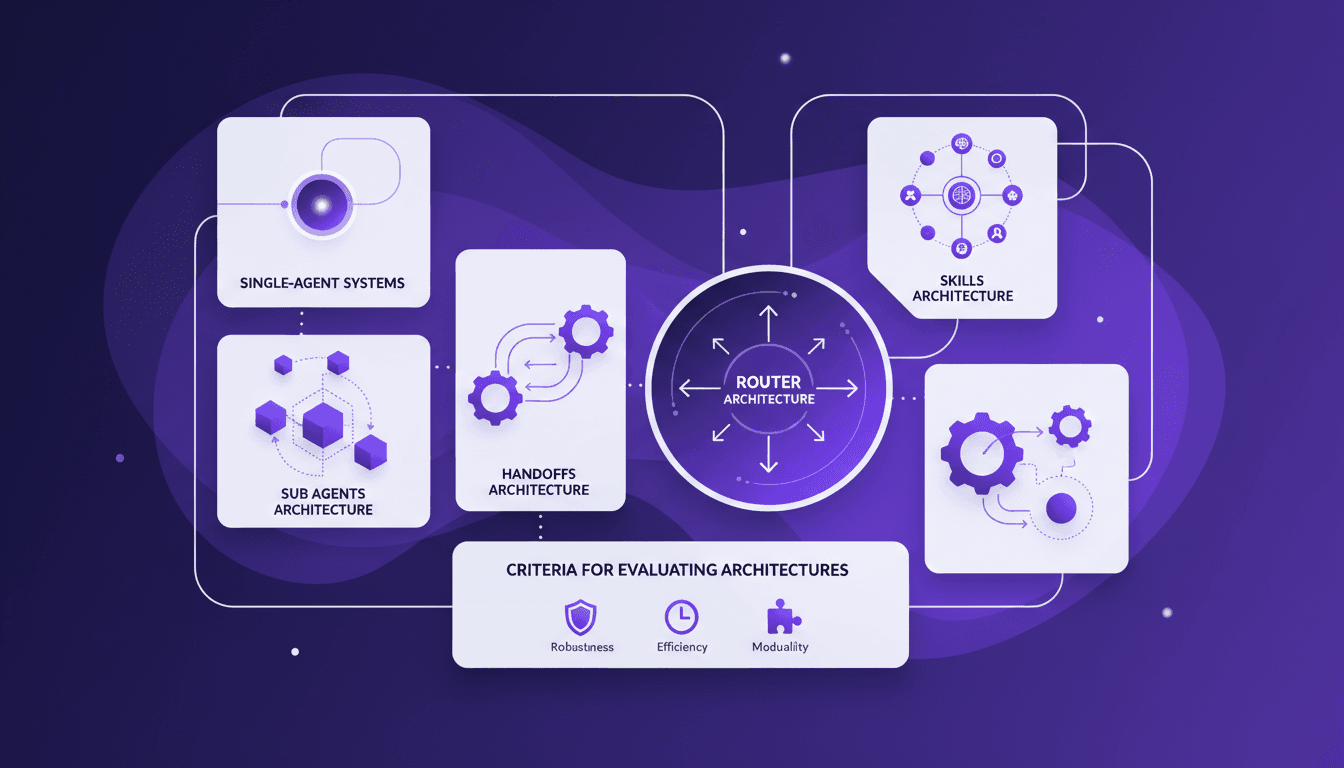

Architecture multi-agents : guide pratique

Je me souviens de la première fois où j'ai essayé d'implémenter un système multi-agents. J'étais submergé par le choix des architectures. Après quelques erreurs, j'ai finalement trouvé un workflow qui fonctionne. Parlons de comment vous pouvez choisir la bonne architecture sans maux de tête. Les systèmes multi-agents peuvent vraiment transformer la façon dont nous gérons des tâches complexes. Avec la bonne architecture, on peut distribuer efficacement la charge de travail et améliorer l'interaction. Mais attention, choisir la mauvaise peut vite devenir un cauchemar en termes d'efficacité et de scalabilité. Dans cet article, je partage mes expériences avec les architectures d'agents secondaires, de handoffs, de compétences et de routeurs. On discutera aussi des critères d'évaluation des architectures et pourquoi il peut être judicieux de commencer par un système mono-agent. Je vous partage mes erreurs et mes réussites pour que vous puissiez éviter les pièges. Prêt à plonger ?

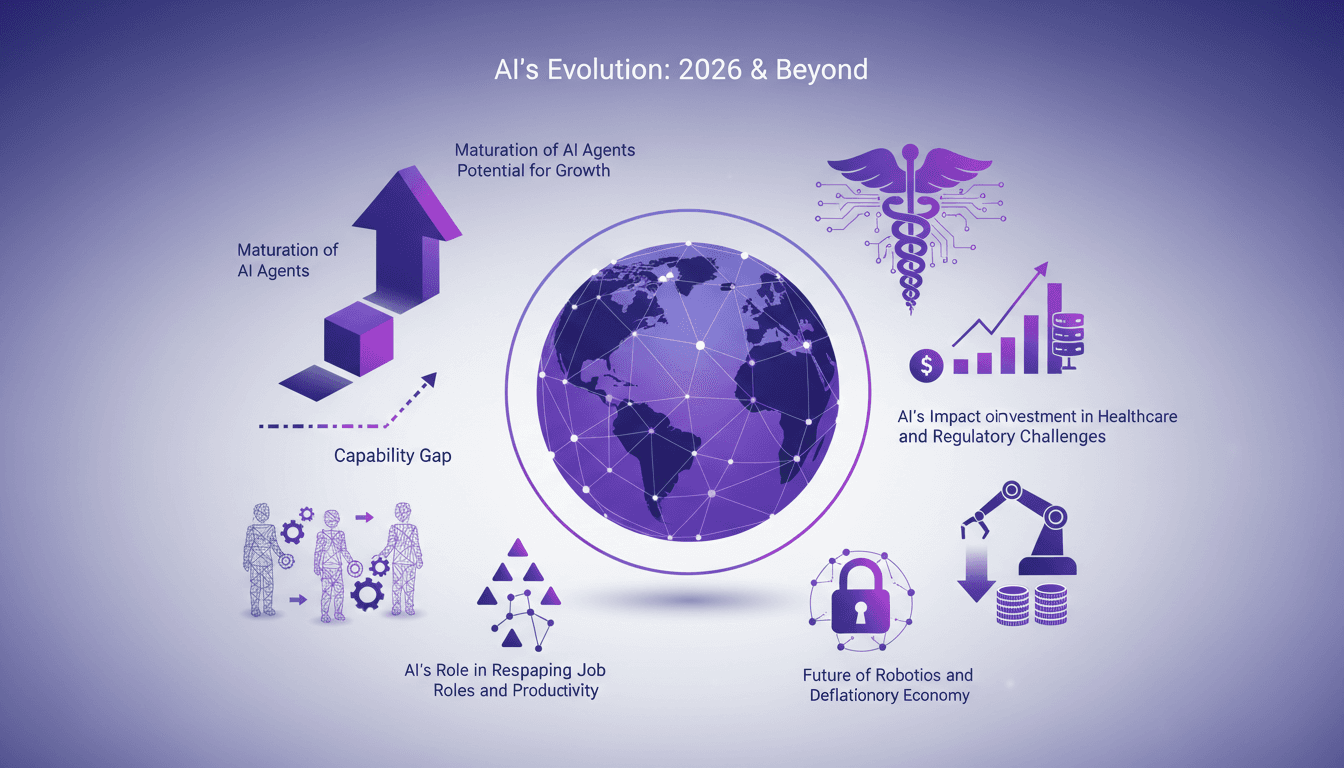

Maturation des agents IA et systèmes d'ici 2026

J'ai vu l'IA évoluer, passant de simples scripts à des systèmes complexes. Je me suis souvent retrouvé à orchestrer des solutions avec des agents qui, soyons francs, n'étaient pas toujours à la hauteur. Mais là, on parle de 2026, et je sens que quelque chose de grand se prépare. Les systèmes multi-agents se raffinent et leur impact se fait sentir dans des domaines concrets comme la santé et les startups. On doit aussi parler des investissements colossaux d'OpenAI en capacité de calcul et des défis réglementaires à venir. En tant que bâtisseur, je vois des opportunités pour nous, surtout pour les startups qui veulent se tailler une place dans cet écosystème en pleine mutation. Accrochez-vous, car les agents d'IA arrivent avec une force de frappe qui va redéfinir la productivité et les rôles au travail.

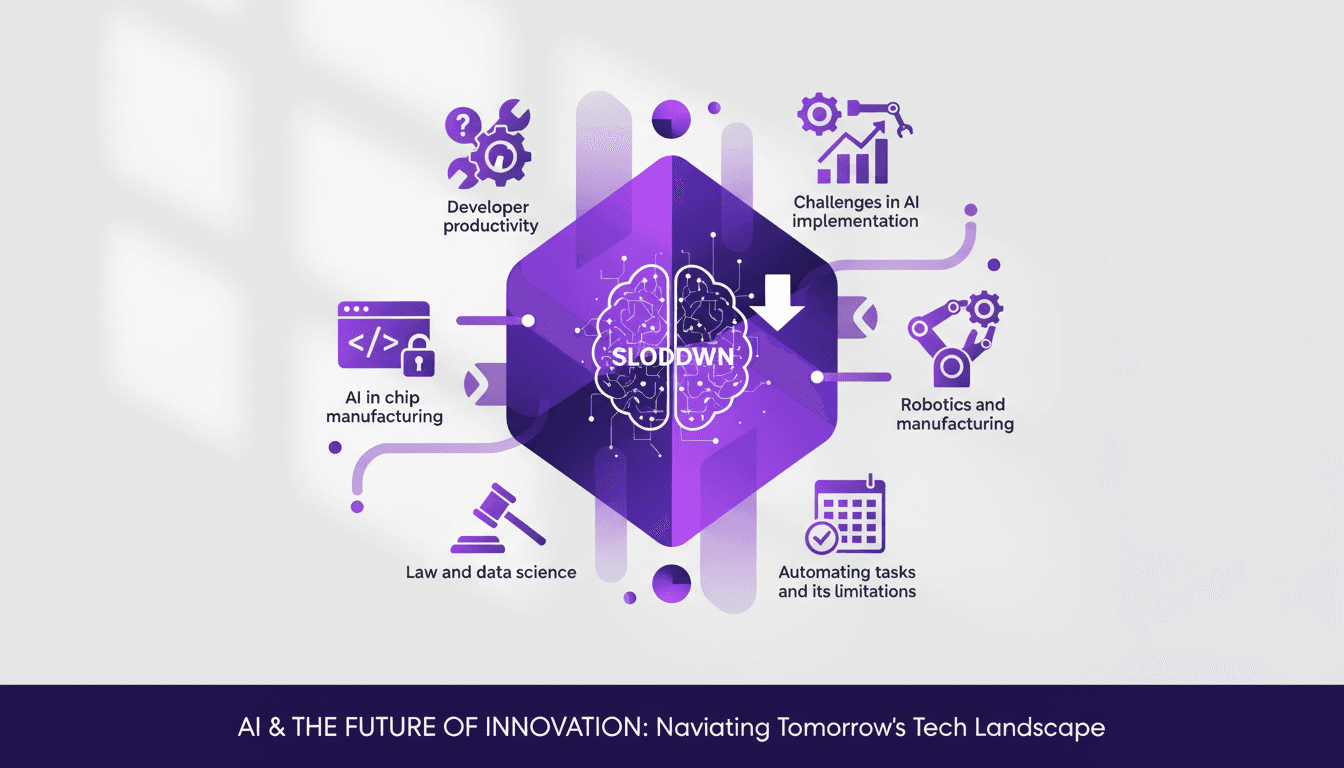

Mesurer Productivité Dev avec METR: Défis

J'ai passé des heures à essayer de quantifier la productivité des développeurs, et quand j'ai entendu Joel Becker parler de METR, ça m'a frappé. La manière dont METR mesure les 'Long Tasks' et la productivité des développeurs open source est un vrai changement de jeu. À l'approche de 2030, on parle de plafonnement potentiel de la croissance du calcul. Comprendre comment on mesure et améliore la productivité devient crucial. METR propose une perspective unique pour relever ces défis, en particulier dans les environnements open source. C'est fascinant de voir comment l'IA peut transformer notre façon de travailler, bien qu'elle ait ses limites, notamment dans la gestion du code hérité. Mais attention, ne surutilisez pas l'IA pour automatiser chaque tâche. Elle a encore du chemin à faire, surtout en robotique et en fabrication. Joel nous montre comment naviguer dans ce paysage complexe, en mettant en lumière l'impact de la familiarité des outils sur la productivité. Plongeons dans ces insights qui peuvent réellement transformer nos workflows.

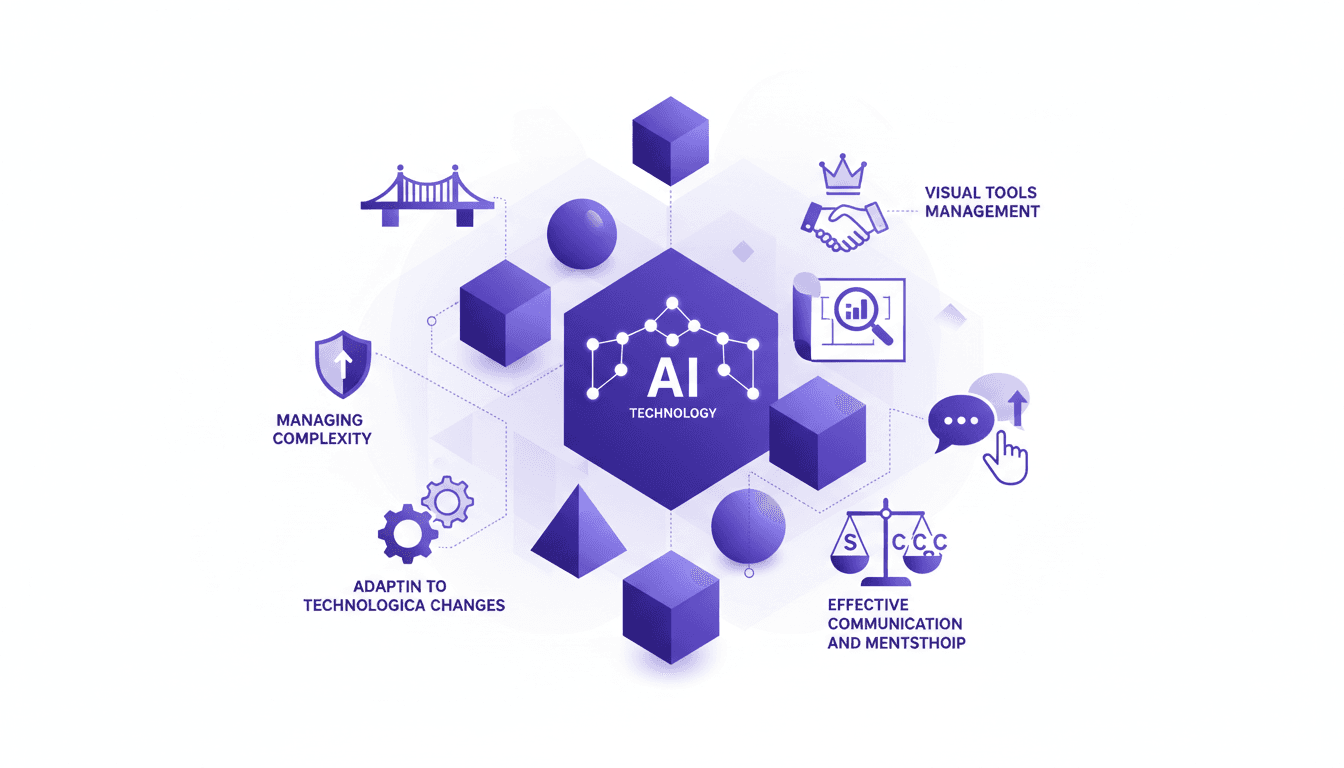

Architecte Logiciel : Gérer la Complexité

Je me rappelle la première fois que j'ai été plongé dans l'architecture logicielle, c'était un vrai chaos. Mais c'est là que j'ai compris que l'important n'est pas de connaître chaque détail, mais de savoir gérer la complexité et prendre des décisions éclairées. Dans cet article, je vais vous guider à travers les éléments essentiels d'une architecture logicielle efficace, en partageant des leçons tirées de mon expérience et d'experts du secteur comme Gregor Hohpe. On parlera des caractéristiques des bons architectes, de la gestion des risques, et de l'importance des outils visuels. Vous découvrirez aussi comment s'adapter aux changements technologiques et pourquoi la communication et le mentorat sont cruciaux.