TTS Ultra Rapide sur CPU: Clonage Vocal 2026

Je me souviens encore de ma première tentative avec un modèle de synthèse vocale sur mon CPU grand public. C'était lent, frustrant, comme un retour vers le passé. Mais le modèle TTH a changé la donne. Imaginez atteindre des performances TTS ultra-rapides sur un matériel standard, avec en prime un clonage vocal bluffant. Dans cet article, je vous guide à travers cette innovation de 2026 : de la configuration technique aux comparaisons avec d'autres modèles, et comment vous pouvez intégrer cela dans vos projets. Si vous êtes développeur ou simplement un passionné, vous allez vouloir voir ça.

Je me souviens de la première fois où j'ai essayé de faire tourner un modèle de synthèse vocale sur mon CPU de consommation. C'était lent, une frustration totale, et je me sentais coincé dans le passé. Puis est arrivé le modèle TTH. D'un coup, tout a changé. Imaginez, en 2026, vous pouvez obtenir des performances de synthèse vocale ultra-rapides même sur un matériel standard. Et ce n'est pas tout, le clonage vocal est aussi de la partie. Dans cette vidéo, je vais vous montrer comment configurer ce modèle de 100 millions de paramètres, et vous verrez comment il surpasse tout ce que j'ai pu tester auparavant. On va ensemble comparer avec d'autres modèles, voir comment ça marche en temps réel sur un CPU. Et, attention, ça décoiffe ! Vous allez enfin pouvoir intégrer ces capacités dans vos projets, sans vous ruiner en matériel. Alors, prêt à transformer votre façon de penser le TTS ?

Commencer avec le modèle TTH Text-to-Speech

Quand j'ai découvert le modèle TTH de text-to-speech (TTS) qui fonctionne sur un CPU grand public, j'ai su que quelque chose de spécial se passait. Ce modèle de 100 millions de paramètres, proposé par la société QTI, est un véritable game changer pour ceux d'entre nous qui n'ont pas accès à un GPU. La configuration initiale est assez simple, mais attention aux pièges courants qui peuvent vous ralentir.

Pour commencer, assurez-vous d'avoir un CPU comme un Intel Core ultra 7 ou un Apple M3. Vous aurez besoin des droits d'accès à l'API Hugging Face, mais une fois cela fait, le modèle est prêt à l'emploi. La première fois que j'ai lancé le modèle, j'ai été impressionné par sa vitesse et sa précision. Néanmoins, faites attention à ne pas trop solliciter votre CPU, surtout si vous travaillez avec d'autres applications gourmandes en ressources.

"Ce modèle est extrêmement rapide et peut faire du gros travail sans faire appel à un GPU."

Exécution efficace du TTS sur CPU grand public

Pour exécuter le TTH sur du matériel grand public, suivez ces étapes. Tout d'abord, téléchargez et installez Pocket TTS en utilisant pip ou uvicorn. Personnellement, je préfère uvicorn pour sa rapidité. Ensuite, chargez le modèle TTS depuis Pocket TTS. Là où ça se complique, c'est l'initialisation de l'état vocal. Assurez-vous de conditionner le modèle sur une voix, sinon vous rencontrerez des erreurs.

J'ai comparé ce modèle à d'autres, y compris des modèles de 750 millions de paramètres, et le TTH se démarque clairement pour son efficacité sur CPU. Lors des tests réels, j'ai pu traiter des clips de 43 secondes et 44 secondes presque instantanément. Cependant, ce que vous gagnez en vitesse, vous le perdez peut-être en nuances vocales. Il est crucial de trouver le bon équilibre entre rapidité et qualité sonore.

- Installer Pocket TTS avec uvicorn pour plus de rapidité

- Conditionner le modèle sur une voix pour éviter les erreurs

- Équilibrer rapidité et qualité sonore

Accéder et utiliser Pocket TTS

L'accès à Pocket TTS est facile et peut être intégré dans votre flux de travail rapidement. Que ce soit via l'interface en ligne de commande (CLI) ou le mode serveur, les options ne manquent pas. Utiliser Pocket TTS pour un déploiement rapide est un vrai avantage, surtout si vous avez besoin d'une solution TTS immédiate sur votre ordinateur local.

La configuration technique est simple, mais attention aux éventuels défis. Par exemple, assurez-vous que votre installation pip est à jour pour éviter des incompatibilités. Dans mon expérience, Pocket TTS excelle dans les cas d'utilisation pratiques comme la lecture de podcasts ou la création de livres audio.

- Intégration facile via CLI ou mode serveur

- Déploiement rapide pour des solutions TTS immédiates

- Vérifier que pip est à jour pour éviter des incompatibilités

Explorer les capacités de clonage vocal

Le clonage vocal est l'un des aspects les plus fascinants du modèle TTH. Avec ses 100 millions de paramètres, il supporte le clonage vocal sur CPU, ce qui est une prouesse technique. Pour configurer le clonage vocal, commencez par sélectionner une voix de base sur laquelle le modèle peut se conditionner.

Les performances en temps réel sont impressionnantes, mais il y a des limites. Si vous privilégiez la qualité, vous devrez peut-être sacrifier la vitesse. Personnellement, j'ai trouvé que la configuration d'une voix de haute qualité nécessite un ajustement méticuleux des paramètres du modèle.

- Sélectionner une voix de base pour le conditionnement

- Ajuster les paramètres pour une qualité optimale

- Compromis entre qualité et vitesse

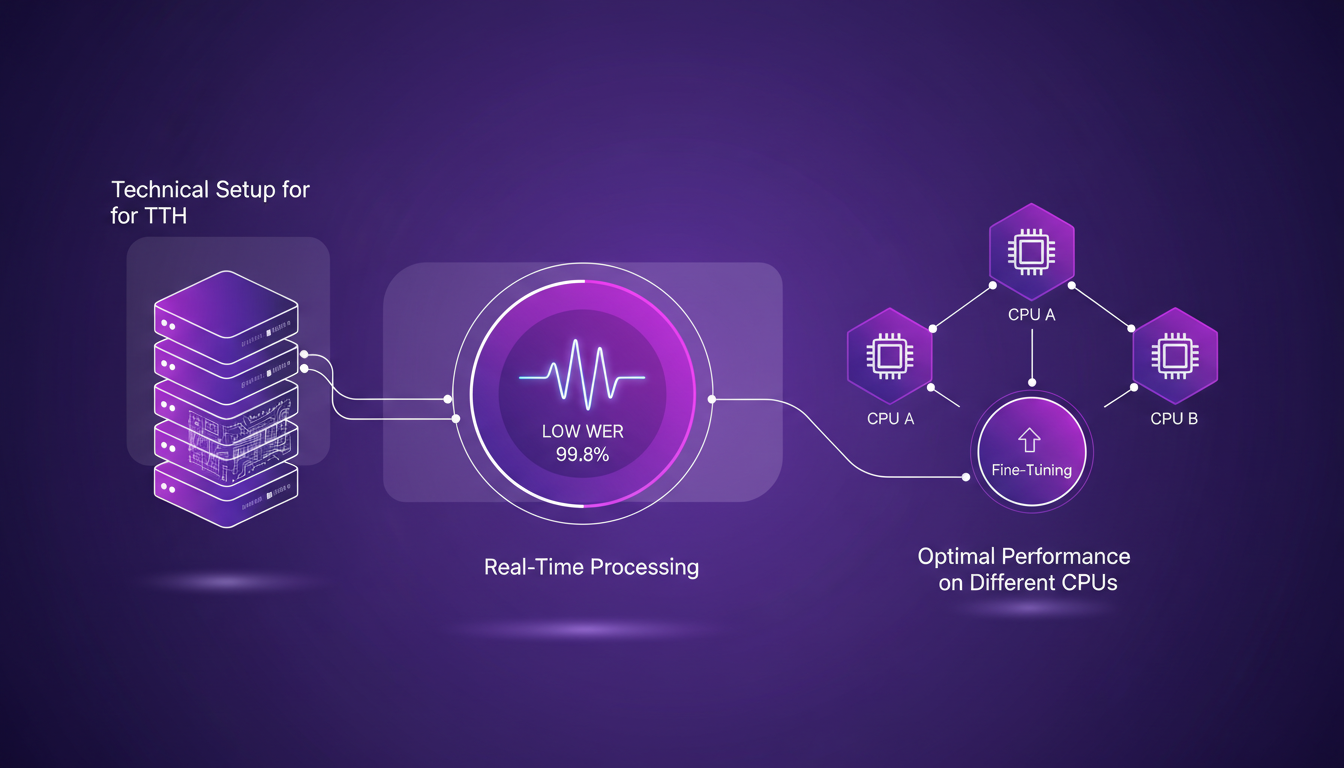

Configuration technique et performances en temps réel

La configuration technique du modèle TTH est une étape cruciale pour optimiser les performances en temps réel. Pour réduire le taux d'erreur de mots (word error rate), j'ai dû peaufiner certains réglages, notamment en ajustant les paramètres de qualité vocale en fonction du CPU utilisé.

Les erreurs courantes incluent des conflits de version logicielle et des erreurs de configuration de l'état vocal. Heureusement, la documentation technique de QTI est détaillée et facilite la résolution rapide de ces problèmes. Sur le plan des coûts, la performance du TTH par rapport à d'autres solutions est un atout majeur, surtout si votre budget est limité.

- Optimiser les paramètres pour réduire le taux d'erreur de mots

- Régler les conflits de version logicielle

- Documentation détaillée pour une résolution rapide des problèmes

- Équilibre entre performance et budget

Pour ceux qui recherchent une solution TTS performante sur leur ordinateur personnel, le modèle TTH est une option de choix. Avec sa capacité à fonctionner en temps réel sur un CPU, il ouvre de nouvelles possibilités pour les développeurs et les créateurs de contenu. Mais comme toujours dans la technologie, gardez à l'esprit les compromis entre vitesse, qualité et coût.

Avec le modèle TTH, j'ai découvert que faire tourner du texte-à-parole sur des CPU grand public n'est pas seulement possible, c'est aussi efficace et pratique. Premier point, le modèle de 100 millions de paramètres offre une solution complète, de la configuration rapide au clonage de voix. Ensuite, la durée de traitement est impressionnante : 43 secondes pour un clip de même durée, et 44 secondes pour un clip d'une seconde de plus. Comparé à d'autres modèles, TTH se distingue vraiment en termes d'efficacité sur du matériel que nous avons déjà tous sous la main. Mais attention, le clonage de voix peut nécessiter un peu plus de réglages pour obtenir une qualité optimale.

En regardant vers l'avenir, je vois le potentiel du modèle TTH pour transformer notre expérience TTS au quotidien. Prêt à révolutionner votre utilisation du texte-à-parole ? Plongez dans le modèle TTH et constatez la différence sur votre propre matériel. Pour une compréhension plus approfondie, je recommande de regarder la vidéo originale. Elle offre un aperçu précieux que vous ne voudrez pas manquer.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

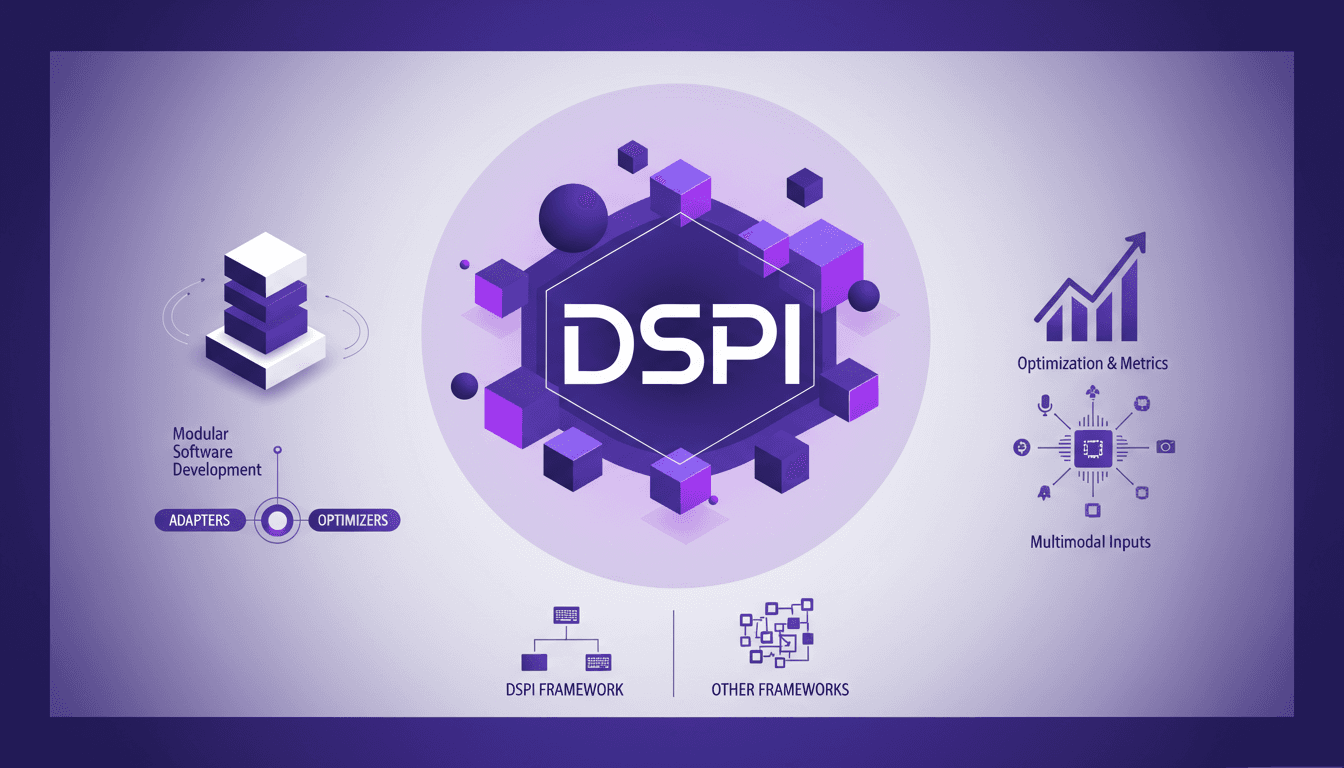

DSPI : Révolutionner l'Ingénierie de Prompt

J'ai plongé dans DSPI et croyez-moi, ce n'est pas juste un autre framework — c'est un véritable changement de jeu pour l'ingénierie de prompt. Au début, j'étais sceptique, mais en voyant son approche modulaire en action, j'ai réalisé le potentiel d'efficacité et de flexibilité. Avec DSPI, on simplifie les tâches complexes grâce à un cadre déclaratif, ce qui est une avancée majeure. Et cette modularité ? Elle permet une gestion optimisée des entrées, que ce soit des textes ou des images. Imaginez, pour une tâche de classification, seulement trois images suffisent pour obtenir des résultats précis. C'est cette capacité à gérer des entrées multimodales qui distingue DSPI des autres frameworks. Que ce soit pour le développement de logiciels modulaires ou l'optimisation des métriques, DSPI ne se contente pas de faire le travail, il le réinvente.

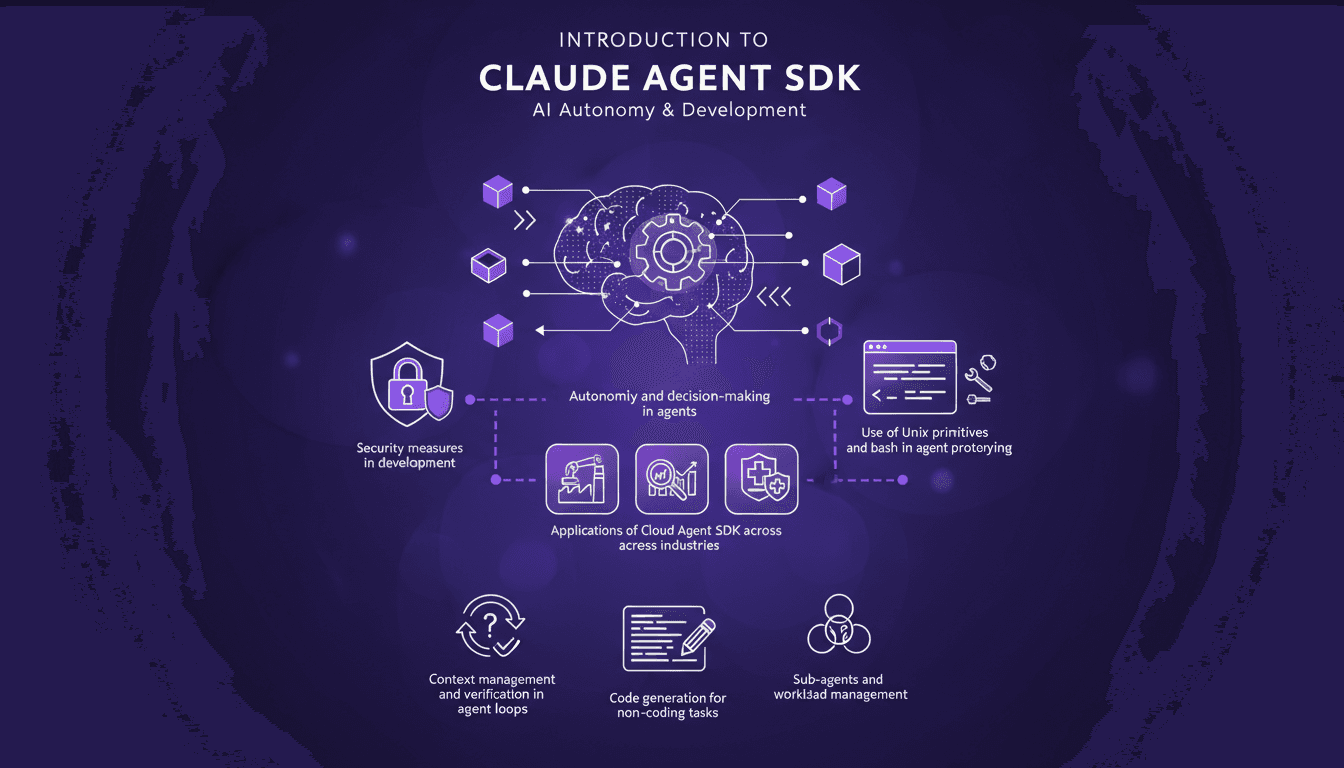

Maîtriser le SDK Claude Agent : Guide Pratique

Jamais essayé d'orchestrer une équipe de sous-agents avec des commandes Unix et vous sentiez que c'était comme rassembler des chats ? Je suis passé par là. Avec le SDK Claude Agent, j'ai enfin trouvé une méthode pour rationaliser la prise de décision et améliorer l'efficacité. Je vais vous montrer comment j'ai mis cela en place et les pièges à éviter. Le SDK Claude Agent promet autonomie et pouvoir décisionnel pour les agents dans divers secteurs. Son cadre robuste est révolutionnaire, mais uniquement si vous naviguez correctement dans ses complexités. Je connecte mes agents, je gère leur charge de travail et je sécurise l'ensemble avec des primitives Unix et du bash. Mais attention, il y a des limites à surveiller. Vous êtes prêt à plonger dans les détails ?

Robots et IA Physique : Révolutionner l'Industrie

J'ai passé des années à construire des robots, mais l'intégration de l'IA Physique a tout changé. Ce n'est pas seulement question de les rendre plus intelligents, c'est leur donner un sens du monde physique. Imaginez un robot qui perçoit la chaleur et qui réagit en conséquence. C'est exactement ce que j'ai réussi à orchestrer dans mes projets. Je vous emmène à travers ce voyage où l'IA Physique redéfinit notre manière de concevoir les robots, les rendant véritablement interactifs avec leur environnement.

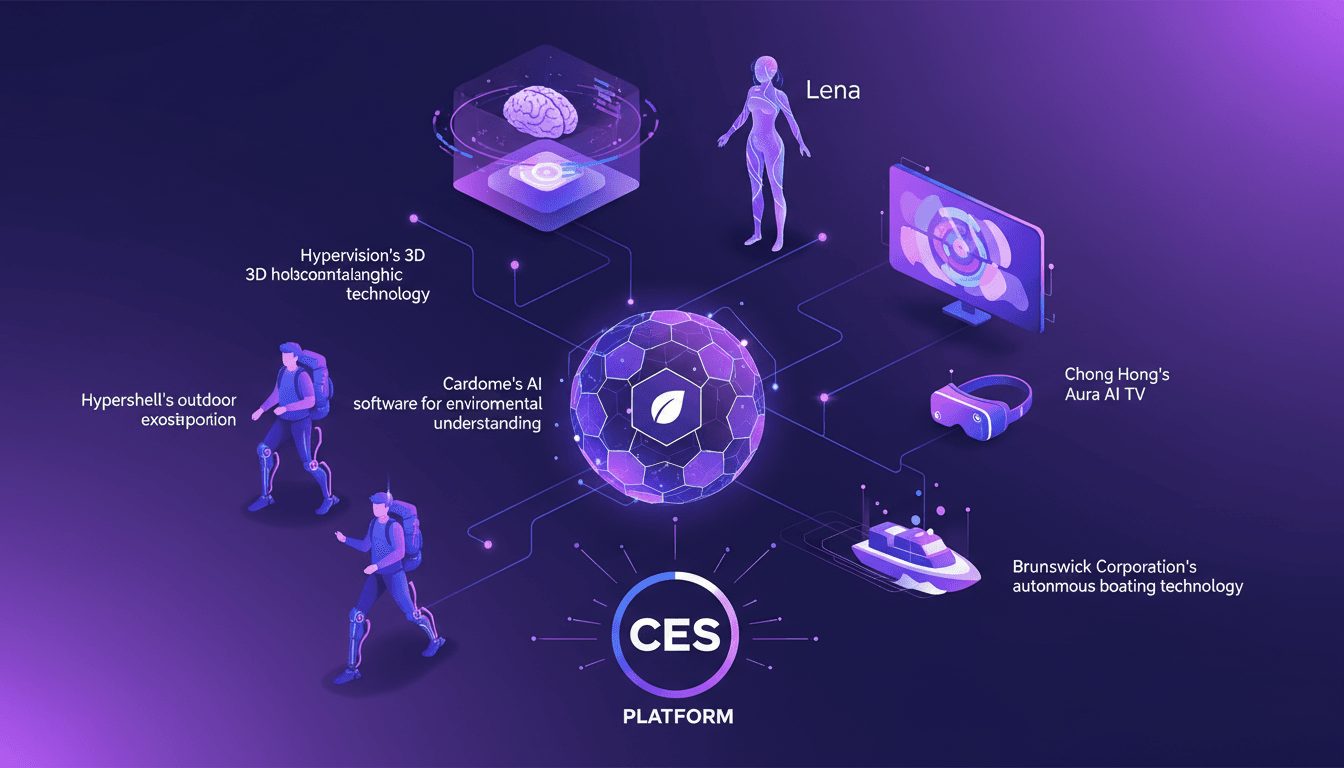

Technologies Révolutionnaires du CES 2026: Mon Expérience

Je suis entré au CES 2026 en m'attendant au bruit habituel des nouvelles technologies. Mais ce que j'ai découvert, c'est un éventail d'innovations prêtes à redéfinir nos vies quotidiennes. De Cardome avec son logiciel IA pour la compréhension environnementale à Hypervision et sa technologie holographique 3D couplée à l'assistante IA Lena, ce n'est pas de la science-fiction. Chong Hong nous plonge dans une nouvelle dimension avec son Aura AI TV et ses expériences VR, tandis que Hypershell offre un exosquelette pour l'aventure en plein air. Et n'oublions pas Brunswick Corporation, qui propulse la navigation autonome à un tout autre niveau. CES, c'est le podium où ces technologies ne sont pas juste des concepts, mais des disruptions prêtes à s'imposer.

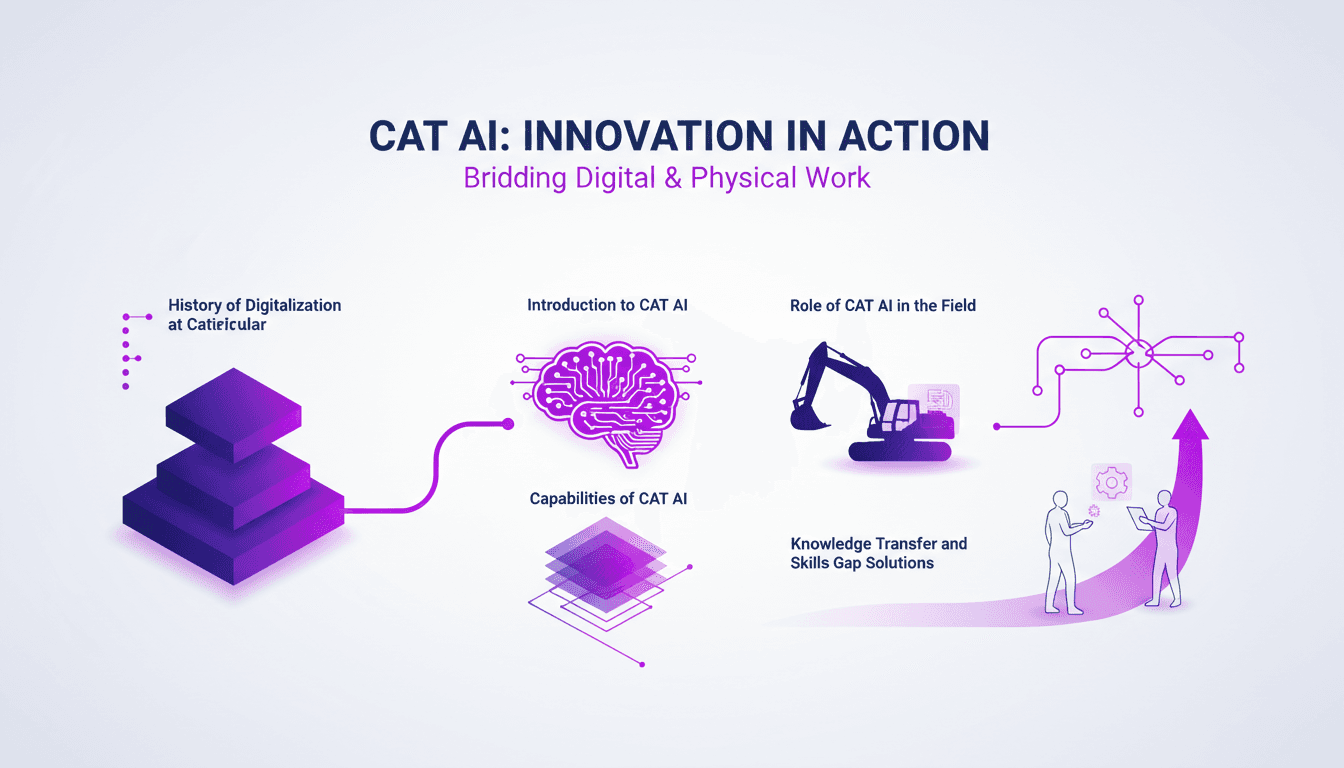

Digitalisation chez Caterpillar : Révolution Chantier

J'ai passé assez de temps sur les chantiers pour sentir les secousses de la digitalisation. Quand Caterpillar a commencé à intégrer l'IA, j'étais sceptique. Mais en voyant CAT AI à l'œuvre, j'ai compris comment ça comble le fossé entre la connaissance et l'exécution. Cette révolution ne se limite pas à de nouvelles technologies ; elle redéfinit notre manière de travailler. On va plonger dans l'histoire de la digitalisation chez Caterpillar, découvrir CAT AI, ses capacités, et son rôle sur le terrain. Et surtout, comment il fusionne les environnements numériques et physiques, et résout les défis de transfert de connaissances et d'écart de compétences.