Gemini RAG : Optimisation de la recherche de fichiers

Cette semaine, j'ai plongé dans Gemini RAG, et franchement, c'est un vrai game changer pour la recherche de fichiers. Que ce soit des PDFs, des fichiers de code ou des JSON, je peux maintenant les gérer efficacement. Mais attention aux limites de stockage ! Avec la version 3.0 de Gemini, on a enfin un outil qui simplifie le traitement et l'intégration des documents. Je vais vous expliquer comment je l'ai configuré et les pièges à éviter. De la gestion des recherches à la tarification, en passant par des fonctionnalités avancées comme le découpage personnalisé et les métadonnées, on va tout passer en revue. Préparez-vous à optimiser vos processus de recherche de fichiers comme jamais auparavant.

Cette semaine, je me suis plongé dans Gemini RAG, et je peux vous dire que c'est un vrai bouleversement pour la recherche de fichiers. Imaginez gérer efficacement des PDFs, des fichiers de code, du texte en markdown, des journaux, et même des fichiers JSON. Mais attention, il y a des limites de stockage auxquelles vous devrez faire face. Avec l'introduction de Gemini 3.0, j'ai découvert une fonctionnalité qui a vraiment capté mon attention. En tant que quelqu'un qui manipule une variété de types de documents, pouvoir les traiter et les intégrer avec une telle facilité, c'est crucial. Je vais vous montrer comment je l'ai configuré, les erreurs que j'ai évitées et celles qui m'ont coûté du temps (et un peu de patience !). On va décortiquer la gestion des recherches, le stockage, les niveaux de tarification, et les fonctionnalités avancées comme le découpage personnalisé et les métadonnées. Prêt à optimiser votre gestion de fichiers ? Allons-y !

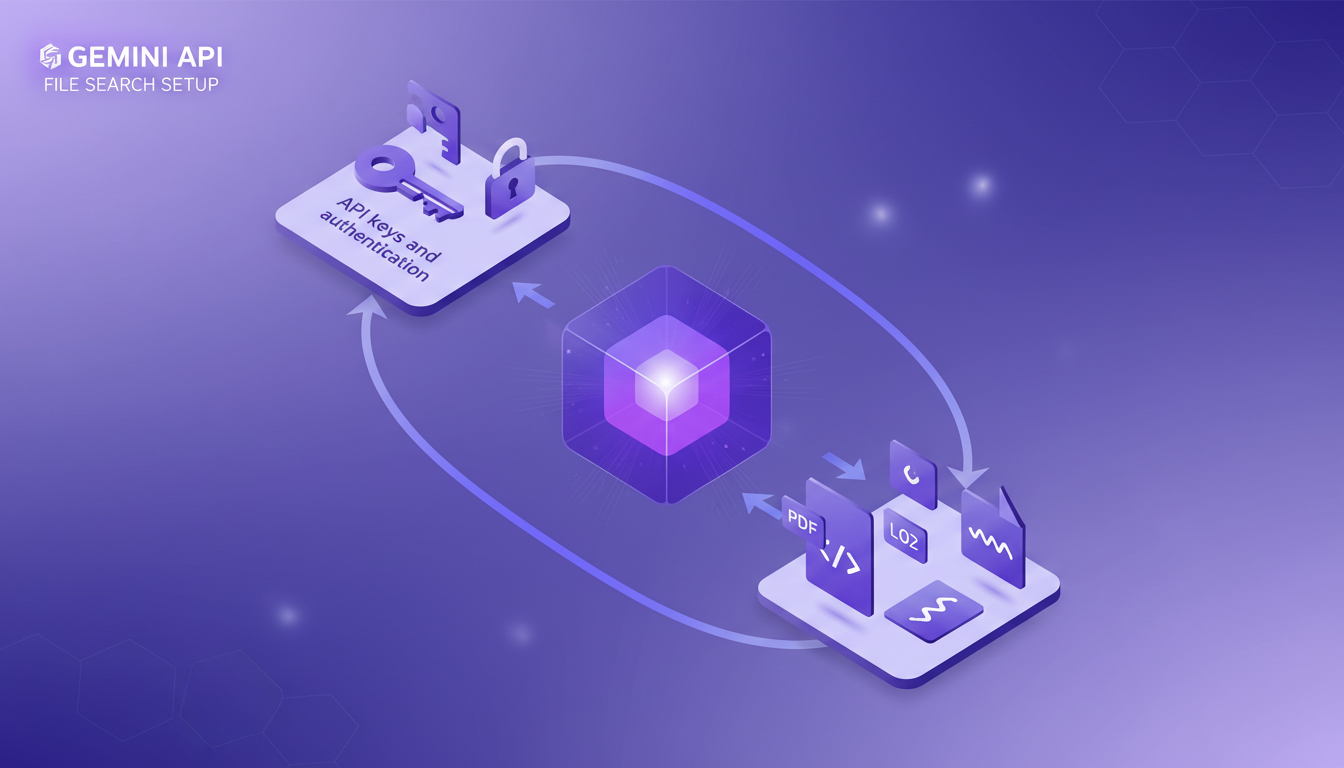

Installation de l'API Gemini pour la recherche de fichiers

Installer l'API Gemini pour la recherche de fichiers, c'est un peu comme déballer un nouveau gadget. Excitant, mais il faut être méthodique. D'abord, j'ai configuré mes clés API et mis en place l'authentification. Un jeu d'enfant, me suis-je dit, jusqu'à ce que je me fasse avoir par les limites de taille de fichier. Oui, il faut faire attention, car chaque document ne peut pas dépasser 100 mégaoctets. C'est grand mais, croyez-moi, ça peut surprendre quand on travaille avec des fichiers volumineux.

Puis, j'ai commencé à télécharger différents types de documents : PDFs, code, fichiers markdown, logs, et fichiers JSON. La documentation est utile, mais il faut parfois tâtonner. Par exemple, la gestion des métadonnées est cruciale mais pas toujours intuitive. On se retrouve vite à jongler avec les champs pour optimiser la recherche.

Traitement et intégration des documents

L'intégration des documents avec Gemini est robuste. J'ai utilisé les embeddings pour améliorer la précision de mes recherches. Chaque document est découpé en morceaux, et là, attention à la taille des morceaux ! J'ai dû expérimenter avec des tailles de découpage personnalisées pour ne pas ralentir le traitement. C'est un peu comme couper un gâteau, trop de parts peuvent rendre le service lent.

En ajoutant des tags de métadonnées, j'ai vu des améliorations significatives dans les temps de récupération. Cependant, il ne faut pas abuser des métadonnées, sinon on risque de se perdre dans la complexité.

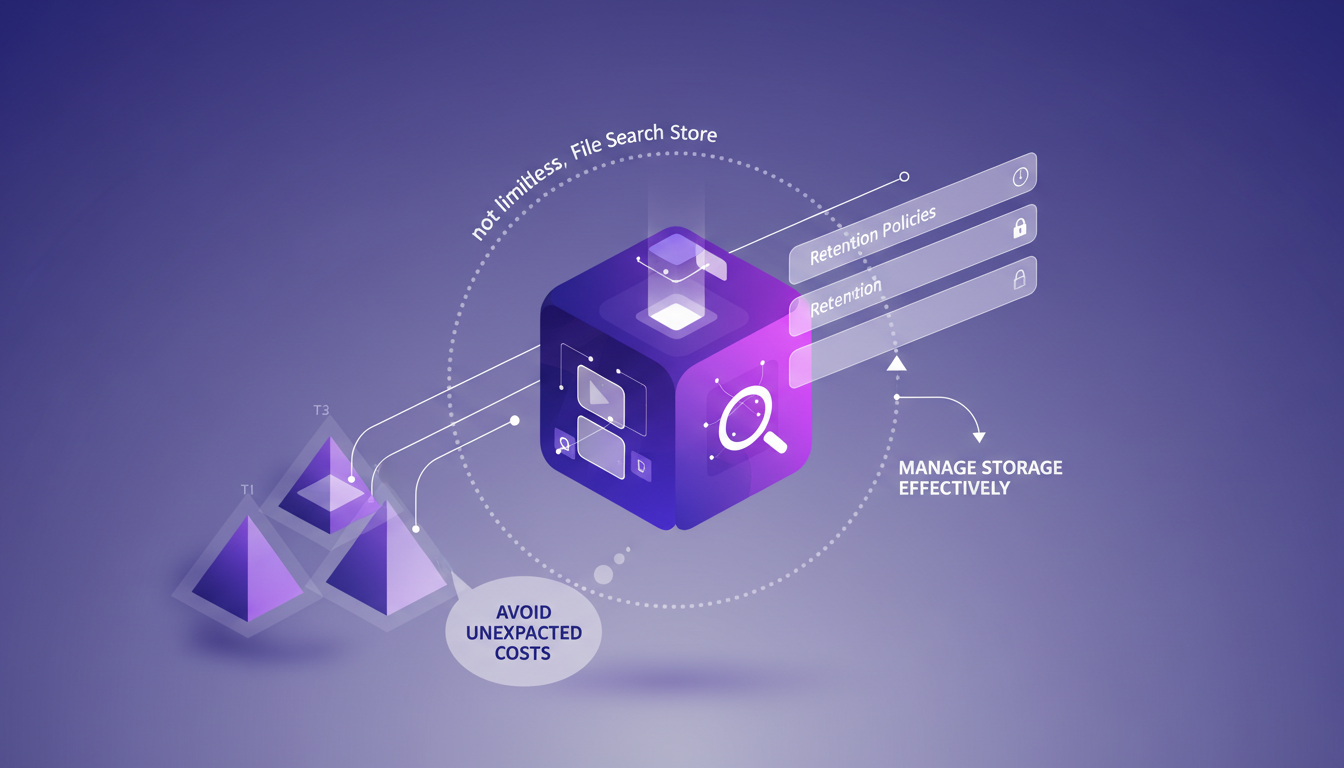

Gestion du stockage et de la rétention des fichiers

La magie de la recherche de fichiers se passe dans le file search store. Mais attention, ce n'est pas illimité. J'ai mis en place des politiques de rétention pour gérer efficacement le stockage. Un bon conseil : comprendre les paliers de tarification pour éviter de mauvaises surprises sur votre facture.

Optimiser le stockage nécessite des nettoyages réguliers et de l'archivage. Trouver l'équilibre entre coût et performance est essentiel. J'ai appris à mes dépens que laisser traîner des fichiers inutilisés peut vite devenir coûteux.

Fonctionnalités avancées : découpage personnalisé et métadonnées

Le découpage personnalisé est un outil puissant pour adapter le traitement des documents à mes besoins. En jouant avec les métadonnées, j'ai pu améliorer la pertinence des recherches. Mais ces fonctionnalités peuvent être à double tranchant. Trop de découpage ou de métadonnées peut rendre le système complexe.

J'ai trouvé un juste milieu en équilibrant la taille des morceaux et la richesse des métadonnées. Parfois, moins, c'est plus, surtout quand on veut garder un système réactif.

Cas d'utilisation et applications pratiques

Le Gemini RAG brille dans les projets nécessitant une gestion diversifiée des documents. Je l'ai appliqué à la gestion de contenu et à la documentation de code. Sa flexibilité permet de l'adapter à de nombreux secteurs, comme la recherche de documents juridiques ou l'analyse de données.

Pour maximiser les bénéfices, il est crucial de considérer les besoins spécifiques de votre projet. Le potentiel est immense, mais il faut savoir l'exploiter judicieusement.

En conclusion, l'API Gemini et son outil de recherche de fichiers offrent un potentiel énorme pour simplifier et optimiser le traitement des documents. Mais attention à bien comprendre ses limites et à l'utiliser de manière réfléchie.

Gemini RAG a révolutionné ma façon de gérer les recherches de fichiers. D'abord, je configure l'API Gemini pour traiter et intégrer divers documents, des PDFs au code, en passant par les fichiers markdown et JSON. C'est vraiment un grand pas en avant, mais attention aux limites de stockage et de traitement. Ensuite, je gère le stockage des recherches de fichiers avec soin pour éviter toute surcharge. Le modèle de tarification de Gemini est intéressant, mais nécessite une gestion rigoureuse pour rester rentable. Enfin, l'introduction de la version 3.0 cette semaine a apporté des fonctionnalités vraiment cool, mais il faut veiller à ne pas dépasser les limites de la plateforme. En regardant vers l'avenir, les applications potentielles s'élargissent à mesure que j'affine mon utilisation. Prêt à optimiser vos recherches de fichiers avec Gemini RAG ? Plongez-y, mais gardez un œil sur vos limites de stockage et de traitement. Partagez vos expériences et apprenons ensemble. Pour plus de détails et une compréhension approfondie, je vous recommande de regarder la vidéo originale ici : https://www.youtube.com/watch?v=MuP9ki6Bdtg

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

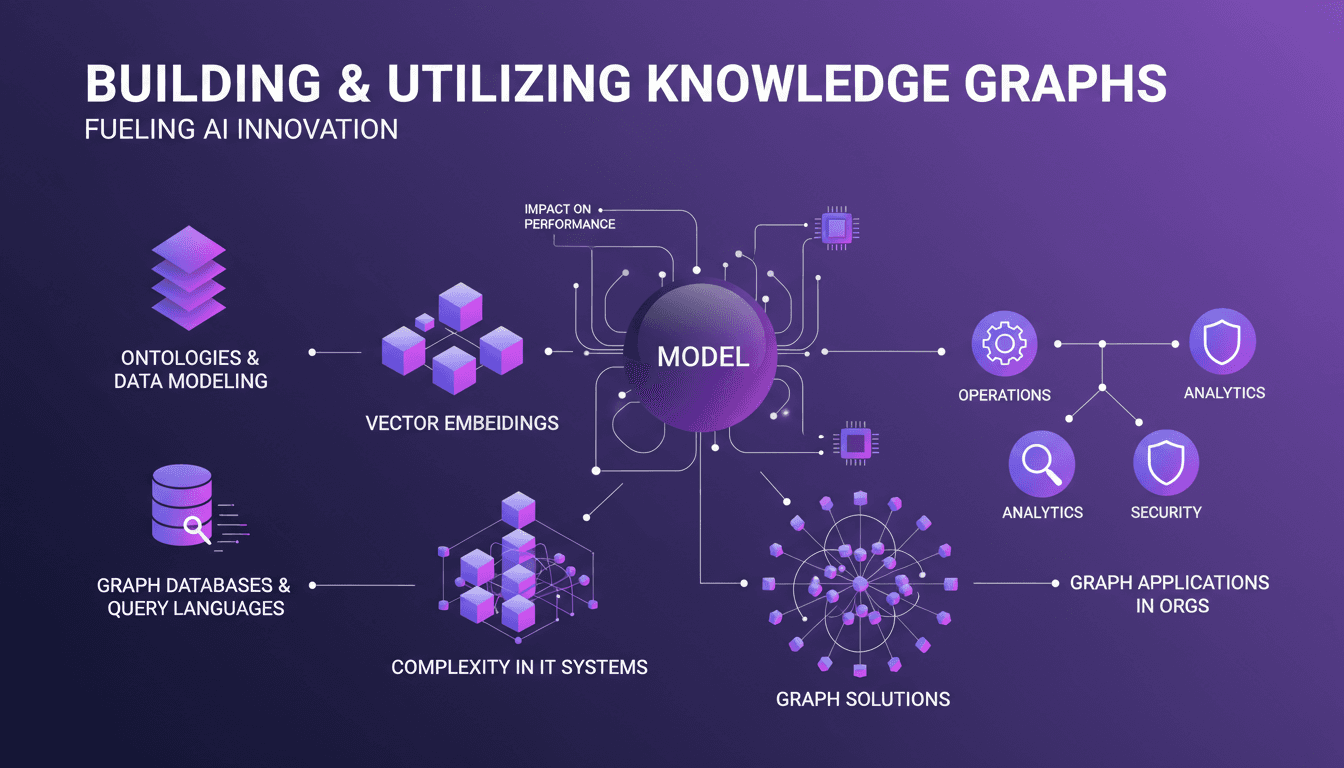

Construire des Graphes de Connaissance: Guide Pratique

Je me souviens encore de la première fois où je suis tombé sur le concept des graphes de connaissance. C'était comme découvrir une arme secrète pour organiser les données. Mais alors, les complexités ont commencé. Naviguer dans le labyrinthe des structures de graphes n'est pas une mince affaire. Pourtant, quand je connecte les points, l'impact sur les performances de mes modèles est indéniable. Les graphes de connaissance ne sont pas seulement des outils puissants, ils sont presque indispensables dans un monde où la gestion de systèmes informatiques complexes est la norme. Attention cependant, ne sous-estimez pas la courbe d'apprentissage. Dans cet article, je vous montre comment j'ai apprivoisé ces outils et comment vous pouvez les intégrer efficacement dans vos projets.

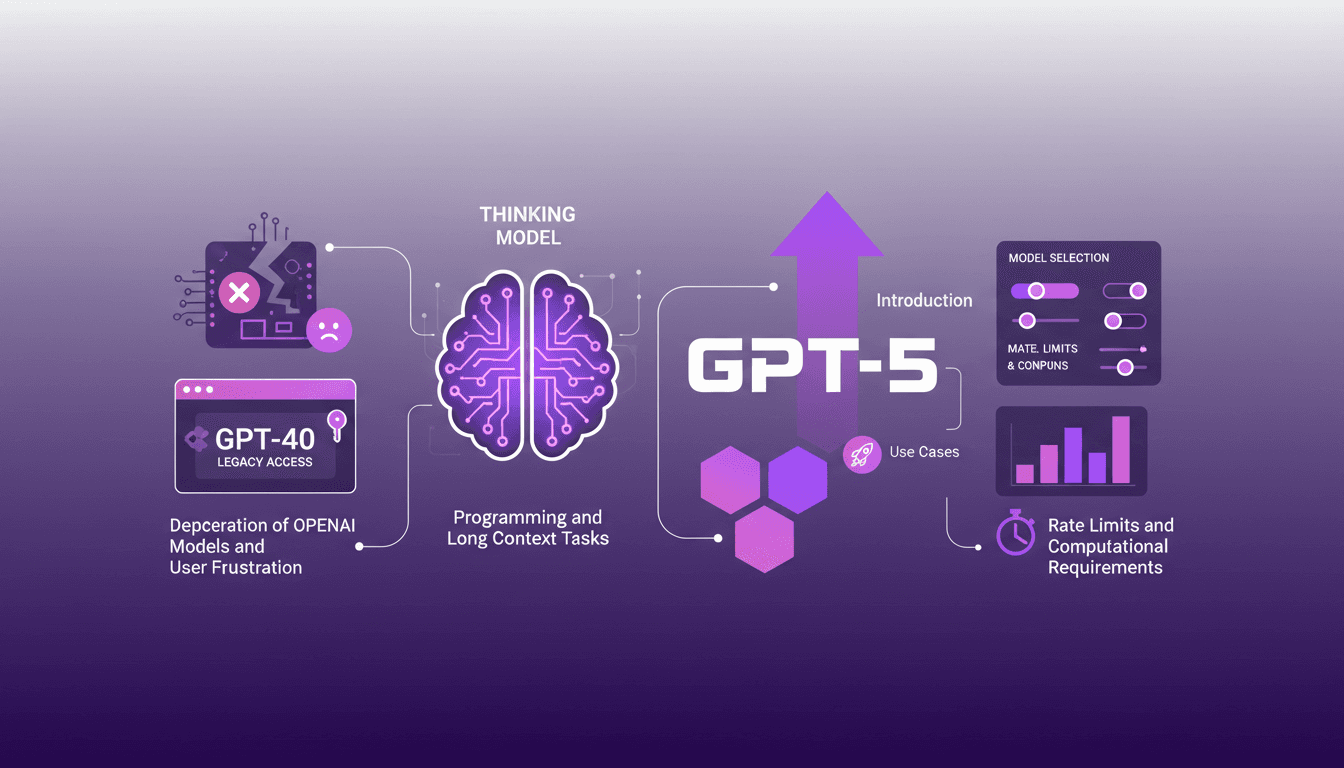

Accéder à GPT-40 sur ChatGPT : Astuces Pratiques

Je me souviens du jour où OpenAI a annoncé la dépréciation de certains modèles. La frustration était palpable parmi nous, utilisateurs, y compris moi-même. Mais j'ai trouvé une manière de naviguer dans ce chaos, en accédant aux modèles hérités comme le GPT-40 tout en adoptant le tout nouveau GPT-5. Dans cet article, je partage comment j'ai orchestré cela. Avec les mises à jour rapides d'OpenAI, rester à jour peut ressembler à un exercice d'équilibriste. La dépréciation des anciens modèles et l'introduction de nouveaux comme le GPT-5 ont laissé beaucoup de gens perplexes. Mais avec la bonne approche, vous pouvez tirer parti de ces changements. Je vous explique comment accéder aux modèles hérités, les cas d'utilisation de GPT-5, et comment configurer vos options de sélection de modèle sur ChatGPT, tout en gardant un œil sur les limites de taux et les exigences computationnelles.

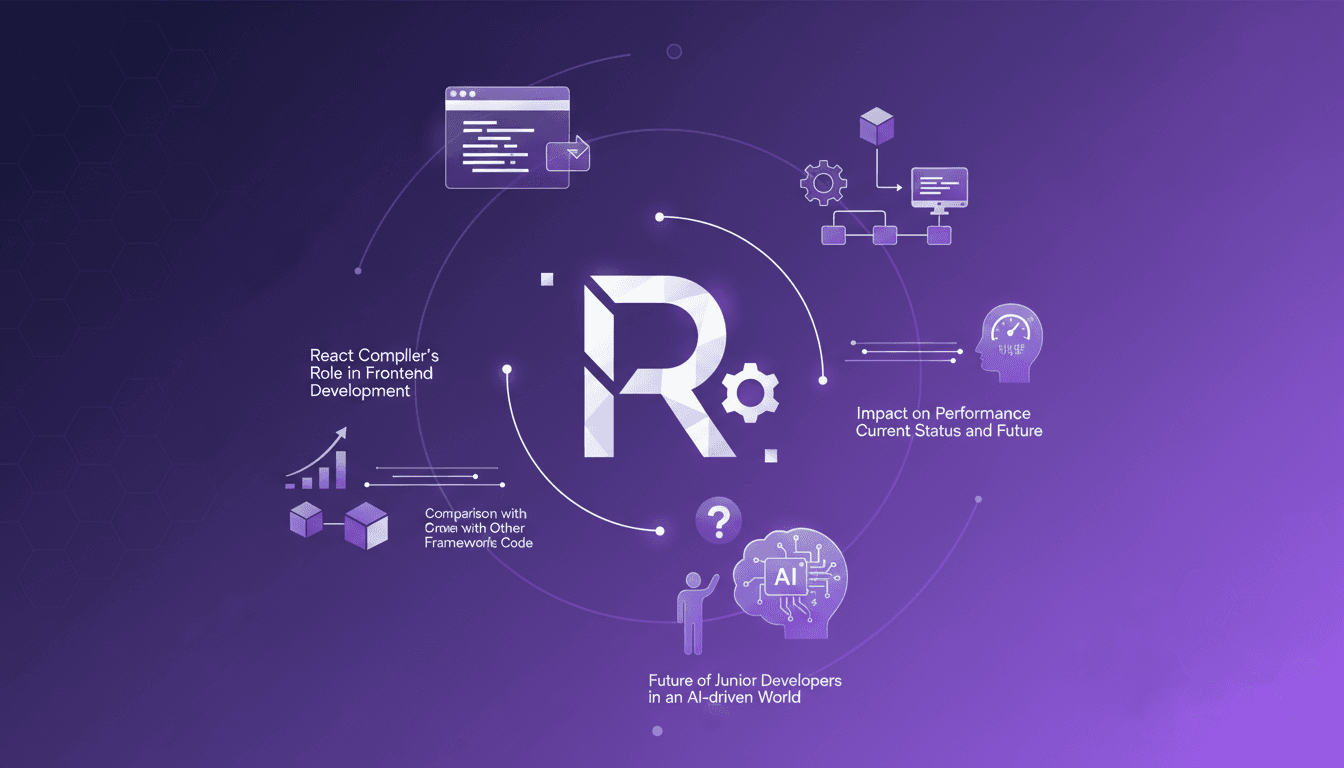

Compilateur React: Transformer le Frontend

Je me souviens encore de la première fois où j'ai enclenché le compilateur React dans un projet. C'était comme allumer une lumière qui transformait instantanément l'atmosphère de la pièce. Les composants qui traînaient auparavant sont devenus réactifs, et mes métriques de performance me faisaient un clin d'œil. Mais attention, ce n’est pas de la magie. Ce résultat, c’est le fruit d’une orchestration précise et d’un peu d’huile de coude. Dans le monde en constante évolution du développement frontend, le compilateur React s'impose comme un véritable game changer. Il automatise l'optimisation de manière que nous n'aurions pu qu'imaginer il y a quelques années. Plongeons ensemble dans la manière dont il transforme le paysage numérique et ce que cela signifie pour nous, les bâtisseurs de demain.

Clonage Vocal : Modèle Efficace pour Usage Commercial

Je me suis lancé dans le clonage vocal par nécessité—mes clients avaient besoin de voix off uniques sans les interminables sessions d'enregistrement. C'est là que je suis tombé sur ce modèle de clonage vocal. Premier réflexe? Le comparer à Eleven Labs pour voir s'il tenait la route. Le clonage vocal, ce n'est pas juste imiter des tons—c'est créer une solution évolutive pour des applications commerciales. Dans cet article, je vous emmène dans les coulisses de ce modèle : ses forces, ses faiblesses et les limitations à surveiller. Si vous avez déjà joué avec le clonage vocal, vous savez que les spécifications techniques et les considérations légales sont essentielles. Je vais vous guider à travers les nuances du modèle, son potentiel commercial, et comment il se compare vraiment à Eleven Labs.

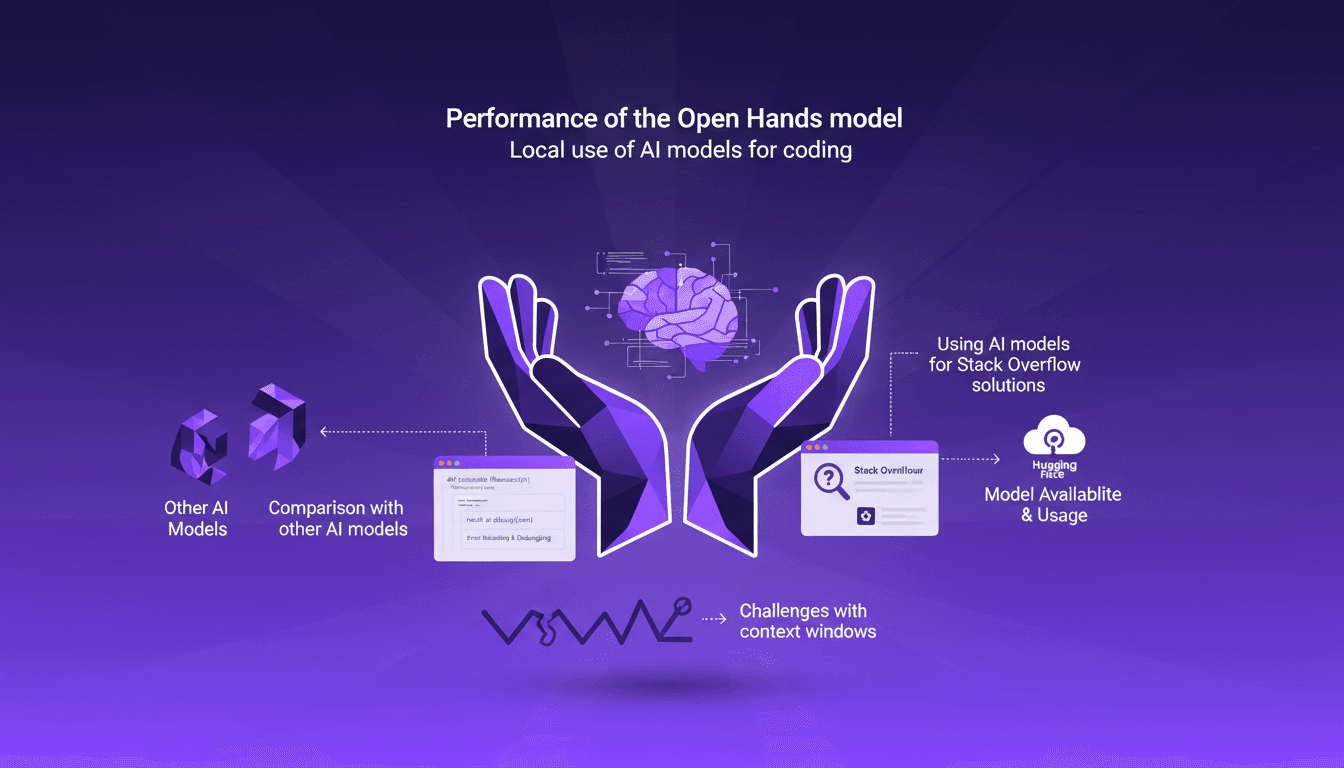

Performance du modèle Open Hands: Local et Efficace

J'ai plongé dans les modèles IA locaux pour le codage, et laissez-moi vous dire, le modèle Open Hands est une vraie révolution. Gérer un modèle de 7 milliards de paramètres localement, ce n'est pas seulement possible, c'est efficace si vous savez comment vous y prendre. Dans cet article, je partage mon expérience : de la configuration aux exemples de code, en passant par la comparaison avec d'autres modèles et la résolution des erreurs. Vous apprendrez comment ces modèles peuvent transformer vos tâches de programmation quotidiennes. Attention, il y a des limites à ne pas dépasser, notamment avec les fenêtres de contexte. Mais une fois optimisé, l'impact est direct, surtout pour répondre aux questions techniques sur Stack Overflow.