Construire des Graphes de Connaissance: Guide Pratique

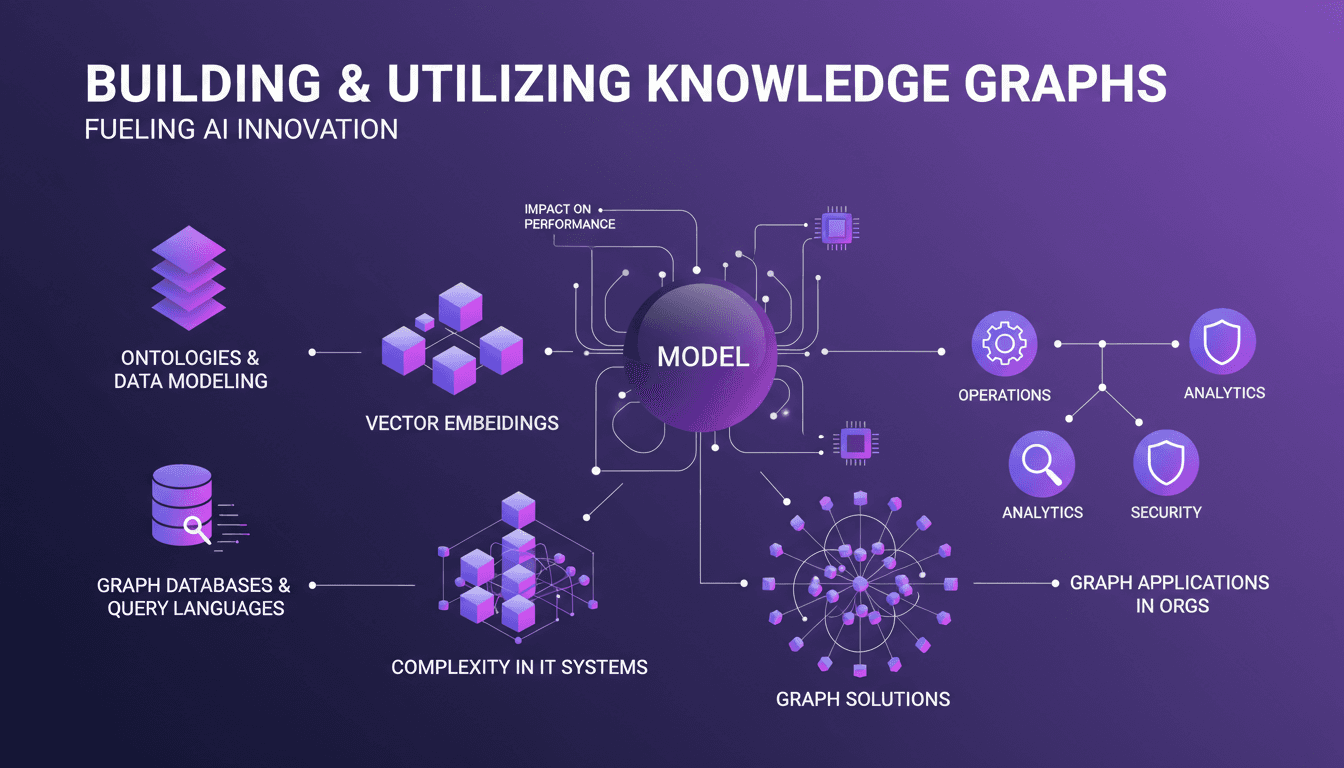

Je me souviens encore de la première fois où je suis tombé sur le concept des graphes de connaissance. C'était comme découvrir une arme secrète pour organiser les données. Mais alors, les complexités ont commencé. Naviguer dans le labyrinthe des structures de graphes n'est pas une mince affaire. Pourtant, quand je connecte les points, l'impact sur les performances de mes modèles est indéniable. Les graphes de connaissance ne sont pas seulement des outils puissants, ils sont presque indispensables dans un monde où la gestion de systèmes informatiques complexes est la norme. Attention cependant, ne sous-estimez pas la courbe d'apprentissage. Dans cet article, je vous montre comment j'ai apprivoisé ces outils et comment vous pouvez les intégrer efficacement dans vos projets.

La première fois que j'ai croisé les graphes de connaissance, c'était comme ouvrir une boîte de Pandore pleine de possibilités pour organiser mes données. On parle d'un vrai changement de jeu, mais avec un piège. La complexité de ces structures m'a frappé de plein fouet. Je me suis retrouvé à jongler avec des ontologies, des bases de données graphes, et des langages de requête, le tout en essayant de ne pas me noyer dans un océan de données. Pourtant, une fois que j'ai compris comment les orchestrer, j'ai vu une augmentation significative des performances de mes modèles. Les graphes de connaissance sont des outils puissants pour gérer la complexité des systèmes informatiques modernes, mais attention, la courbe d'apprentissage est raide. Dans cet article, je vous partage mon expérience, mes erreurs et comment j'ai finalement intégré ces outils dans mes workflows quotidiens.

Construire et Utiliser des Graphes de Connaissances

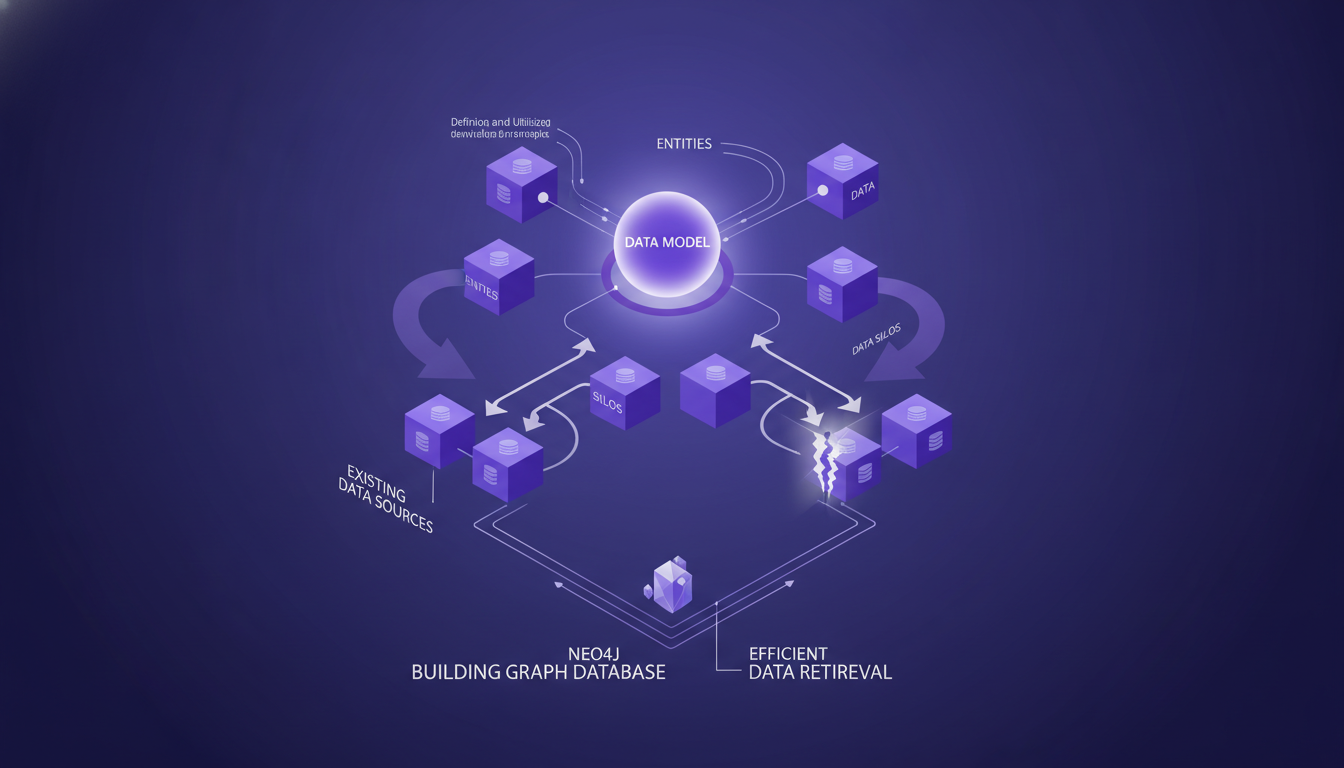

Je me suis lancé dans la construction de graphes de connaissances en partant d'un modèle de données bien défini. C'est fondamental : on commence toujours par identifier les entités clés qui formeront les nœuds de notre graphe. Prenez par exemple une banque : les entités seraient la banque elle-même, un client, un compte. Ensuite, j'intègre les sources de données existantes. Attention aux silos de données qui peuvent compliquer l'intégration.

J'utilise des bases de données graphe, comme Neo4j, pour la récupération efficace des données. Mais ne vous laissez pas submerger par la complexité. Il est essentiel de trouver un équilibre entre le détail et la complexité. Ne sur-ingénierisez pas votre modèle. Pensez toujours à l'évolutivité : prévoyez des dizaines de millions de nœuds. C'est un défi, mais crucial si vous voulez que votre système tienne la route à long terme.

- Définir un modèle de données avec des entités comme nœuds.

- Intégrer des sources de données existantes tout en évitant les silos.

- Utiliser Neo4j pour une récupération de données efficace.

- Équilibrer détail et complexité ; ne pas sur-ingénieriser.

- Planifier l'évolutivité pour des millions de nœuds.

Impact des Structures de Graphe sur la Performance des Modèles

Les structures de graphe peuvent considérablement améliorer les relations de données. J'incorpore des embeddings vectoriels pour enrichir les caractéristiques des nœuds. Mais attention aux goulots d'étranglement de performance qui peuvent ralentir les requêtes.

J'optimise les algorithmes de parcours de graphe pour une meilleure efficacité. Il y a toujours un compromis entre la précision et la performance, et c'est un équilibre que vous devez maîtriser pour éviter de perdre du temps.

- Améliorer les relations de données avec des structures de graphe.

- Incorporer des embeddings vectoriels pour enrichir les caractéristiques.

- Éviter les goulots d'étranglement de performance.

- Optimiser les algorithmes de parcours pour l'efficacité.

- Équilibrer précision et performance.

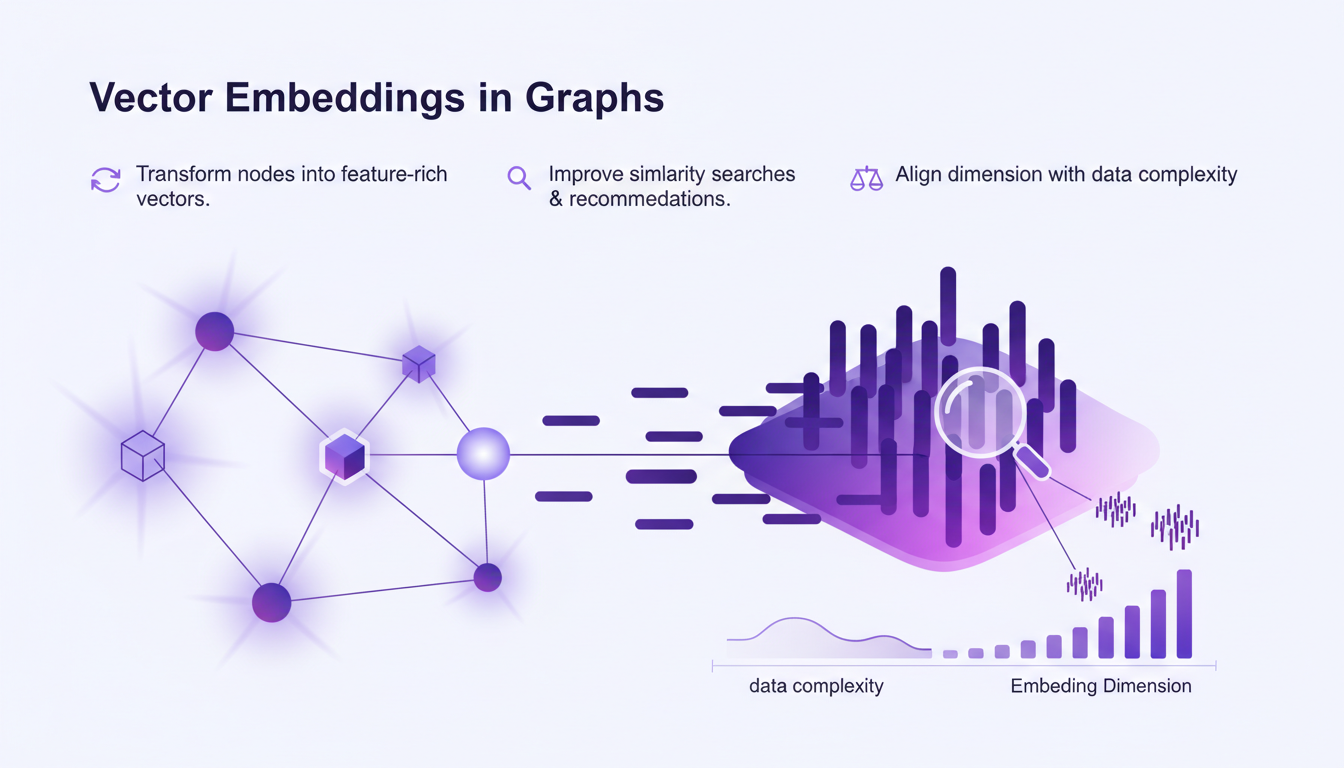

Embeddings Vectoriels dans les Graphes

Les embeddings vectoriels transforment les nœuds en vecteurs riches en caractéristiques. Cela améliore les recherches de similarité et les recommandations. Cependant, assurez-vous que la dimension de votre embedding est en phase avec la complexité de vos données.

L'overfitting peut être un risque ; il est crucial de régulariser vos embeddings. Testez différentes techniques d'embedding pour trouver celle qui convient le mieux à votre situation.

- Transformer les nœuds en vecteurs riches en caractéristiques.

- Améliorer les recherches de similarité et recommandations.

- Aligner la dimension de l'embedding avec la complexité des données.

- Régulariser les embeddings pour éviter l'overfitting.

- Tester différentes techniques d'embedding.

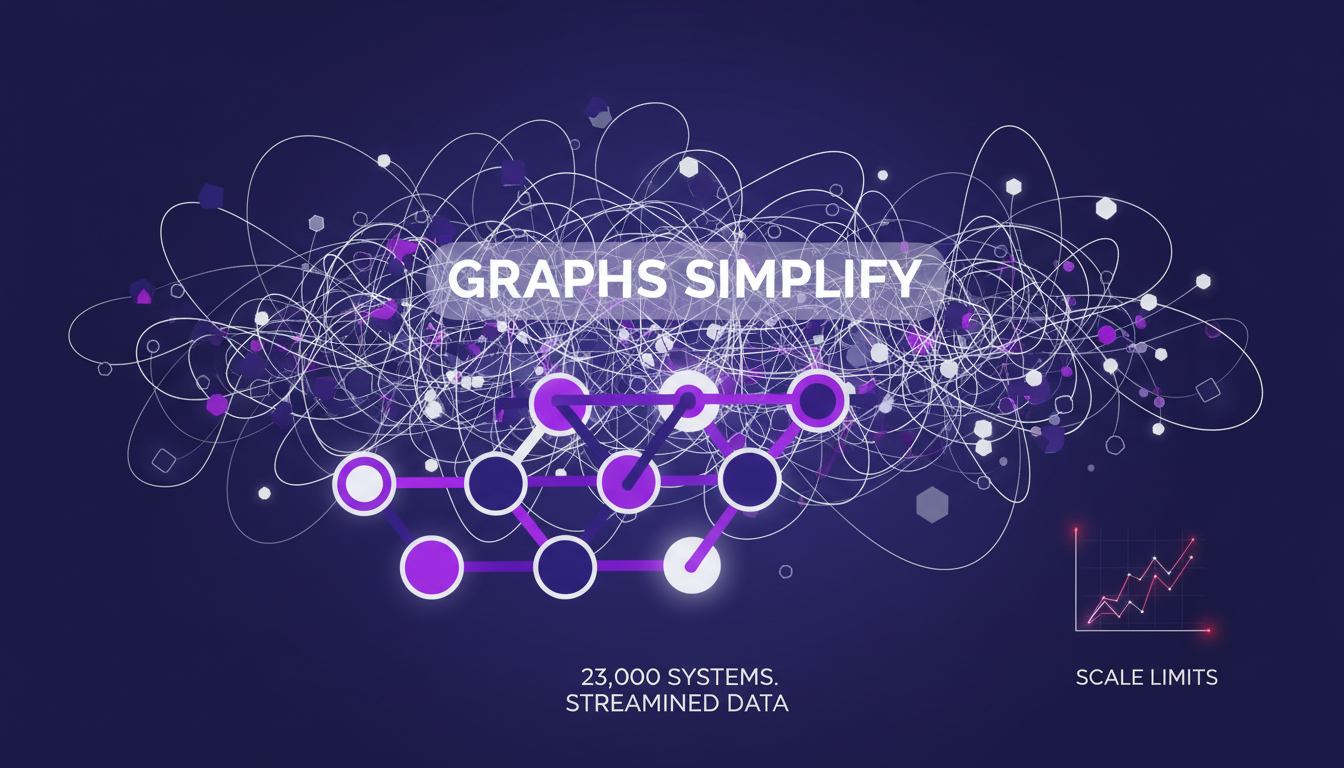

Complexité des Systèmes IT et Solutions Graphiques

Les graphes peuvent simplifier la complexité des systèmes interconnectés. Cependant, il est essentiel de comprendre les limites de l'évolutivité des graphes dans les infrastructures IT de grande taille.

Les solutions graphiques peuvent rationaliser l'intégration de données à travers 23,000 systèmes. Mais attention, si le graphe est mal structuré, le taux d'échec peut atteindre 99%. Utilisez les graphes pour prioriser et vous concentrer sur les principaux objectifs organisationnels.

- Simplifier la complexité des systèmes interconnectés avec des graphes.

- Comprendre les limites de l'évolutivité des graphes.

- Intégrer les données à travers 23,000 systèmes.

- Éviter un taux d'échec de 99% avec une bonne structure de graphe.

- Prioriser et se concentrer sur les objectifs organisationnels clés.

Bases de Données Graphes, Langages de Requête et Applications

Les bases de données graphes comme Neo4j et leurs langages de requête, tels que Cypher et Gremlin, sont essentiels. Ces langages sont puissants mais présentent une courbe d'apprentissage. Choisissez la base de données qui répond le mieux aux besoins de votre application.

Les applications graphiques peuvent transformer les stratégies de données organisationnelles. Planifiez l'intégration avec les systèmes et flux de travail existants, en gardant à l'esprit les trois priorités organisationnelles principales sur lesquelles vous devez rester concentré.

- Utiliser Neo4j et des langages de requête graphique.

- Maîtriser Cypher et Gremlin malgré leur courbe d'apprentissage.

- Choisir la base de données adaptée aux besoins de l'application.

- Transformer les stratégies de données avec des applications graphiques.

- Planifier l'intégration avec les systèmes existants.

Plonger dans le monde des graphes de connaissances est un véritable game changer pour la gestion des données et la performance des modèles. Mais attention, c'est pas magique. J'ai dû planifier soigneusement mes structures de graphes et choisir les bons outils, sinon bonjour les galères. Par exemple, même avec 100 formes d'assurance dans une seule base Postgres, la structure du graphe m'a permis de découvrir des insights insoupçonnés. Premier point clé : comprendre comment structurer votre graphe, c'est la base. Ensuite, utilisez des embeddings vectoriels, ça booste les performances. Enfin, soyez conscient de la complexité que ça ajoute à vos systèmes IT, surtout quand on jongle avec 23,000 systèmes différents. Prêt à construire votre propre graphe de connaissances ? Armez-vous des bonnes stratégies et outils, et regardez vos capacités de gestion de données s'envoler. Pour une plongée plus profonde, matez la vidéo "The Graph Problem Most Developers Don't Know They Have" sur YouTube, c'est une mine d'or pour aller plus loin.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Performance du modèle Open Hands: Local et Efficace

J'ai plongé dans les modèles IA locaux pour le codage, et laissez-moi vous dire, le modèle Open Hands est une vraie révolution. Gérer un modèle de 7 milliards de paramètres localement, ce n'est pas seulement possible, c'est efficace si vous savez comment vous y prendre. Dans cet article, je partage mon expérience : de la configuration aux exemples de code, en passant par la comparaison avec d'autres modèles et la résolution des erreurs. Vous apprendrez comment ces modèles peuvent transformer vos tâches de programmation quotidiennes. Attention, il y a des limites à ne pas dépasser, notamment avec les fenêtres de contexte. Mais une fois optimisé, l'impact est direct, surtout pour répondre aux questions techniques sur Stack Overflow.

Accéder à GPT-40 sur ChatGPT : Astuces Pratiques

Je me souviens du jour où OpenAI a annoncé la dépréciation de certains modèles. La frustration était palpable parmi nous, utilisateurs, y compris moi-même. Mais j'ai trouvé une manière de naviguer dans ce chaos, en accédant aux modèles hérités comme le GPT-40 tout en adoptant le tout nouveau GPT-5. Dans cet article, je partage comment j'ai orchestré cela. Avec les mises à jour rapides d'OpenAI, rester à jour peut ressembler à un exercice d'équilibriste. La dépréciation des anciens modèles et l'introduction de nouveaux comme le GPT-5 ont laissé beaucoup de gens perplexes. Mais avec la bonne approche, vous pouvez tirer parti de ces changements. Je vous explique comment accéder aux modèles hérités, les cas d'utilisation de GPT-5, et comment configurer vos options de sélection de modèle sur ChatGPT, tout en gardant un œil sur les limites de taux et les exigences computationnelles.

Compilateur React: Transformer le Frontend

Je me souviens encore de la première fois où j'ai enclenché le compilateur React dans un projet. C'était comme allumer une lumière qui transformait instantanément l'atmosphère de la pièce. Les composants qui traînaient auparavant sont devenus réactifs, et mes métriques de performance me faisaient un clin d'œil. Mais attention, ce n’est pas de la magie. Ce résultat, c’est le fruit d’une orchestration précise et d’un peu d’huile de coude. Dans le monde en constante évolution du développement frontend, le compilateur React s'impose comme un véritable game changer. Il automatise l'optimisation de manière que nous n'aurions pu qu'imaginer il y a quelques années. Plongeons ensemble dans la manière dont il transforme le paysage numérique et ce que cela signifie pour nous, les bâtisseurs de demain.

Clonage Vocal : Modèle Efficace pour Usage Commercial

Je me suis lancé dans le clonage vocal par nécessité—mes clients avaient besoin de voix off uniques sans les interminables sessions d'enregistrement. C'est là que je suis tombé sur ce modèle de clonage vocal. Premier réflexe? Le comparer à Eleven Labs pour voir s'il tenait la route. Le clonage vocal, ce n'est pas juste imiter des tons—c'est créer une solution évolutive pour des applications commerciales. Dans cet article, je vous emmène dans les coulisses de ce modèle : ses forces, ses faiblesses et les limitations à surveiller. Si vous avez déjà joué avec le clonage vocal, vous savez que les spécifications techniques et les considérations légales sont essentielles. Je vais vous guider à travers les nuances du modèle, son potentiel commercial, et comment il se compare vraiment à Eleven Labs.

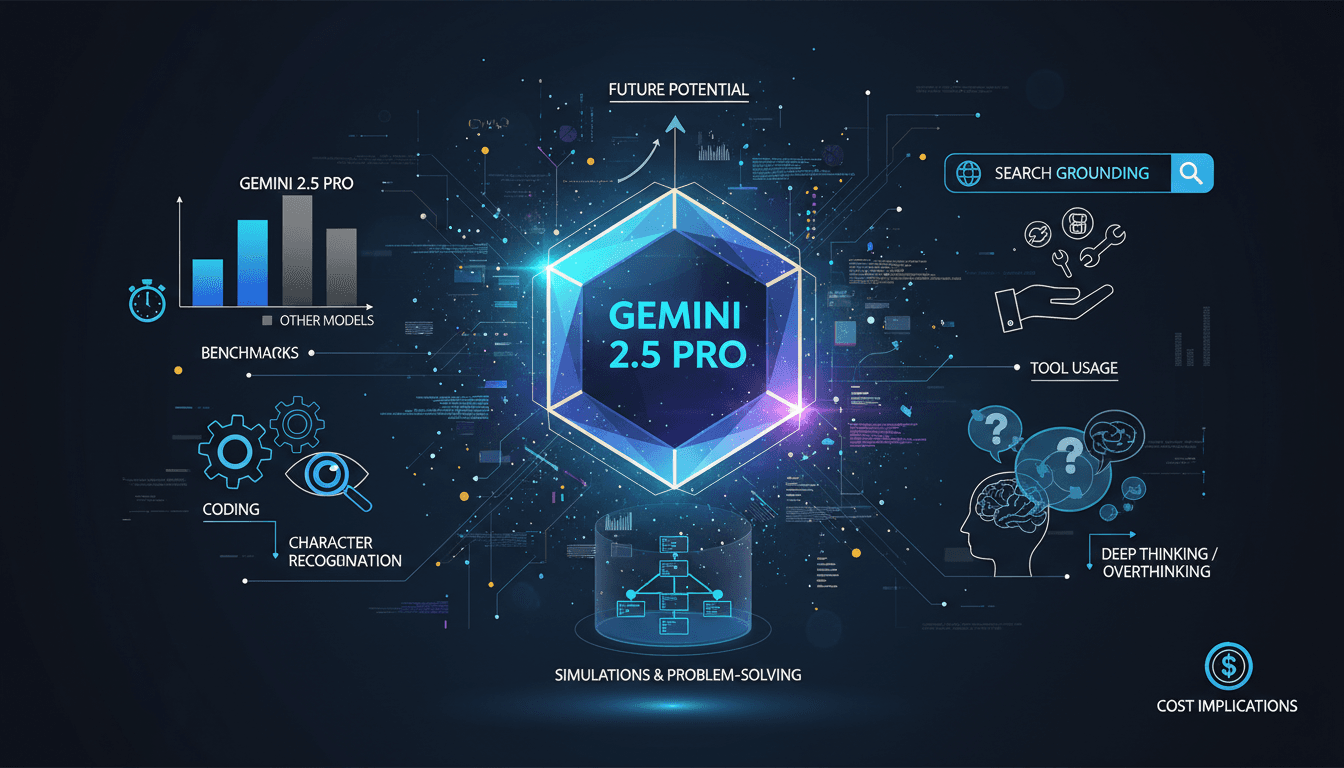

Gemini 2.5 Pro : Performances et Comparaisons

J'ai plongé dans le Gemini 2.5 Pro avec des attentes élevées, et il n'a pas déçu. De l'exactitude en codage à l'ancrage de recherche, ce modèle repousse les limites. Mais il y a bien sûr des compromis à envisager. Avec un score de 1443, le plus élevé dans l'arène des LM, et une précision quasi parfaite dans les tâches de reconnaissance de caractères, Gemini 2.5 Pro impressionne. Cependant, l'utilisation excessive des outils et la tendance à sur-analyser peuvent parfois ralentir le processus. Je partage ici mon expérience pratique avec ce modèle, mettant en lumière ses forces et ses pièges potentiels. Préparez-vous à découvrir comment Gemini 2.5 Pro se compare et où il pourrait vous surprendre.