Accéder à GPT-40 sur ChatGPT : Astuces Pratiques

Je me souviens du jour où OpenAI a annoncé la dépréciation de certains modèles. La frustration était palpable parmi nous, utilisateurs, y compris moi-même. Mais j'ai trouvé une manière de naviguer dans ce chaos, en accédant aux modèles hérités comme le GPT-40 tout en adoptant le tout nouveau GPT-5. Dans cet article, je partage comment j'ai orchestré cela. Avec les mises à jour rapides d'OpenAI, rester à jour peut ressembler à un exercice d'équilibriste. La dépréciation des anciens modèles et l'introduction de nouveaux comme le GPT-5 ont laissé beaucoup de gens perplexes. Mais avec la bonne approche, vous pouvez tirer parti de ces changements. Je vous explique comment accéder aux modèles hérités, les cas d'utilisation de GPT-5, et comment configurer vos options de sélection de modèle sur ChatGPT, tout en gardant un œil sur les limites de taux et les exigences computationnelles.

Je me souviens très bien du jour où OpenAI a annoncé la dépréciation de certains modèles. La frustration était tangible parmi les utilisateurs, moi y compris. Mais j'ai trouvé un moyen de naviguer dans ce chaos, en accédant aux modèles hérités comme le GPT-40 tout en m'adaptant au nouveau GPT-5. Voici comment j'ai orchestré tout cela. Avec les mises à jour rapides d'OpenAI, rester à jour peut ressembler à un exercice de jonglage. La dépréciation des anciens modèles et l'introduction de nouveaux comme le GPT-5 ont laissé beaucoup d'entre nous dans le flou. Pourtant, avec la bonne approche, ces changements peuvent être une véritable aubaine. Je vous emmène à travers le parcours d'accès aux modèles hérités, les cas d'utilisation du GPT-5, et comment configurer vos paramètres de sélection de modèle sur ChatGPT. Mais attention, il est crucial de garder un œil sur les limites de taux et les exigences computationnelles pour tirer le meilleur parti de ces outils. Alors, plongeons ensemble dans ce tutoriel qui vous donnera les clés pour reprendre le contrôle.

Naviguer dans la Dépréciation des Modèles : Un Guide Pratique

Je me souviens encore des jours où OpenAI a commencé à déprécier certains de ses anciens modèles. C'était un vrai casse-tête, surtout pour ceux d'entre nous qui avaient optimisé leurs workflows autour de modèles comme le GPT-40. Pourquoi cette dépréciation ? En gros, c'est pour pousser les utilisateurs vers les nouvelles versions plus performantes. Mais attention, ça peut être frustrant, surtout quand nos processus sont perturbés. Heureusement, pour les utilisateurs payants, OpenAI a rendu le GPT-40 accessible en tant que modèle hérité. Ça nécessite juste de fouiller un peu dans les paramètres pour le retrouver.

Pour accéder à ces anciens modèles, il suffit de naviguer dans les paramètres de ChatGPT et d'activer les modèles supplémentaires. Ça peut sembler simple, mais ça sauve la mise. La dépréciation impacte directement notre efficacité, surtout si on s'appuyait lourdement sur ces anciens modèles dans nos workflows quotidiens.

"OpenAI a déprécié de nombreux modèles, causant de la frustration, surtout sur Reddit."

- Comprendre pourquoi les modèles sont dépréciés.

- Étapes pour accéder aux modèles hérités comme GPT-40.

- Équilibrer frustration et solutions proactives.

- Impact pratique sur les workflows et l'efficacité.

Exploiter le Potentiel de GPT-5

Quand OpenAI a introduit le GPT-5, j'étais sceptique au début. Mais après l'avoir testé, j'ai vite vu les avantages. Comparé à ses prédécesseurs, GPT-5 est bien plus rapide et précis. Il excelle dans les tâches complexes et s'adapte aux changements de contexte de manière fluide. Par exemple, pour la conversion de devises en temps réel, GPT-5 s'est montré très efficace.

Les cas d'utilisation sont nombreux : de l'analyse de données à la rédaction assistée. Mais attention, comme tout, il y a des limites. GPT-5 peut être gourmand en ressources, surtout si on dépasse les 196 000 tokens. C'est là que les compromis en termes de performance et de demande computationnelle entrent en jeu.

- Introduction à GPT-5 et ses capacités.

- Améliorations par rapport aux modèles précédents.

- Cas d'utilisation réels pour GPT-5.

- Limites potentielles et compromis de performance.

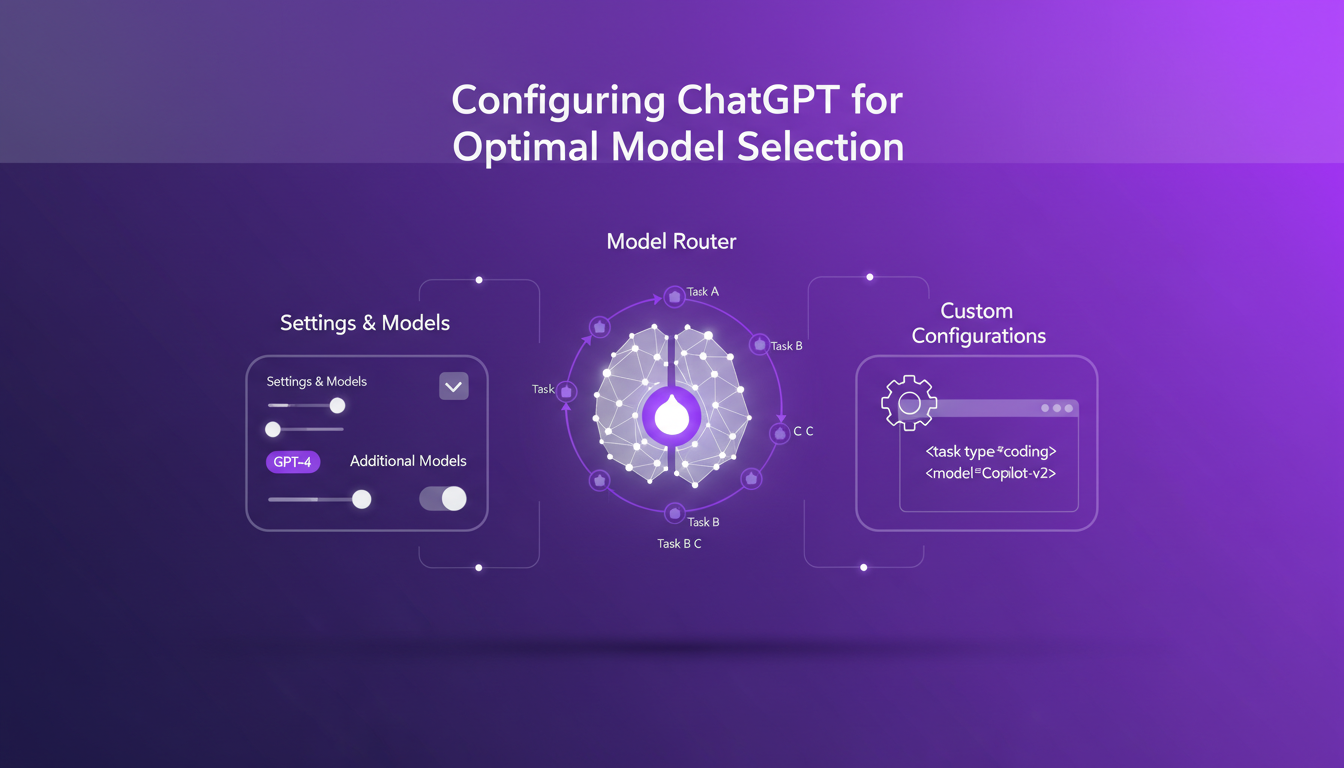

Configurer ChatGPT pour une Sélection Optimale de Modèles

L'une des choses que j'ai apprises en jonglant avec les différents modèles, c'est l'importance de bien configurer ChatGPT. Pour activer les modèles supplémentaires, il faut passer par les paramètres et comprendre le rôle du Model Router. Ce dernier décide quel modèle utiliser en fonction de la tâche. Mais parfois, il vaut mieux personnaliser ces configurations pour des tâches spécifiques.

Attention aux pièges courants : ne laissez pas le routeur décider à votre place pour des tâches critiques. Parfois, choisir manuellement est plus efficace.

- Paramètres pour activer les modèles supplémentaires dans ChatGPT.

- Comprendre le rôle du Model Router.

- Personnaliser les configurations pour des tâches spécifiques.

- Éviter les pièges courants dans la sélection de modèles.

Maximiser l'Efficacité avec le Modèle de Pensée

Le modèle de pensée dans ChatGPT, c'est un peu comme avoir un assistant qui réfléchit à votre place. Avec sa fenêtre de contexte de 196 000 tokens, il est parfait pour les tâches de programmation ou les longs contextes. Mais attention, ça peut être coûteux en termes de ressources. Parfois, il vaut mieux choisir un modèle plus rapide si le contexte n'est pas complexe.

- Exploiter la fenêtre de contexte de 196 000 tokens.

- Utiliser le modèle de pensée pour les tâches de programmation.

- Gérer efficacement les tâches de long contexte.

- Équilibre entre demande computationnelle et performance.

Gérer les Limites de Taux et les Exigences Computationnelles

Une autre chose à ne pas négliger, c'est la limite de messages de 3 000 par semaine. Ça peut sembler beaucoup, mais quand on est en plein développement, on atteint vite la limite. Pour optimiser l'utilisation des messages, il faut planifier et répartir les requêtes de manière stratégique.

Équilibrer les exigences computationnelles avec les performances est crucial. Anticiper les goulots d'étranglement potentiels peut sauver votre projet de l'échec.

- Comprendre la limite de messages de 3 000 par semaine.

- Stratégies pour optimiser l'utilisation des messages.

- Équilibrer les exigences computationnelles avec les performances.

- Anticiper et gérer les goulots d'étranglement potentiels.

Naviguer dans le paysage en constante évolution d'OpenAI, c'est un peu comme piloter un navire en pleine tempête. D'abord, il faut comprendre que la dépréciation des modèles, c'est frustrant, mais c'est aussi l'occasion d'embrasser de nouvelles capacités comme celles de GPT-5. Ensuite, je m'assure d'optimiser mes paramètres, car utiliser le bon modèle pour la tâche appropriée, c'est là que réside la vraie magie. Par exemple, le modèle GPT-5, avec sa fenêtre de contexte de 196 000 tokens, change vraiment la donne pour des applications complexes.

- Comprendre les frustrations liées à la dépréciation des modèles et comment accéder aux anciens modèles comme GPT-40.

- Explorer les nouvelles capacités de GPT-5 pour des cas d'utilisation avancés.

- S'assurer d'optimiser les paramètres de sélection de modèle dans ChatGPT pour des résultats optimaux.

L'avenir est prometteur avec ces outils, mais attention à ne pas se perdre dans la surenchère de nouveautés inutiles. Prêt à optimiser vos workflows d'IA ? Plongez dans ces stratégies et transformez votre utilisation de ChatGPT dès aujourd'hui. Pour une compréhension plus approfondie, je vous recommande de regarder la vidéo complète ici : GPT-5 Update! 💥.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

OpenAI et Sécurité Nucléaire : Déploiement et Impacts

Je me souviens de la première fois où j'ai lu sur la collaboration d'OpenAI avec le gouvernement américain. C'était un vrai bouleversement, mais avec des nuances complexes. Cette alliance entre OpenAI et les Laboratoires Nationaux change la donne dans le déploiement de l'IA, et elle n'est pas seulement une question de technologie. On parle ici de leadership, d'innovation et de l'équilibre délicat du pouvoir dans un monde compétitif. Avec des figures clés comme Elon Musk et Donald Trump impliquées, et des acteurs technologiques comme Nvidia et Azure en soutien, les enjeux autour de la sécurité nucléaire et de la cybersécurité prennent une toute autre dimension. Et puis, il y a cette compétition États-Unis-Chine qui pèse. Accrochez-vous, car je vais vous expliquer comment tout cela se déroule.

Modèles StepFun AI : Efficacité et Impact Futur

J'ai plongé dans l'écosystème de StepFun AI, intrigué par ses capacités de génération de vidéo à partir de texte. En explorant ses modèles et ses métriques de performance, j'ai découvert un acteur ambitieux venu de Chine. Avec 30 milliards de paramètres et la capacité de générer jusqu'à 200 images par seconde, StepFun AI promet de secouer le paysage de l'IA. Mais attention, le modèle Step video t2v nécessite 80 Go de mémoire GPU. Comparé à d'autres modèles, il y a des compromis à considérer, mais son potentiel est indéniable. Découvrons ensemble ce qui fait la force de StepFun AI et comment il pourrait redéfinir l'industrie.

Créer Influenceur Mode IA: Guide Pratique

Je me suis plongé dans l'univers des influenceurs mode virtuels, et croyez-moi, le potentiel des essayages virtuels est immense. Imaginez créer un mannequin qui porte vos créations sans avoir besoin de shooting photo. C'est exactement ce que j'ai fait avec quelques outils d'IA simples, et c'est un véritable game changer pour réduire les coûts et booster la créativité. Avec un investissement de moins d'un dollar par essai et à peine 40 secondes par génération, on est sur du concret. Dans cet article, je vous montre comment utiliser cette technologie pour transformer votre approche marketing mode. De la création de modèles générés par IA aux opportunités de monétisation, voici comment orchestrer cette tech efficacement.

Devenir un Chuchoteur d'IA : Guide Pratique

Devenir un 'Chuchoteur d'IA' n'est pas seulement une question de technologie, croyez-moi. Après des centaines d'heures à interagir avec des modèles, je peux vous dire que c'est un art autant qu'une science. C'est plonger tête la première dans les profondeurs de l'IA, tester les limites, apprendre de chaque sortie bizarre. Dans cet article, je vous emmène dans mon parcours, un voyage empirique où chaque interaction avec l'IA est une leçon. On parlera de ce que signifie vraiment être un Chuchoteur d'IA, comment j'explore les modèles en profondeur, et pourquoi il est crucial d'être prêt à passer du temps à dialoguer avec eux. Croyez-moi, j'ai appris à la dure, mais les résultats sont là.

Llama 4 : Déploiement et Défis Open Source

Je me suis plongé tête baissée dans le monde de l'IA avec Llama 4, décidé à exploiter sa puissance tout en naviguant dans les eaux parfois troubles du code source ouvert. Alors, après quatre jours intensifs, qu'est-ce que j'ai appris ? D'abord, Llama 4 crée des vagues dans le développement de l'IA, mais sa classification suscite des débats houleux. Est-il véritablement open-source ou joue-t-on sur les mots ? J'ai connecté les points entre Llama 4 et le concept d'IA open-source, en explorant comment ces mondes s'entrelacent, se heurtent parfois. En tant que praticien, je vous emmène dans les tranchées de cette révolution technologique, où chaque ligne de code compte, et où chaque choix technique a ses conséquences. Il est temps de démystifier ce qui se cache derrière la terminologie : modèle ouvert versus open-source. Et attention, il y a des limites à ne pas franchir, et des erreurs à éviter. Allons-y !