Apprentissage Renforcé pour LLMs: Nouveaux Agents IA

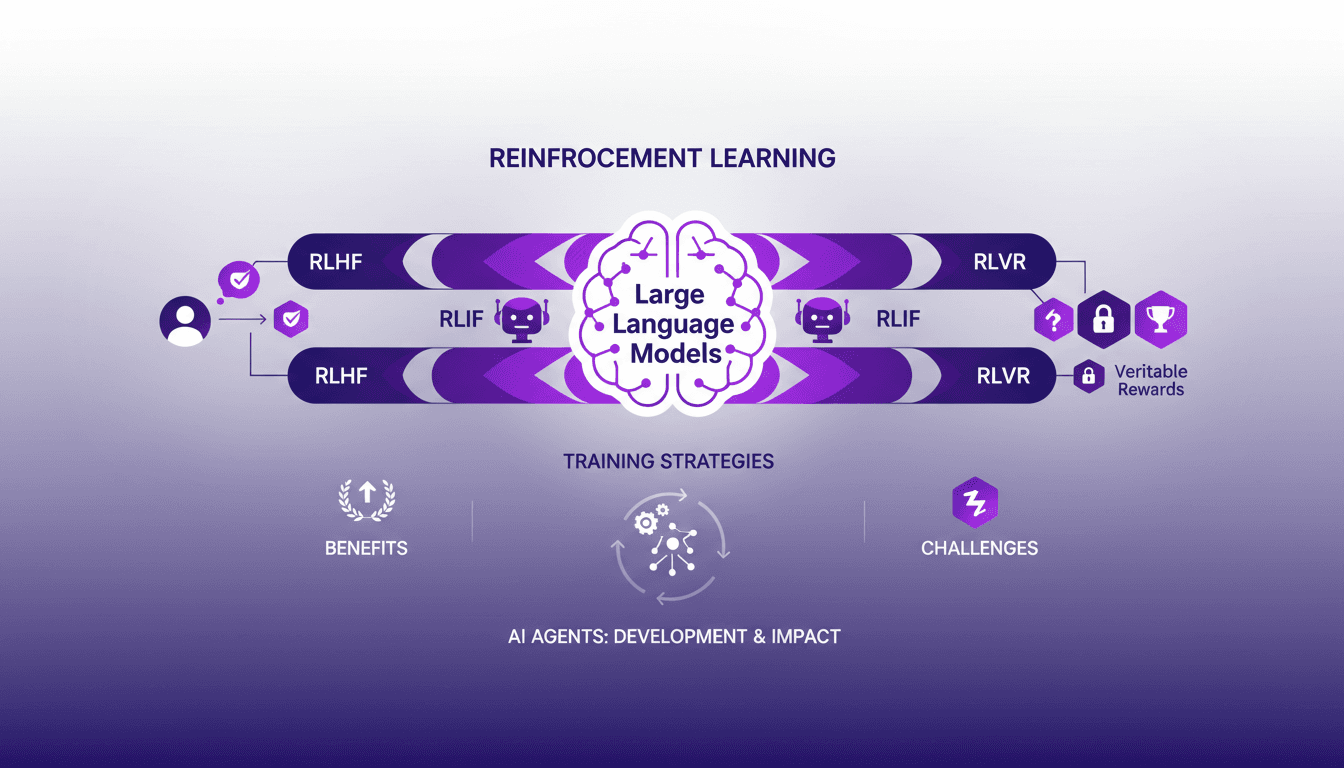

Je me souviens encore de la première fois où j'ai intégré l'apprentissage renforcé dans la formation des modèles de langage de grande taille (LLMs). C'était en 2022, et avec le développement de ChatGPT encore frais en mémoire, j'ai compris que c'était un véritable game changer pour les agents IA. Mais attention, il y a des compromis à prendre en compte. L'apprentissage renforcé révolutionne la façon dont nous formons les LLMs, offrant de nouvelles méthodes pour améliorer les agents IA. Dans cet article, je vous emmène avec moi dans mon aventure avec l'AR dans les LLMs, partageant des aperçus pratiques et les leçons apprises. Je vais parler de l'apprentissage renforcé avec feedback humain (RLHF), feedback IA (RLIF), et récompenses vérifiables (RLVR). Préparez-vous à découvrir comment ces approches transforment notre manière de concevoir et d'entraîner les agents IA.

Je me souviens encore de la première fois où j'ai intégré l'apprentissage renforcé dans la formation des modèles de langage de grande taille (LLMs). C'était en 2022, et le développement de ChatGPT était encore frais dans mon esprit. J'ai connecté les points et j'ai réalisé que c'était un véritable game changer pour les agents IA. Mais ne nous emballons pas trop vite, il y a des compromis à prendre en compte. L'apprentissage renforcé révolutionne la façon dont nous formons les LLMs, offrant de nouvelles méthodes pour améliorer les agents IA. Dans cet article, je vais partager avec vous mon parcours avec l'AR dans les LLMs, en vous offrant des aperçus pratiques et les leçons tirées de mes expériences. On va plonger dans les détails de l'apprentissage renforcé avec feedback humain (RLHF), feedback IA (RLIF), et récompenses vérifiables (RLVR). Je vais aussi aborder les stratégies de formation des LLMs et les défis et avantages des approches d'apprentissage renforcé. Préparez-vous à découvrir comment ces méthodes transforment notre manière de concevoir et d'entraîner les agents IA, et gardez à l'esprit que même si c'est un immense progrès, il y a des pièges à éviter.

Plongée dans l'apprentissage par renforcement pour les LLMs

Quand on parle d'apprentissage par renforcement (RL), on parle de donner aux machines la capacité d'apprendre par essai-erreur. C'est un peu comme entraîner un chien à faire des tours — on lui donne une friandise quand il réussit, rien quand il échoue. Pour les Large Language Models (LLMs), c'est pareil, mais à une échelle massive. RL est crucial pour les LLMs car il permet de passer d'une évaluation au niveau des tokens (chaque mot ou caractère) à une évaluation au niveau des réponses. Ça change tout, car au lieu de corriger chaque mot, on juge la réponse dans son ensemble, ce qui est beaucoup plus naturel.

Les LLMs comme ceux développés par OpenAI utilisent une stratégie en trois étapes : pré-entraînement, ajustement supervisé, et RL avec retour humain. Cette méthode a changé la donne en 2022 avec le développement de ChatGPT. On a pu voir une application directe de ces techniques, en passant par des phases comme le pré-entraînement auto-supervisé, où les modèles apprennent à prédire le texte suivant de manière autonome.

C'est un pas en avant dans la manière dont nous interagissons avec les IA, en rendant le feedback beaucoup plus intuitif et aligné sur les attentes humaines.

L'apprentissage par renforcement avec retour humain (RLHF)

Avec le Reinforcement Learning with Human Feedback (RLHF), on intègre directement les préférences humaines dans le processus de formation des LLMs. En gros, on forme un modèle de récompense basé sur le feedback humain pour que le modèle génère des réponses alignées sur ce que les humains considèrent comme utile et approprié. J'ai mis en place le RLHF dans des projets récents, et croyez-moi, les défis sont nombreux. D'abord, il faut trouver un équilibre entre l'intensité du travail humain et la précision du modèle.

Face à ces défis, j'ai souvent dû jongler entre la main-d'œuvre humaine et l'efficacité computationnelle. Par exemple, tandis que le RLHF peut être bruyant et biaisé, il reste incontournable pour ajuster les modèles de manière à ce qu'ils comprennent mieux les nuances humaines.

Attention, le RLHF peut rapidement devenir coûteux en termes de ressources humaines. Il faut donc bien évaluer les besoins avant de se lancer.

- Le RLHF nécessite une main-d'œuvre importante pour annoter et fournir des retours.

- Il offre des résultats plus alignés sur les préférences humaines malgré le bruit inhérent.

- Un bon équilibre entre l'efficacité et la précision est essentiel.

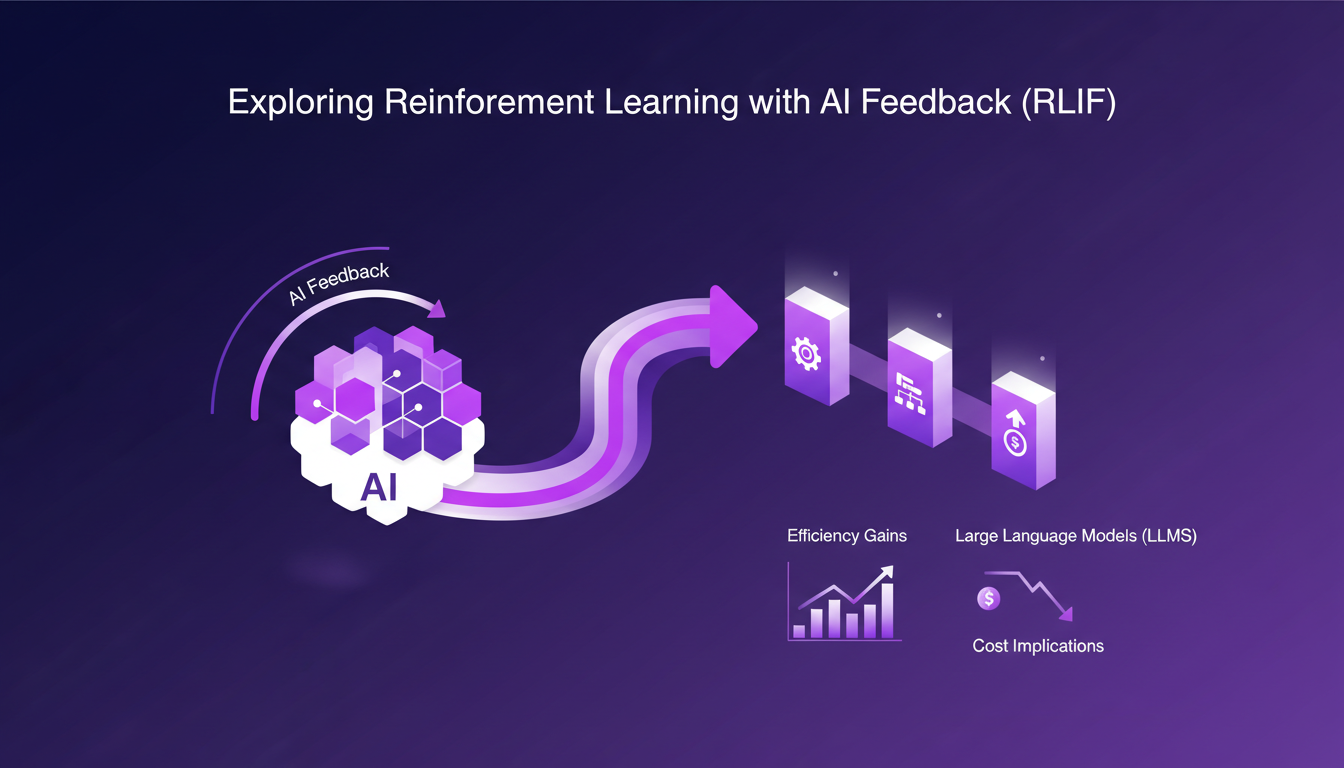

Exploration de l'apprentissage par renforcement avec retour AI (RLIF)

Avec le Reinforcement Learning with AI Feedback (RLIF), on parle d'un potentiel énorme pour automatiser certaines tâches. Dans mon workflow, intégrer le feedback AI a permis de réaliser des gains d'efficacité non négligeables. En effet, le RLIF est particulièrement utile pour les tâches évaluant des critères comme la nocivité ou l'utilité avec des barèmes précis.

Mais soyons clairs, le RLIF a ses limites. Il est moins coûteux que le RLHF, mais peut parfois manquer de précision. Par exemple, dans certains cas, l'IA peut passer à côté de nuances subtiles que seul un humain pourrait capter. C'est là que les trade-offs deviennent intéressants. On gagne en scalabilité et en coût, mais au prix d'une certaine précision.

- Le RLIF est plus scalable que le RLHF, mais peut manquer de nuances.

- Il est idéal pour les tâches avec des critères d'évaluation bien définis.

- Il faut être prêt à accepter des biais potentiellement élevés.

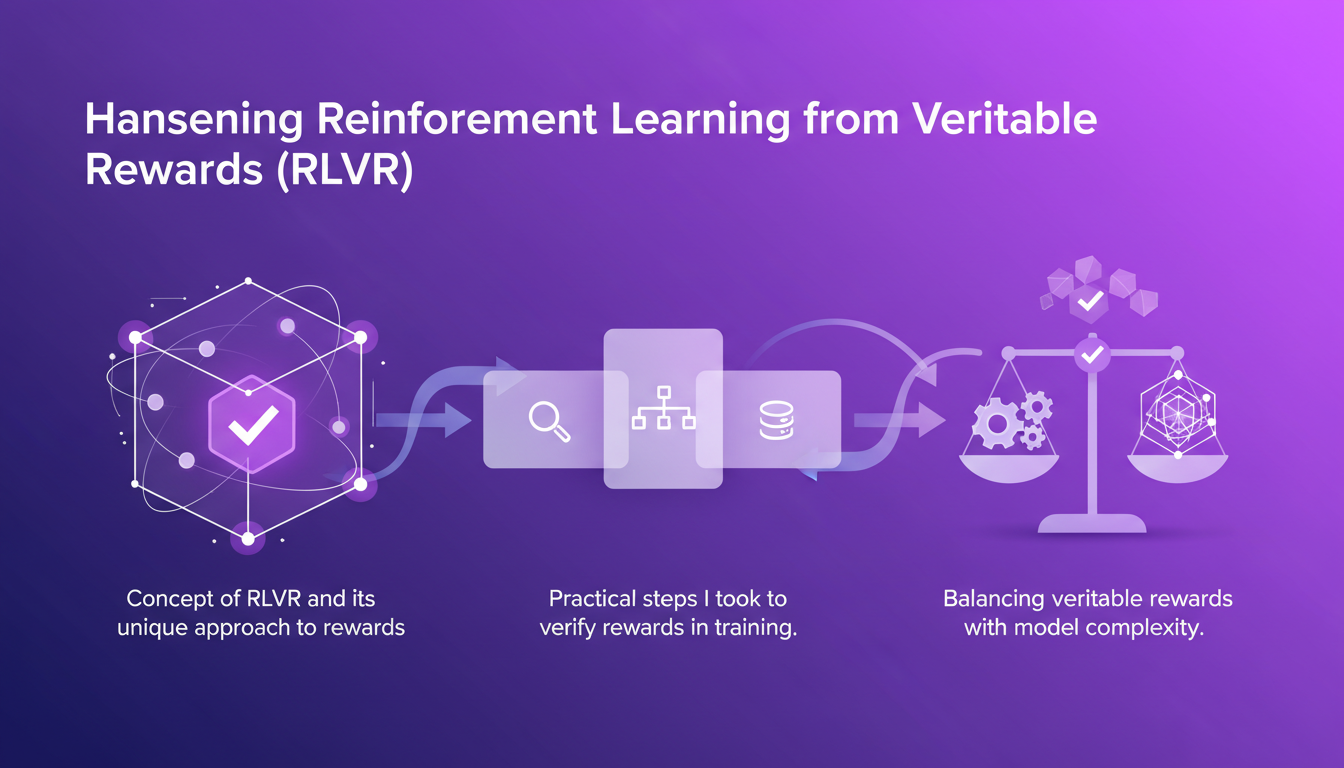

Exploiter l'apprentissage par renforcement à partir de récompenses vérifiables (RLVR)

Le concept de Reinforcement Learning from Verifiable Rewards (RLVR) est fascinant car il introduit une approche unique où les récompenses sont vérifiées à l'aide de données concrètes. J'ai personnellement travaillé sur la vérification des récompenses lors de la formation, et bien que cela semble simple, les défis sont nombreux. Assurer l'exactitude et la pertinence des récompenses est crucial, surtout lorsque les modèles deviennent plus complexes.

Dans ce cadre, l'utilisation de code pour évaluer la justesse des résultats est une pratique courante. Mais attention, il faut s'assurer que les récompenses sont pertinentes à chaque étape, sinon on risque de biaiser l'ensemble du processus de formation.

Conseil: Assurez-vous que les récompenses utilisées sont toujours en adéquation avec les objectifs finaux de votre modèle.

- Le RLVR permet de vérifier les résultats à l'aide de données et de code concrets.

- Il est crucial d'assurer la pertinence des récompenses à chaque étape de la formation.

- Les modèles peuvent devenir très complexes, rendant la tâche plus difficile.

Défis et avenir des agents IA

Parlons des défis. L'apprentissage par renforcement, bien que puissant, n'est pas sans failles. Des défis comme le coût computationnel et la rareté des récompenses sont encore présents. J'ai souvent dû réajuster mes stratégies pour surmonter ces obstacles, en particulier lors du déploiement d'agents IA personnalisés.

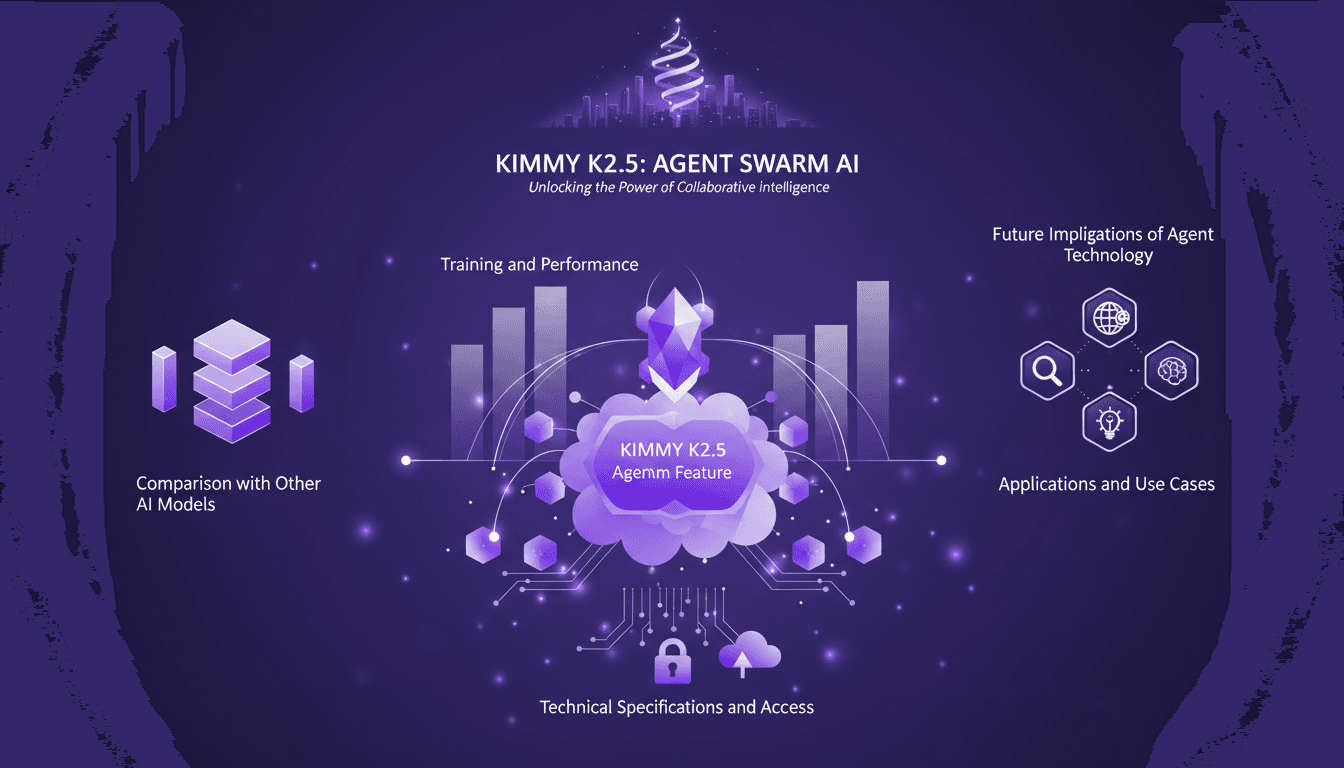

L'avenir des agents IA est prometteur avec des applications sur mesure comme Kimmy K2.5 qui maîtrise les essaims d'agents. Mais pour déployer ces agents efficacement, il est impératif de comprendre les implications stratégiques de chaque approche RL que nous choisissons.

En conclusion, l'apprentissage par renforcement continue d'évoluer et de transformer la formation des LLMs. Que ce soit via le RLHF, le RLIF ou le RLVR, chaque approche a ses avantages et ses inconvénients. Mais une chose est sûre, le bon choix d'outil et de méthode peut faire toute la différence.

Alors, qu'est-ce que j'ai appris en plongeant dans l'apprentissage par renforcement pour entraîner des LLMs ? D'abord, RLHF, c'est-à-dire l'apprentissage avec feedback humain, m'a montré l'importance du contexte humain, mais attention, ça peut vite consommer du temps et des ressources. Ensuite, le RLIF utilise le retour d'une IA pour accélérer le processus, mais on doit être vigilant quant à la qualité des feedbacks automatiques. Enfin, RLVR m'a vraiment fait comprendre la puissance des récompenses vérifiables, mais là aussi, il faut bien calibrer les paramètres pour éviter des biais.

Regarder l'avenir avec une dose d'enthousiasme : l'apprentissage par renforcement est un vrai game changer pour les LLMs, mais n'oublions pas de garder un œil sur les limites techniques et éthiques.

Prêt à en découvrir plus ? Je vous encourage à expérimenter avec le RL dans vos projets LLM et à partager vos découvertes avec la communauté. Regardez la vidéo complète pour creuser encore plus profond : Lien vers la vidéo. Ensemble, poussons les limites de l'IA.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Kimmy K2.5 : Maîtriser l'Agent Swarm

Je me souviens de ma première plongée dans le modèle Kimmy K2.5. C'était comme entrer dans une nouvelle ère de l'IA, où la fonctionnalité Agent Swarm promettait de révolutionner notre manière de gérer les tâches parallélisables. J'ai passé des heures à optimiser, tester et pousser ce modèle à ses limites. Et je vous le dis, si vous savez l'exploiter, c'est un véritable atout. Avec ses 15 trillions de tokens et la capacité de gérer 500 étapes coordonnées, c'est un champion incontesté. Mais attention, il y a des pièges à éviter. Permettez-moi de vous guider à travers les capacités de cet outil puissant, ses applications et ses implications futures.

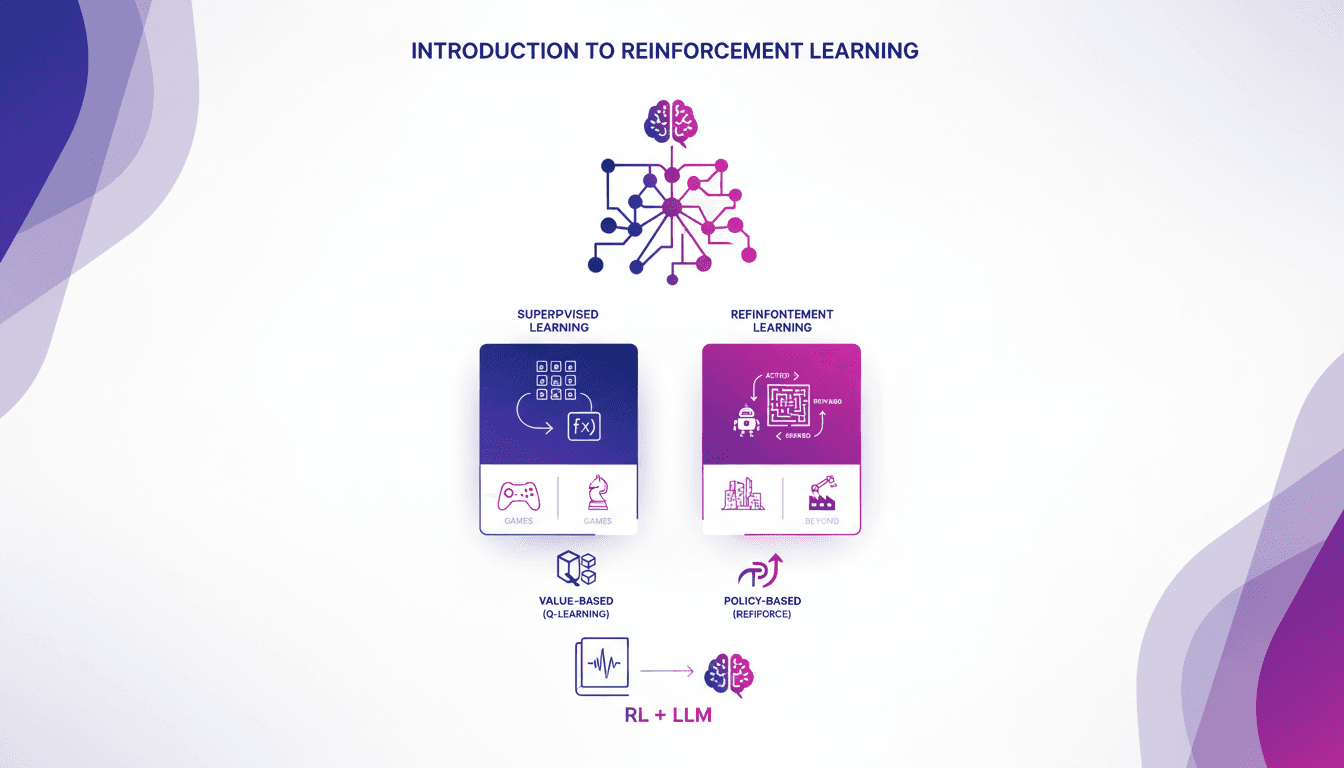

Introduction pratique à l'apprentissage renforcé

Je me souviens de ma première rencontre avec le renforcement de l'apprentissage. C'était comme débloquer un nouveau niveau dans un jeu, où les algorithmes apprennent par essai et erreur, tout comme nous. Contrairement à l'apprentissage supervisé, le RL ne s'appuie pas sur des jeux de données étiquetés. Il apprend des conséquences de ses actions. D'abord, on compare le RL à l'apprentissage supervisé, puis on plonge dans ses applications réelles, notamment dans les jeux. Je vous guiderai à travers les méthodes basées sur la valeur, comme le Q-learning, et les méthodes basées sur la politique, en montrant comment ces approches transforment des modèles de langage massif. En fin de compte, vous verrez comment trois manières clés d'utiliser le RL pour affiner les grands modèles de langage offrent des résultats impressionnants.

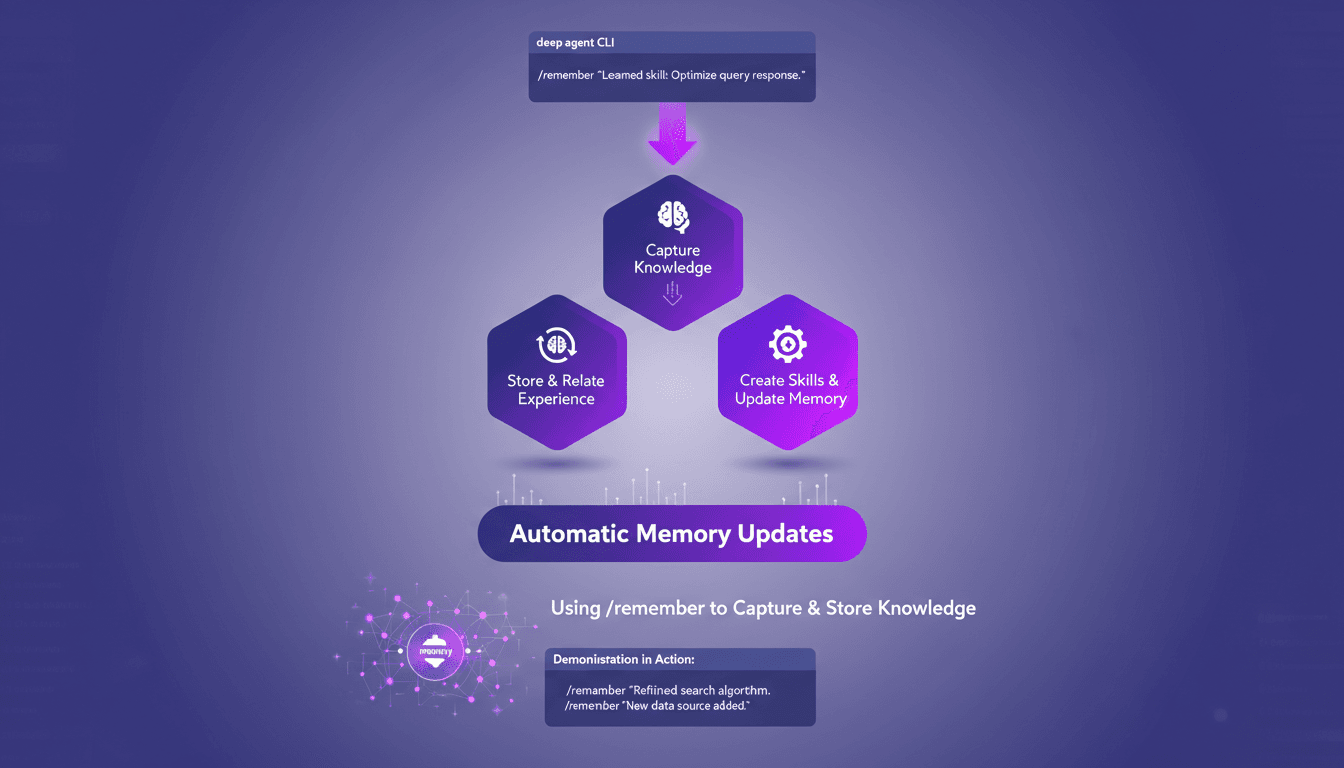

Optimisez les agents profonds avec /remember

J'ai passé d'innombrables heures à peaufiner les configurations des agents profonds, et je peux vous dire que la commande /remember est un véritable changement de jeu. C'est comme donner à votre agent un cerveau qui retient vraiment les informations utiles. Laissez-moi vous montrer comment je l'utilise pour rationaliser les processus et améliorer l'efficacité. Avec la commande /remember dans le CLI des agents profonds, vous pouvez enseigner aux agents à apprendre de l'expérience. On va plonger dans le fonctionnement de tout ça et pourquoi c'est un indispensable dans votre arsenal.

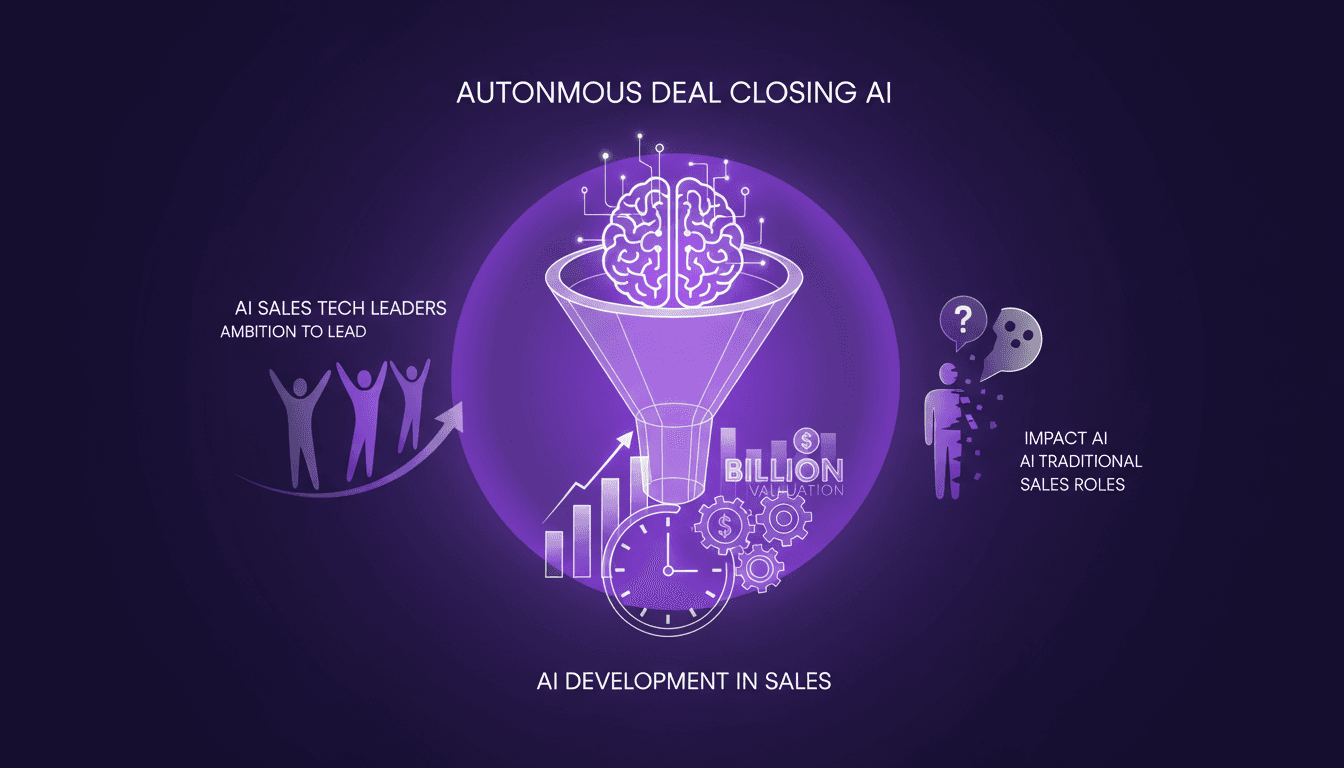

IA Autonome : Révolutionner les Ventes

J'ai passé assez de temps dans la vente pour voir les tendances aller et venir. Mais le jour où j'ai intégré l'IA dans mon pipeline de vente, tout a changé. Ce n'était pas juste un nouveau gadget; j'ai vu l'IA conclure des contrats de façon autonome, et là j'ai su que c'était révolutionnaire. L'IA prend en charge tout le processus de vente, de la génération de prospects à la conclusion, sans intervention humaine. Avec une équipe ambitieuse et des développements à la pelle, on vise un avenir où l'IA redéfinit le rôle du vendeur. En 12 mois, on pourrait bien voir une entreprise valoir des milliards grâce à cette technologie. Plongeons dans ce qui rend cela possible.

Séquence de Compte à Rebours: Maîtriser le Timing

J'orchestre des événements depuis des années, et s'il y a une chose que j'ai apprise, c'est le pouvoir d'un compte à rebours bien exécuté. Que ce soit pour le lancement d'un produit ou le début d'un événement en direct, la séquence de compte à rebours peut faire ou défaire l'expérience. Dans ce tutoriel, je vous montre comment je configure des séquences qui ne se contentent pas de s'aligner parfaitement, mais qui ajoutent aussi une couche d'excitation et d'anticipation. Premier conseil : ne sous-estimez jamais la symbolique du compte à rebours, cette montée de tension qui précède le grand moment. On commence par synchroniser les timings, puis on s'assure que chaque étape est en place avant le grand lancement. Prêt à transformer l'ordinaire en extraordinaire ?