Optimiser l'UX avec LangChain et Typescript

Je me souviens de la première fois où j'ai affronté des interfaces utilisateurs lentes en travaillant avec des outils d'agents. C'était frustrant, surtout quand on veut impressionner un client avec du traitement de données en temps réel. C'est là que j'ai commencé à intégrer des événements de flux personnalisés avec LangChain. Dans cet article, je vais vous montrer comment configurer une interface utilisateur réactive en utilisant LangChain, React et Typescript. Nous plongerons dans les événements de flux personnalisés, la fonction config.writer, et le déploiement avec le serveur de développement langraph. Si vous avez déjà perdu du temps avec des appels d'outils qui traînent, ce tutoriel est pour vous.

Je me souviens de la première fois où j'ai dû faire face à ces interfaces utilisateur qui traînent quand je travaillais avec des outils d'agents. C'était presque rageant, surtout quand on essaie d'impressionner un client avec du traitement de données en temps réel. J'ai donc commencé à intégrer des événements de flux personnalisés avec LangChain, et là, ça a vraiment changé la donne pour moi. Dans cet article, je vais vous guider pour configurer une interface utilisateur réactive en utilisant LangChain, React et Typescript. On va entrer dans le vif du sujet avec les événements de flux personnalisés, voir comment utiliser la fonction config.writer, et déployer avec le serveur de développement langraph. Je vais vous montrer comment identifier et rendre ces événements personnalisés, tout en utilisant des fonctions d'assistance pour taper les objets de données. L'objectif, c'est d'offrir un retour immédiat pour ces appels d'outils qui peuvent prendre une seconde ou deux de plus que prévu. Et croyez-moi, ça vaut bien ces 500 millisecondes d'attente arbitraire. Si vous êtes prêt à optimiser vos interfaces agent, suivez le guide.

Configurer des Événements de Flux Personnalisés

Dans le développement d'applications modernes, une UI réactive est essentielle pour offrir une expérience utilisateur fluide. J'ai intégré des événements de flux personnalisés pour améliorer l'interactivité de mes applications, et croyez-moi, ça change la donne. D'abord, je me suis plongé dans l'intégration des événements de flux dans LangChain.

Tout commence par l'implémentation des événements de flux personnalisés. Ces événements permettent à l'application d'être plus réactive pendant l'exécution des outils. L'idée est de donner des retours constants à l'utilisateur, même si l'appel d'un outil prend du temps. Avec LangChain, cela se fait par l'utilisation d'événements identifiés par un type et un ID d'appel d'outil spécifique.

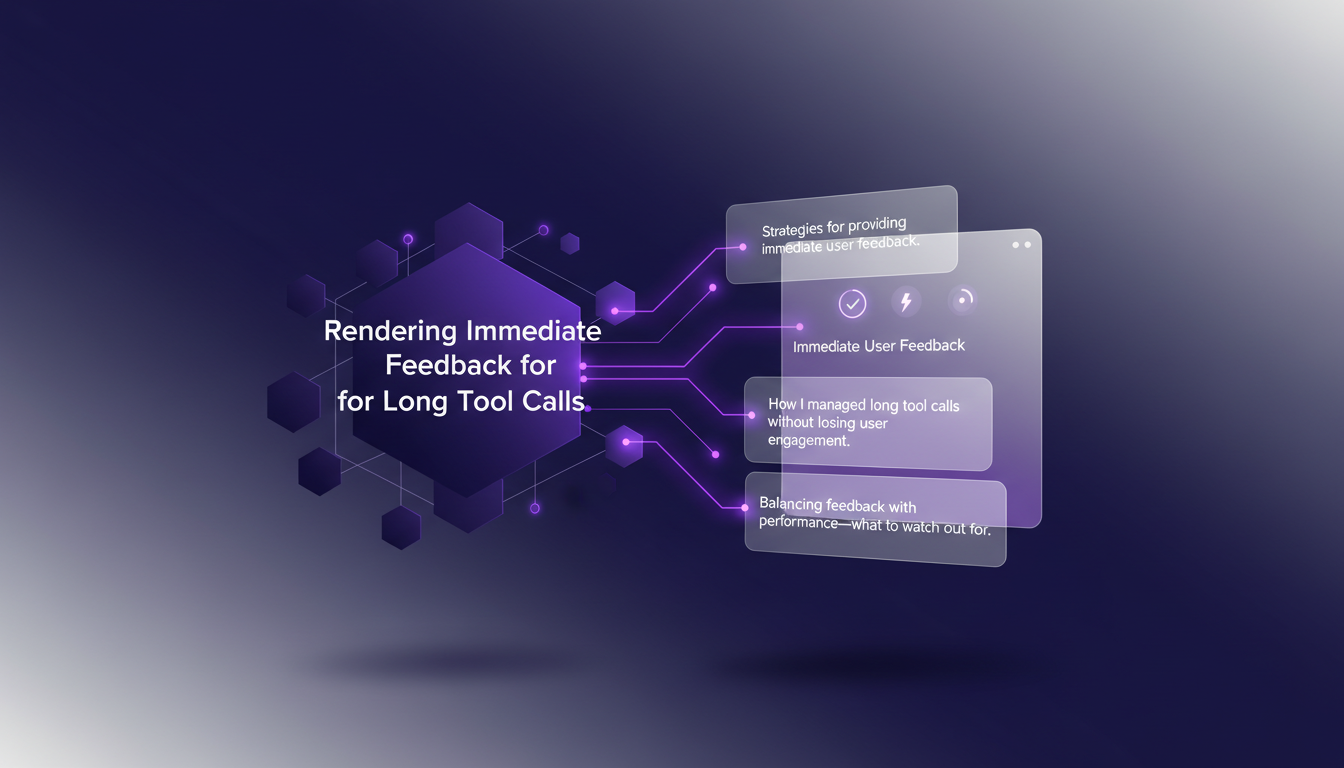

Un point crucial à surveiller est le temps d'attente de 500 millisecondes que j'ai dû ajuster. Il faut trouver le bon équilibre pour ne pas surcharger l'application.

Utilisation de la Fonction Config.writer

La fonction config.writer joue un rôle clé dans la gestion des flux d'événements. Elle permet d'envoyer des événements arbitraires à l'interface utilisateur pendant l'exécution d'un outil. Je l'ai utilisée pour optimiser les flux d'événements et, franchement, ça simplifie énormément le processus.

En pratique, j'ai utilisé config.writer pour envoyer des mises à jour de progression aux utilisateurs. Par exemple, en intégrant des étapes de progression comme 'connexion', 'récupération', 'traitement', et 'génération'. Cela permet de rendre l'application plus interactive et engageante.

Attention toutefois aux compromis : plus de complexité peut affecter les performances. Il faut évaluer si les avantages en valent la peine.

Typage des Données avec Fonctions d'Aide et Typescript

Le typage des données est crucial pour la stabilité et la clarté du code. J'ai utilisé des fonctions d'aide pour typer les objets de données reçus à l'interface utilisateur. Cela garantit que les données sont correctement traitées, réduisant ainsi les erreurs potentielles.

L'intégration de Typescript a été un véritable atout. Cela m'a permis de gérer les données de manière plus fluide et efficace. Cependant, quelques pièges courants existent, comme la mauvaise typage qui peut entraîner des erreurs difficiles à déboguer.

Rendu de Feedback Immédiat pour les Appels d'Outils Longs

Garder l'utilisateur engagé pendant les appels d'outils longs est un défi, mais il existe des stratégies efficaces. J'ai trouvé que fournir un feedback immédiat fait toute la différence. Cela évite à l'utilisateur de penser que l'application est bloquée.

Par exemple, dans un de mes projets, j'ai intégré des événements de flux personnalisés pour afficher des mises à jour en direct pendant que l'outil travaillait en arrière-plan. C'était un véritable changement de jeu pour l'expérience utilisateur.

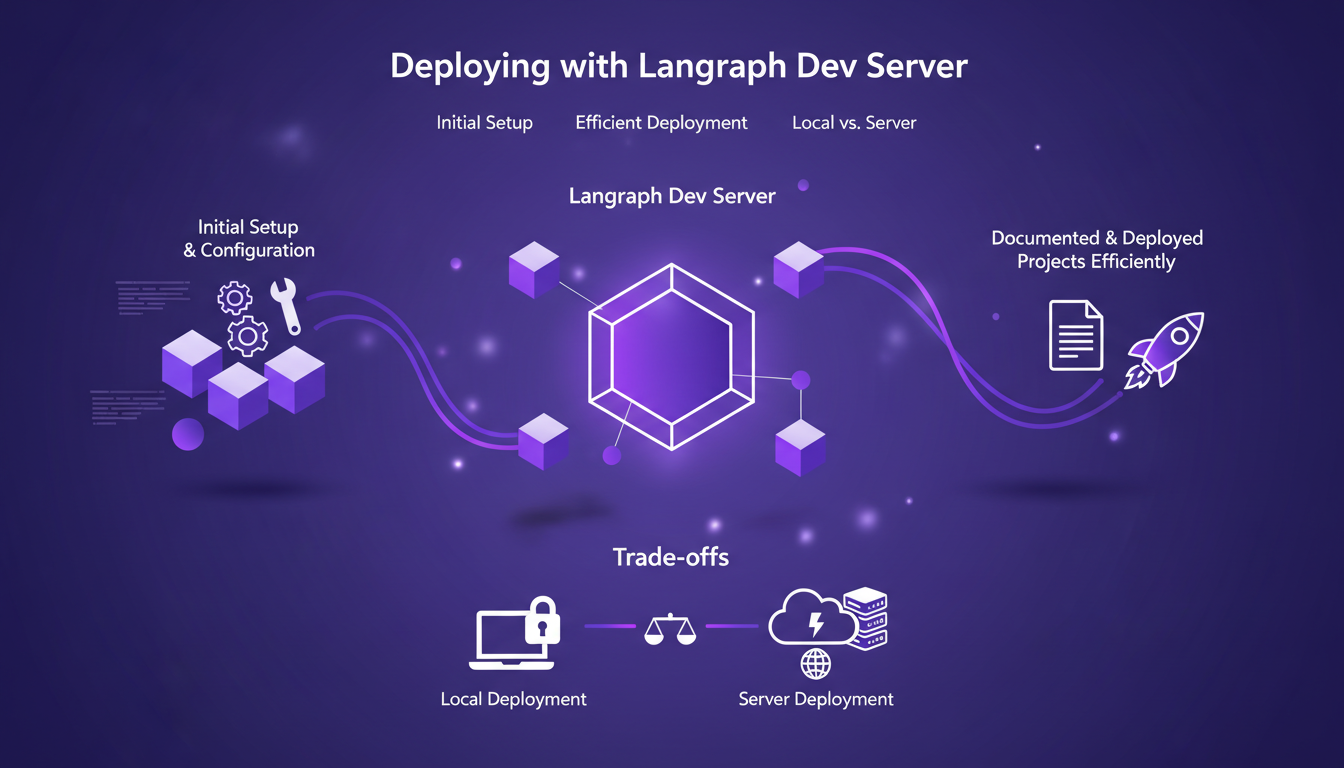

Déploiement avec Langraph Dev Server

Le déploiement est souvent une étape critique. Avec le langraph dev server, j'ai pu documenter et déployer mes projets efficacement. La configuration initiale est simple, mais attention aux erreurs courantes.

J'ai noté que le choix entre un déploiement local et serveur peut avoir un impact significatif sur les performances et le coût. Chacun a ses avantages et inconvénients, et il faut choisir en fonction des besoins spécifiques de chaque projet.

En conclusion, en suivant ces étapes et en évitant les pièges courants, j'ai pu améliorer la réactivité de mes applications tout en gardant un œil sur les performances et les coûts. Pour plus de détails, consultez nos articles sur Streaming Agent Messages in React avec LangChain.

En intégrant des événements de flux personnalisés et en exploitant les capacités de LangChain, j'ai vraiment boosté la réactivité de mes projets. Voici quelques points clés que j'ai tirés de mon expérience :

- Événements de flux personnalisés : Ils sont cruciaux pour améliorer la performance sans sacrifier l'expérience utilisateur. Attention toutefois à ne pas surcharger le système.

- Fonction

config.writer: Je l'utilise pour personnaliser l'écriture de mes flux, ce qui m'a permis de réduire l'attente arbitraire de 500 millisecondes. - Identification et rendu des événements : Une bonne gestion de ces aspects est essentielle pour éviter des temps d'attente inutiles.

- Fonctions d'assistance : Elles sont indispensables pour taper correctement les objets de données et garantir la fluidité du processus.

Regarder vers l'avenir, c'est imaginer comment ces stratégies peuvent transformer l'engagement utilisateur. Je vous encourage à essayer ces méthodes dans vos projets. Partagez vos expériences et continuons ensemble à développer de meilleurs outils.

Pour une compréhension plus complète, je vous recommande vivement de regarder la vidéo originale : "Build Better Agent UX: Streaming Progress, Status, and File Ops with LangChain" sur YouTube. Voyez comment ces concepts peuvent être un véritable game changer, tout en gardant à l'esprit les limites et compromis nécessaires. Regardez ici.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

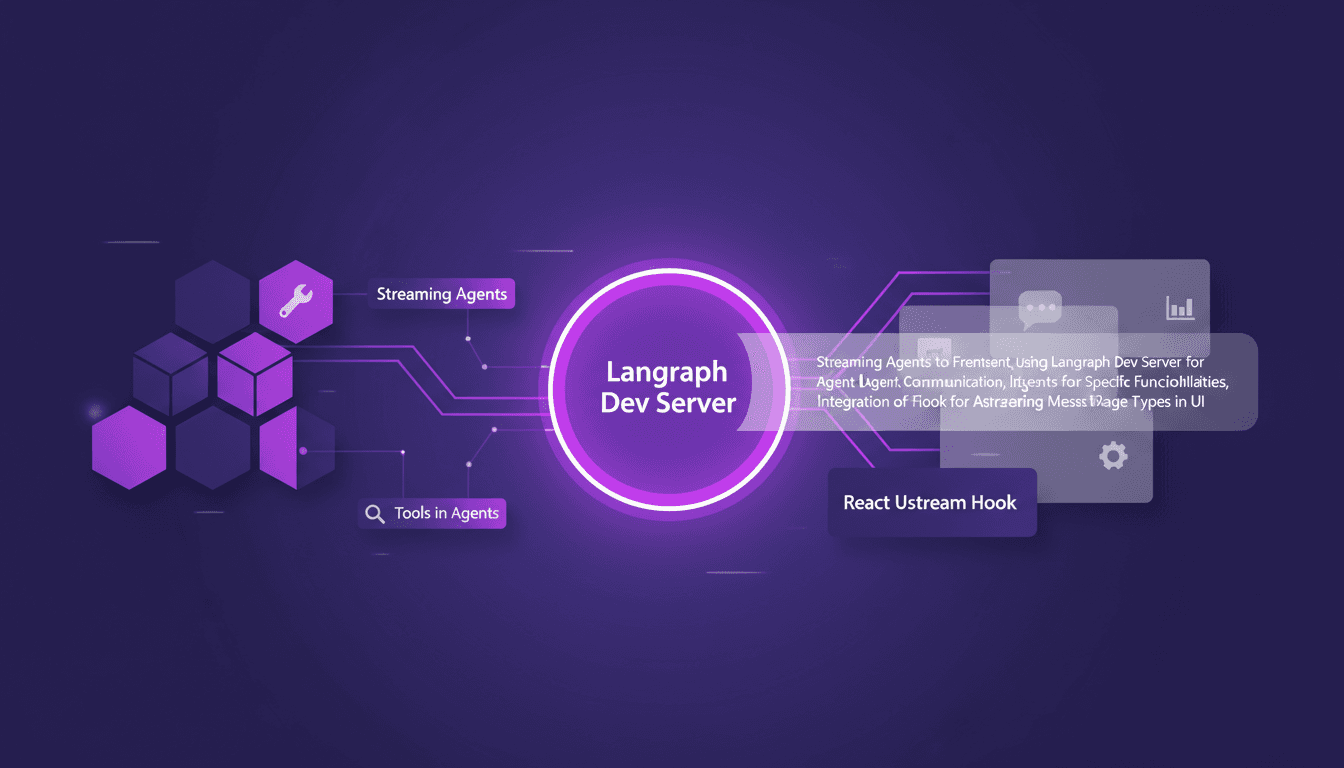

LangChain et React: Messages d'agents en streaming

Je me souviens de la première fois où j'ai tenté de streamer des messages d'agents dans une application React. C'était un vrai bazar... jusqu'à ce que je découvre LangChain et Langraph. Je vais vous expliquer comment j'ai configuré tout ça pour créer une interaction fluide entre le frontend et les agents IA. Dans ce tutoriel, je vous montre comment connecter LangChain et React en utilisant Langraph Dev Server. On plongera dans le streaming de messages d'agents, avec des outils comme la météo et la recherche web, et on verra comment les rendre efficacement dans l'interface utilisateur. Vous verrez comment j'intègre ces messages grâce au hook React Ustream, et comment je gère différents types de messages dans l'UI. Prêt à transformer vos interactions IA ? Allons-y.

Marketing B2B 2026 : L'impact de l'IA et LinkedIn

J'étais à CES 2026, plongé dans le voyage transformationnel de LinkedIn. D'abord, la montée en puissance du contenu vidéo m'a sauté aux yeux—ce n'est pas juste une tendance, c'est le nouveau standard. Avec 71% des décisions B2B maintenant influencées par la Gen Z et les millennials, l'évolution de LinkedIn en plateforme vidéo est logique. Décryptons comment l'IA et les insights en temps réel redéfinissent le marketing B2B. LinkedIn fête ses 22 ans, et ils ne dorment pas sur leurs lauriers. Des outils comme Gong aux discussions sur la santé mentale, ils ouvrent la voie à une nouvelle ère du marketing B2B.

Embeddings Multimodaux Quen 3: Guide Pratique

Je me suis plongé dans les embeddings multimodaux de Qwen 3, avec l'objectif de rationaliser mes projets AI. La promesse ? Une précision et une efficacité accrues dans plus de 30 langues. D'abord, j'ai connecté les modèles d'embedding, puis j'ai orchestré les rerankers pour des recherches plus efficaces. Les résultats ? Un modèle qui atteint 85 % de précision, un véritable game changer. Mais attention, chaque outil a ses limites et Qwen 3 ne fait pas exception. Je vous explique comment j'ai configuré tout ça et l'impact réel que ça a eu.

Tutoriel Cling Motion Transfer: Maîtrisez-le

Je me souviens encore de la première fois où j'ai essayé le Cling Motion Transfer. C'était une vraie révolution. Pour moins d'un dollar, j'ai transformé une simple vidéo en un contenu viral. Dans cet article, je vais vous montrer comment je l'ai fait, étape par étape. Cling Motion Transfer est un outil AI abordable qui se distingue dans le monde de la création vidéo, surtout pour les plateformes comme TikTok. Mais attention, comme tout outil, il a ses caprices et ses limites. Je vais vous guider à travers le choix des images et vidéos, l'utilisation des prompts, et comment finaliser et soumettre votre contenu AI. C'est parti.

TTS Ultra Rapide sur CPU: Clonage Vocal 2026

Je me souviens encore de ma première tentative avec un modèle de synthèse vocale sur mon CPU grand public. C'était lent, frustrant, comme un retour vers le passé. Mais le modèle TTH a changé la donne. Imaginez atteindre des performances TTS ultra-rapides sur un matériel standard, avec en prime un clonage vocal bluffant. Dans cet article, je vous guide à travers cette innovation de 2026 : de la configuration technique aux comparaisons avec d'autres modèles, et comment vous pouvez intégrer cela dans vos projets. Si vous êtes développeur ou simplement un passionné, vous allez vouloir voir ça.