Embeddings Multimodaux Quen 3: Guide Pratique

Je me suis plongé dans les embeddings multimodaux de Qwen 3, avec l'objectif de rationaliser mes projets AI. La promesse ? Une précision et une efficacité accrues dans plus de 30 langues. D'abord, j'ai connecté les modèles d'embedding, puis j'ai orchestré les rerankers pour des recherches plus efficaces. Les résultats ? Un modèle qui atteint 85 % de précision, un véritable game changer. Mais attention, chaque outil a ses limites et Qwen 3 ne fait pas exception. Je vous explique comment j'ai configuré tout ça et l'impact réel que ça a eu.

J'ai plongé tête la première dans les embeddings multimodaux de Qwen 3, avec un objectif clair : optimiser mes projets AI. Dès que j'ai connecté les modèles, j'ai vu le potentiel. Avec une précision de 85 % et la capacité de fonctionner dans plus de 30 langues, on parle d'un véritable bond en avant pour la multimodalité. J'ai d'abord configuré les embeddings pour m'assurer qu'ils capturent efficacement les nuances entre images et textes. Ensuite, j'ai orchestré les rerankers pour hiérarchiser les résultats de manière plus fine. Attention, cependant, à ne pas sous-estimer la phase de calibration : chaque modèle a ses spécificités et ses limites, et Qwen 3 ne fait pas exception. En termes de cas d'usage, j'ai pu intégrer ces modèles dans mes workflows pour des recherches plus rapides et précises. Je vous explique comment j'ai fait et pourquoi cela pourrait bien changer la donne pour vous aussi.

Mise en place des embeddings multimodaux de Quen 3

La première étape de l'intégration du modèle Quen 3 dans mon système existant a été un véritable changement de jeu. Tout d'abord, j'ai intégré le modèle à mon infrastructure, et là, la fenêtre de contexte de 32K s'est révélée être un atout majeur pour gérer des entrées de données complexes. Cela a permis d'analyser des volumes de données bien plus importants sans perdre en précision. Cependant, il faut être vigilant avec la taille d'embedding de 4096 ; elle nécessite une orchestration minutieuse pour éviter les ralentissements ou les erreurs de traitement. J'ai atteint une précision de 85 % uniquement avec le modèle d'embedding, ce qui est impressionnant quand on connaît les défis posés par les données multimodales.

Fonctionnalité et applications des embeddings multimodaux

Les embeddings multimodaux comblent le fossé entre les données textuelles et visuelles, permettant une similarité sémantique accrue dans mes projets. J'ai utilisé cette technologie pour améliorer la recherche sémantique, ce qui a eu un impact direct sur l'optimisation des moteurs de recherche et des systèmes de recommandation. Mais attention, il ne faut pas abuser des embeddings ; il est souvent plus économique de combiner ces nouvelles méthodes avec des approches traditionnelles.

- Optimisation des moteurs de recherche

- Amélioration des systèmes de recommandation

- Analyse de contenu vidéo

Pour plus d'informations sur la mise en œuvre efficace de ces méthodes, consultez ce guide étape par étape.

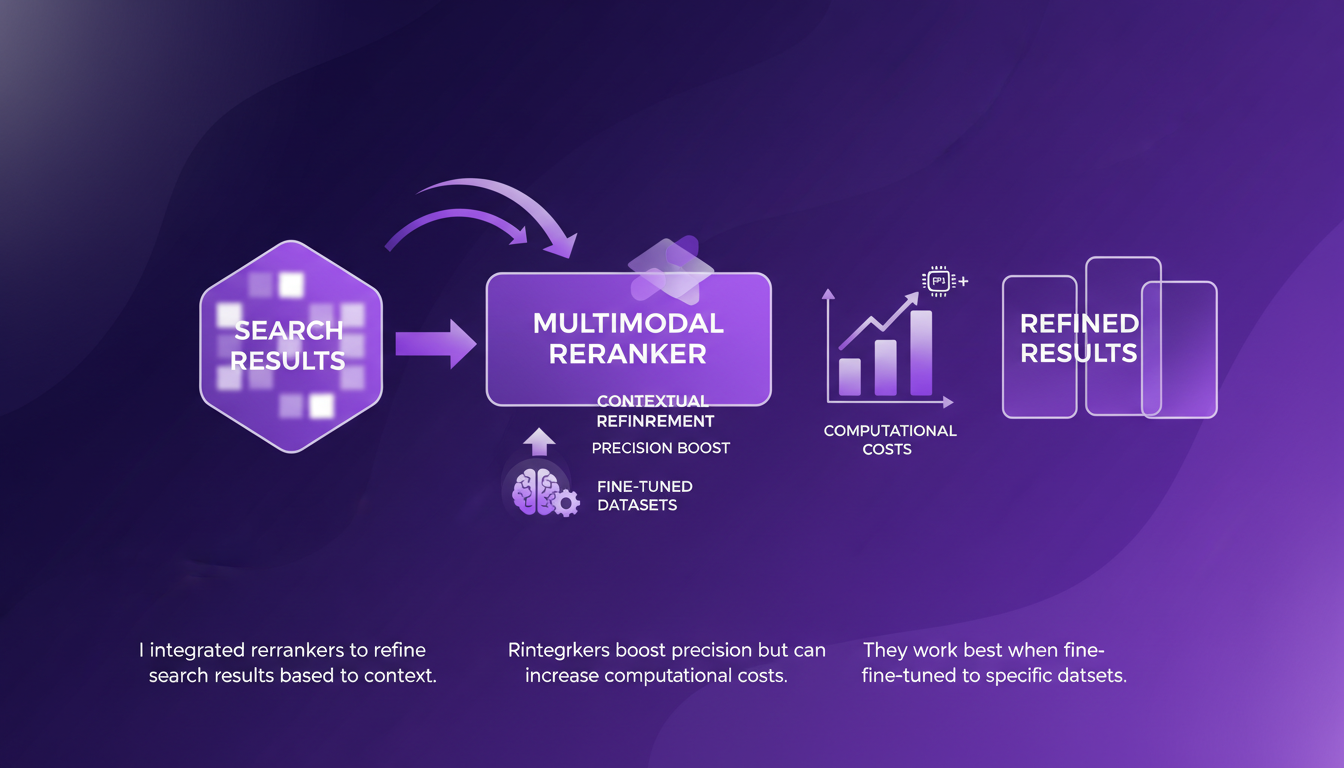

Rôle et configuration des modèles de reranking multimodal

Les rerankers jouent un rôle crucial dans le raffinement des résultats de recherche basés sur le contexte. J'ai intégré ces rerankers pour améliorer la précision des recherches, mais il faut être conscient que cela peut augmenter les coûts computationnels. Ils sont particulièrement efficaces lorsqu'ils sont ajustés sur des jeux de données spécifiques. Avant un déploiement complet, il est essentiel de prendre en compte les limitations matérielles pour éviter les mauvaises surprises.

Spécifications techniques et impact réel

Les modèles Quen 3 prennent en charge plus de 30 langues, ce qui est idéal pour les projets à portée mondiale. Le modèle de 8 milliards de paramètres peut sembler écrasant, mais commencer avec des modèles plus petits peut être une excellente stratégie de déploiement. En pratique, les applications vont des recherches translinguistiques aux chatbots multilingues. J'ai constaté un impact direct sur le business avec une augmentation de l'engagement utilisateur.

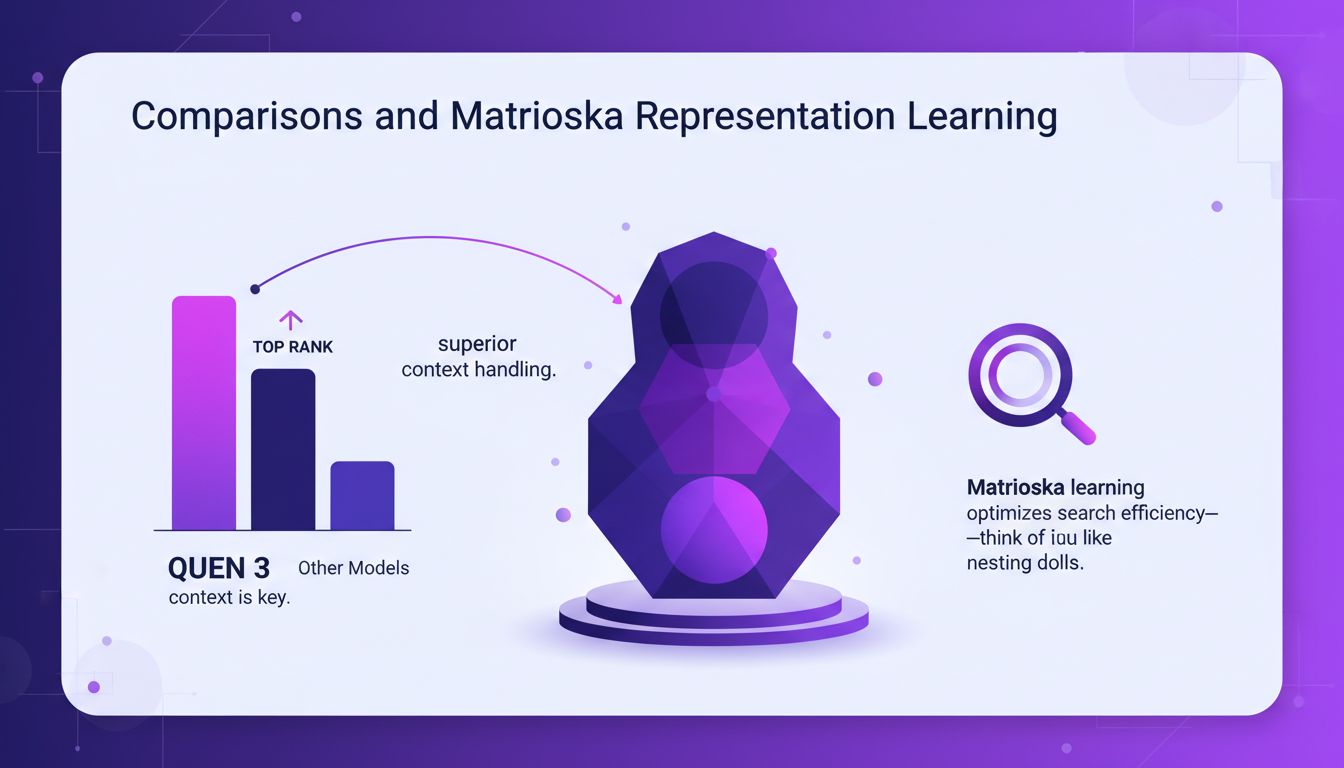

Comparaisons et apprentissage par représentation Matrioska

Sur les classements, Quen 3 se positionne en tête, mais le contexte reste déterminant. L'apprentissage par représentation Matrioska optimise l'efficacité des recherches, un peu comme des poupées russes qui s'emboîtent les unes dans les autres. Comparé à d'autres modèles, Quen 3 offre une gestion supérieure du contexte. Évaluez vos besoins ; parfois, les modèles plus simples suffisent amplement.

| Modèle | Classement | Commentaires |

|---|---|---|

| Quen 3 8B | #1 | Meilleure gestion de contexte |

| Modèle plus petit | #5 | Surpasse certains plus grands modèles 7B |

Avec Qwen 3, j'ai complètement transformé ma façon d'aborder les projets AI. Les embeddings multimodaux et rerankers ont vraiment changé la donne, surtout en termes de précision et d'applications concrètes. Voici ce que j'ai retenu :

- Précision de 85% : Grâce au modèle d'embedding, j'ai obtenu des résultats d'une précision impressionnante, mais attention à la complexité qui peut surgir.

- Support multilingue : Avec plus de 30 langues gérées, c'est un atout majeur pour des projets globaux.

- Applications réelles : Les rerankers multimodaux permettent d'améliorer les résultats de manière tangible, mais il faut trouver le bon équilibre entre complexité et praticité.

En regardant vers l'avenir, je suis convaincu que ces outils vont continuer à repousser les limites de ce qu'on peut faire avec l'AI. Mais restons vigilants quant aux compromis à faire pour ne pas alourdir nos systèmes.

Prêt à intégrer Qwen 3 dans votre flux de travail ? Plongez-y et partagez vos expériences ! Pour plus de détails, je vous recommande de regarder la vidéo complète : Qwen3 Multimodal Embeddings and Rerankers. Ça vaut le coup d'œil pour n'importe qui cherchant à optimiser ses projets AI.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

DSPI : Révolutionner l'Ingénierie de Prompt

J'ai plongé dans DSPI et croyez-moi, ce n'est pas juste un autre framework — c'est un véritable changement de jeu pour l'ingénierie de prompt. Au début, j'étais sceptique, mais en voyant son approche modulaire en action, j'ai réalisé le potentiel d'efficacité et de flexibilité. Avec DSPI, on simplifie les tâches complexes grâce à un cadre déclaratif, ce qui est une avancée majeure. Et cette modularité ? Elle permet une gestion optimisée des entrées, que ce soit des textes ou des images. Imaginez, pour une tâche de classification, seulement trois images suffisent pour obtenir des résultats précis. C'est cette capacité à gérer des entrées multimodales qui distingue DSPI des autres frameworks. Que ce soit pour le développement de logiciels modulaires ou l'optimisation des métriques, DSPI ne se contente pas de faire le travail, il le réinvente.

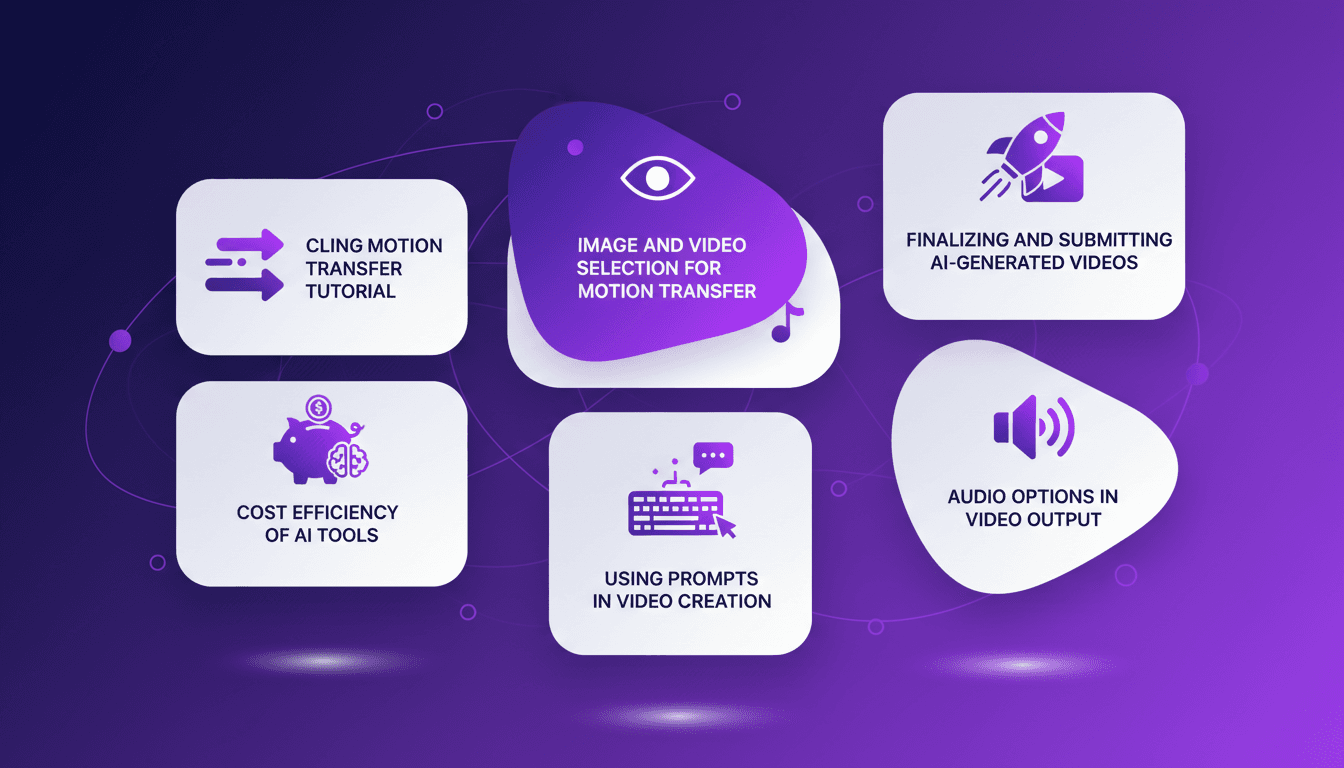

Tutoriel Cling Motion Transfer: Maîtrisez-le

Je me souviens encore de la première fois où j'ai essayé le Cling Motion Transfer. C'était une vraie révolution. Pour moins d'un dollar, j'ai transformé une simple vidéo en un contenu viral. Dans cet article, je vais vous montrer comment je l'ai fait, étape par étape. Cling Motion Transfer est un outil AI abordable qui se distingue dans le monde de la création vidéo, surtout pour les plateformes comme TikTok. Mais attention, comme tout outil, il a ses caprices et ses limites. Je vais vous guider à travers le choix des images et vidéos, l'utilisation des prompts, et comment finaliser et soumettre votre contenu AI. C'est parti.

TTS Ultra Rapide sur CPU: Clonage Vocal 2026

Je me souviens encore de ma première tentative avec un modèle de synthèse vocale sur mon CPU grand public. C'était lent, frustrant, comme un retour vers le passé. Mais le modèle TTH a changé la donne. Imaginez atteindre des performances TTS ultra-rapides sur un matériel standard, avec en prime un clonage vocal bluffant. Dans cet article, je vous guide à travers cette innovation de 2026 : de la configuration technique aux comparaisons avec d'autres modèles, et comment vous pouvez intégrer cela dans vos projets. Si vous êtes développeur ou simplement un passionné, vous allez vouloir voir ça.

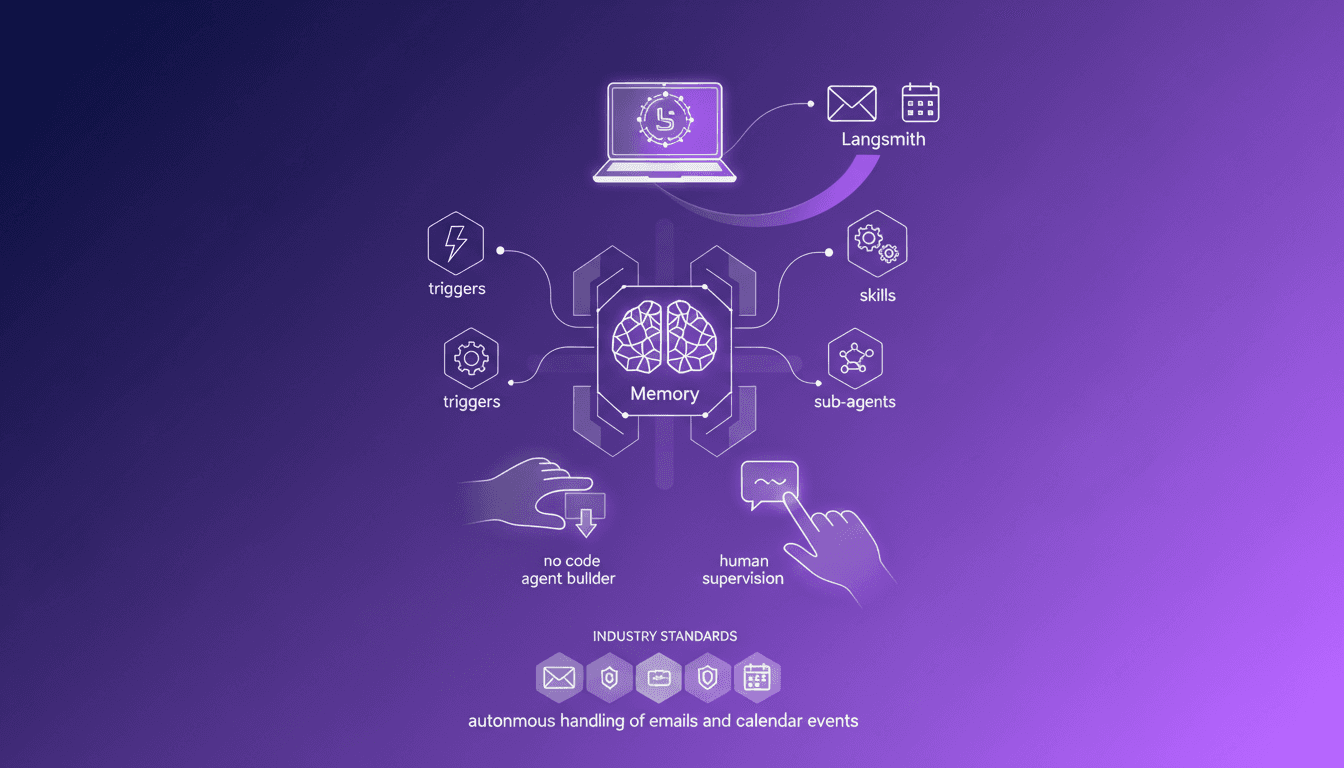

Construire un assistant email AI sans code

Vous avez déjà eu l'impression que votre boîte mail était un monstre indomptable ? Moi aussi, jusqu'à ce que je construise un assistant email AI avec le nouvel Agent Builder de LangSmith. Pas une ligne de code, juste de la pure magie d'automatisation. J'ai transformé le chaos en ordre avec un assistant qui gère mes emails et synchronise mon calendrier. Tout ça en conservant une supervision humaine et des possibilités de personnalisation. Dans cet article, je vous montre comment j'ai utilisé cette plateforme sans code pour alléger ma charge de travail quotidienne et optimiser l'efficacité. Si vous cherchez à dompter votre flux d'emails, c'est ici que ça se passe.

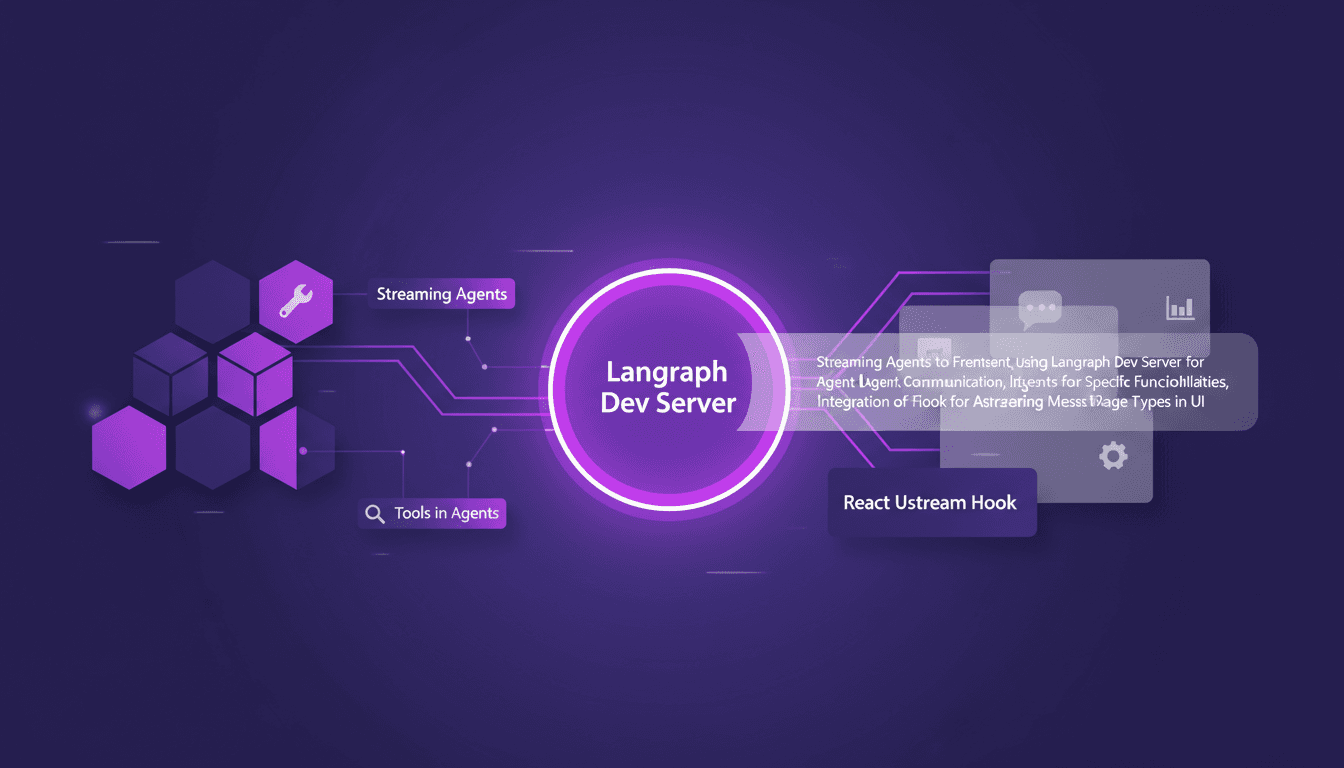

LangChain et React: Messages d'agents en streaming

Je me souviens de la première fois où j'ai tenté de streamer des messages d'agents dans une application React. C'était un vrai bazar... jusqu'à ce que je découvre LangChain et Langraph. Je vais vous expliquer comment j'ai configuré tout ça pour créer une interaction fluide entre le frontend et les agents IA. Dans ce tutoriel, je vous montre comment connecter LangChain et React en utilisant Langraph Dev Server. On plongera dans le streaming de messages d'agents, avec des outils comme la météo et la recherche web, et on verra comment les rendre efficacement dans l'interface utilisateur. Vous verrez comment j'intègre ces messages grâce au hook React Ustream, et comment je gère différents types de messages dans l'UI. Prêt à transformer vos interactions IA ? Allons-y.