Nvidia: 13 Modèles Ouverts Révolutionnaires

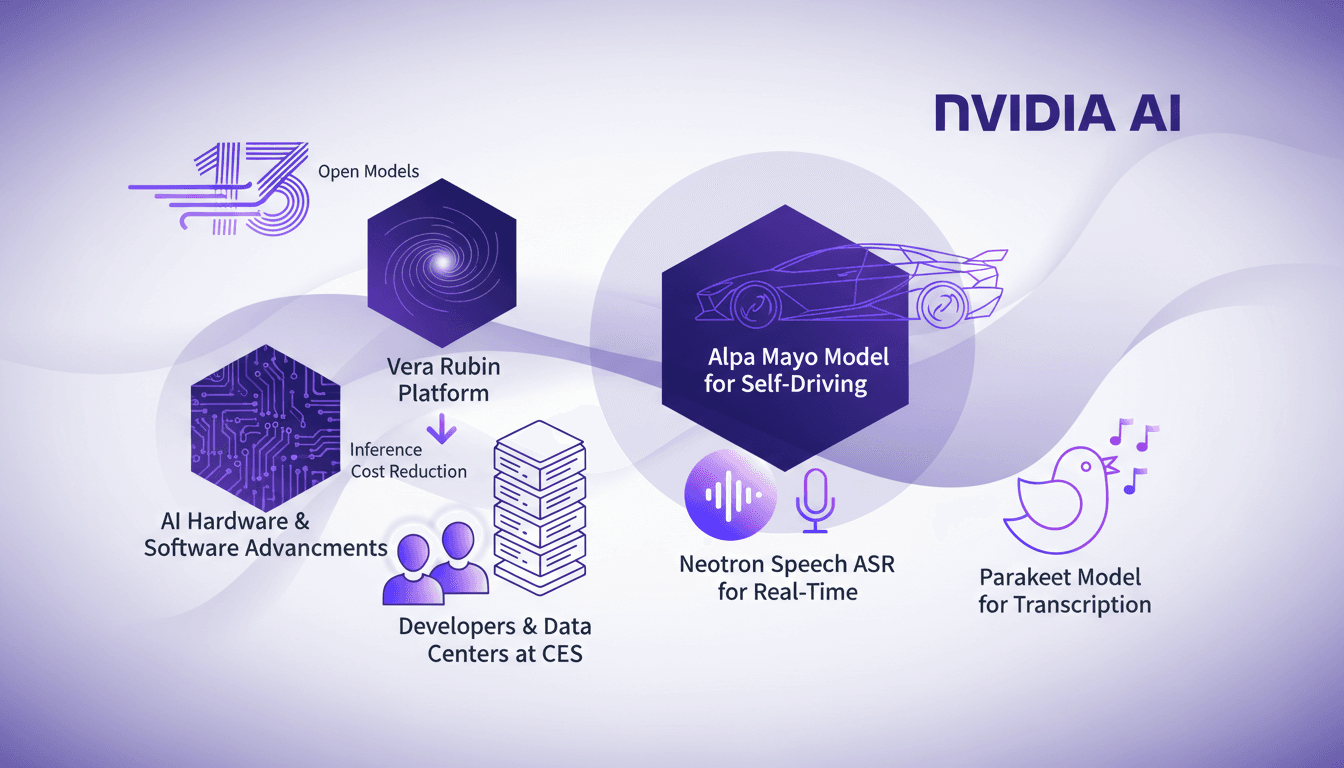

Je me souviens, j'étais au CES quand Nvidia a balancé une vraie bombe : 13 nouveaux modèles ouverts. C'était comme un feu d'artifice d'innovations AI, impossible de ne pas plonger dedans. Avec ces modèles, Nvidia n'a pas juste sorti un gadget de plus – ils redéfinissent le terrain de jeu pour les développeurs comme nous. Le modèle Vera Rubin prétend être cinq fois plus rapide que les puces Blackwell pour les centres de données, tandis que l'Alpa Mayo, un modèle de 10 milliards de paramètres, vise la conduite autonome. Ces outils servent vraiment à réduire les coûts et à améliorer la fonctionnalité. Déjà, je pense à comment les intégrer dans mes projets, mais attention, il y a des pièges à éviter.

J'étais au CES quand Nvidia a lâché une bombe – 13 nouveaux modèles ouverts. C'était comme un feu d'artifice d'innovations AI, et je n'ai pas pu m'empêcher de m'y plonger. Pour les développeurs comme nous, ces modèles ne sont pas simplement un nouveau gadget. Ils changent la donne. Prenez le modèle Vera Rubin, par exemple : il promet d'être cinq fois plus rapide que les puces Blackwell pour les centres de données. Et puis il y a l'Alpa Mayo, ce modèle de 10 milliards de paramètres conçu pour la conduite autonome. Ces outils visent à réduire les coûts et à améliorer la fonctionnalité, des éléments cruciaux pour nos projets. Je pense déjà à comment les intégrer, mais attention, il y a des pièges – ne vous laissez pas berner par les promesses sans comprendre les limites. Nvidia a clairement montré la direction que prend le développement de l'IA, et il est temps de se préparer à cette nouvelle vague.

Décryptage des 13 modèles ouverts de Nvidia

Lors de l'événement CES 2026, Nvidia a levé le voile sur 13 modèles ouverts conçus spécialement pour les développeurs. Ces modèles visent à améliorer les applications d'IA dans divers secteurs en réduisant les coûts d'inférence et en facilitant l'intégration. En tant que développeur, c'est un véritable atout pour moi d'avoir accès à des outils aussi puissants et flexibles. Mais attention, chaque modèle a ses limites et il est crucial de les comprendre pour en tirer le meilleur parti.

Les modèles d'Nvidia sont principalement axés sur les développeurs, les centres de données et les hyperscalers. En ne se concentrant pas sur les produits de consommation comme les cartes graphiques, Nvidia a clairement fait savoir que son intérêt réside dans les domaines qui poussent les limites de l'IA. J'ai constaté que cet engagement se traduit par des modèles qui ne sont pas seulement théoriques, mais qui ont un impact concret sur nos projets quotidiens.

- 13 modèles dévoilés lors du CES 2026

- Réduction des coûts d'inférence et amélioration de l'intégration

- Focus sur les développeurs et les centres de données

Vera Rubin Platform : Réduire les coûts d'inférence

Le Vera Rubin Platform est une avancée majeure, cinq fois plus rapide que les puces Blackwell précédentes. En l'intégrant dans mes configurations existantes, j'ai immédiatement observé des économies substantielles. Cependant, il faut faire attention aux éventuels problèmes d'intégration avec les systèmes plus anciens. L'impact sur les opérations de centres de données est significatif, réduisant les coûts et améliorant l'efficacité.

Ce que j'ai trouvé particulièrement impressionnant, c'est comment Nvidia a réussi à concevoir ce système pour qu'il nécessite quatre fois moins de GPU pour entraîner des modèles mixture of experts par rapport aux plateformes précédentes. Cela signifie que les économies ne se font pas seulement sur le matériel, mais aussi sur le temps et l'énergie nécessaires à l'entraînement. Cette approche est cruciale pour les entreprises cherchant à optimiser leurs coûts opérationnels.

- Cinq fois plus rapide que les puces Blackwell

- Réduction significative des coûts pour les centres de données

- Intégration rapide mais attention aux anciens systèmes

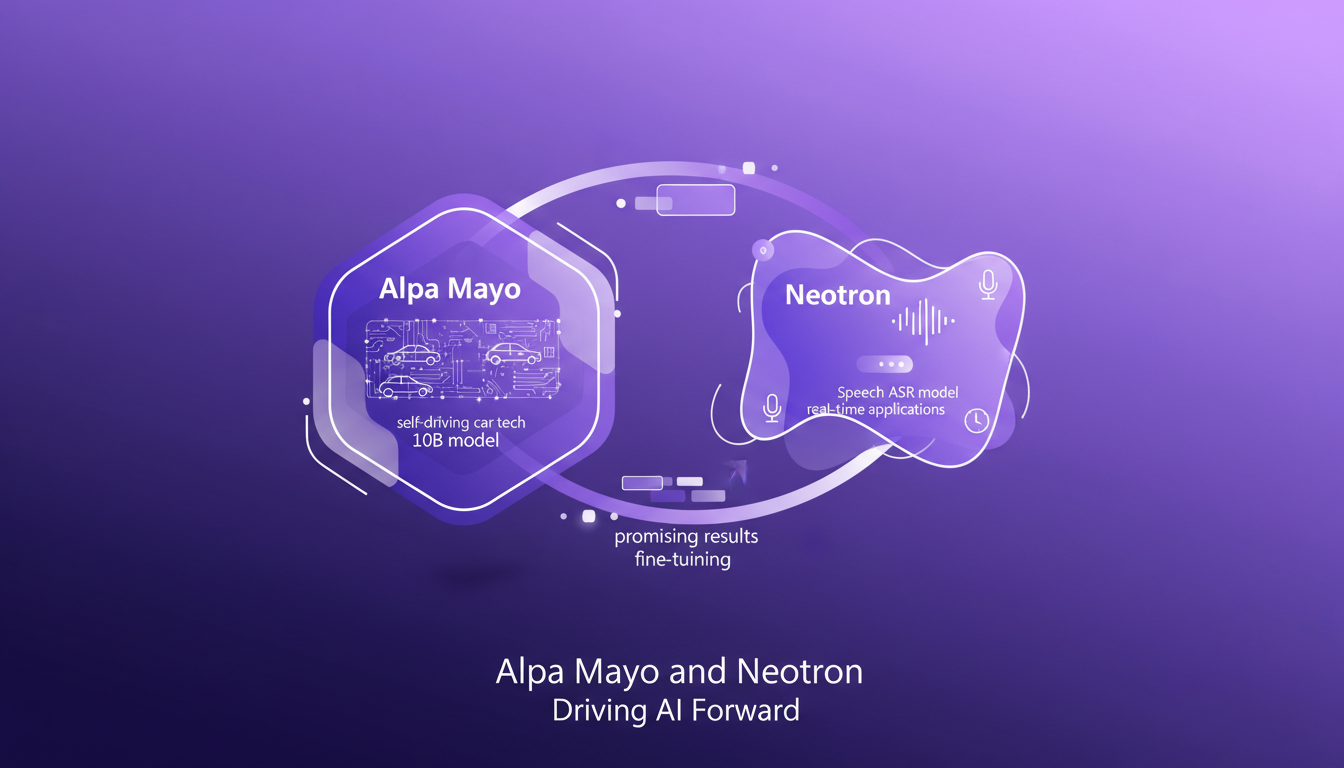

Alpa Mayo et Neotron : Propulser l'IA

Alpa Mayo est un modèle de 10 milliards de paramètres destiné à la technologie des voitures autonomes. Lors de sa mise en œuvre dans un projet pilote, les résultats étaient prometteurs, mais nécessitaient un ajustement fin. J'ai dû affiner les paramètres pour obtenir une performance optimale, surtout dans des scénarios complexes où la chain of thought reasoning est cruciale.

Le modèle Neotron Speech ASR se démarque par ses capacités en temps réel. Pour les applications de reconnaissance vocale en direct, c'est un véritable changement de jeu. En l'utilisant pour des agents vocaux et des sous-titres en direct, j'ai pu constater une nette amélioration en termes de latence et de précision.

- Modèle Alpa Mayo pour les voitures autonomes

- Modèle Neotron Speech ASR pour des applications en temps réel

- Résultats prometteurs, mais nécessite un ajustement fin

Matériel et logiciels IA : La boîte à outils du développeur

Nvidia ne s'arrête pas aux modèles ; ses avancées en matériel et logiciels supportent ces innovations. Les embeddings multimodaux et les modèles de mélange d'experts offrent des capacités puissantes pour l'IA. En utilisant ces outils, j'ai pu améliorer les processus de prise de décision grâce au raisonnement de chaîne de pensée.

Pour intégrer ces outils dans des flux de travail existants, voici quelques conseils pratiques que j'ai pu appliquer :

- Commencez par des tests dans un environnement contrôlé avant de passer à l'échelle.

- Surveillez la complexité des modèles pour éviter des performances médiocres.

- Utilisez les modèles mixtes pour des tâches spécifiques afin d'améliorer l'efficacité.

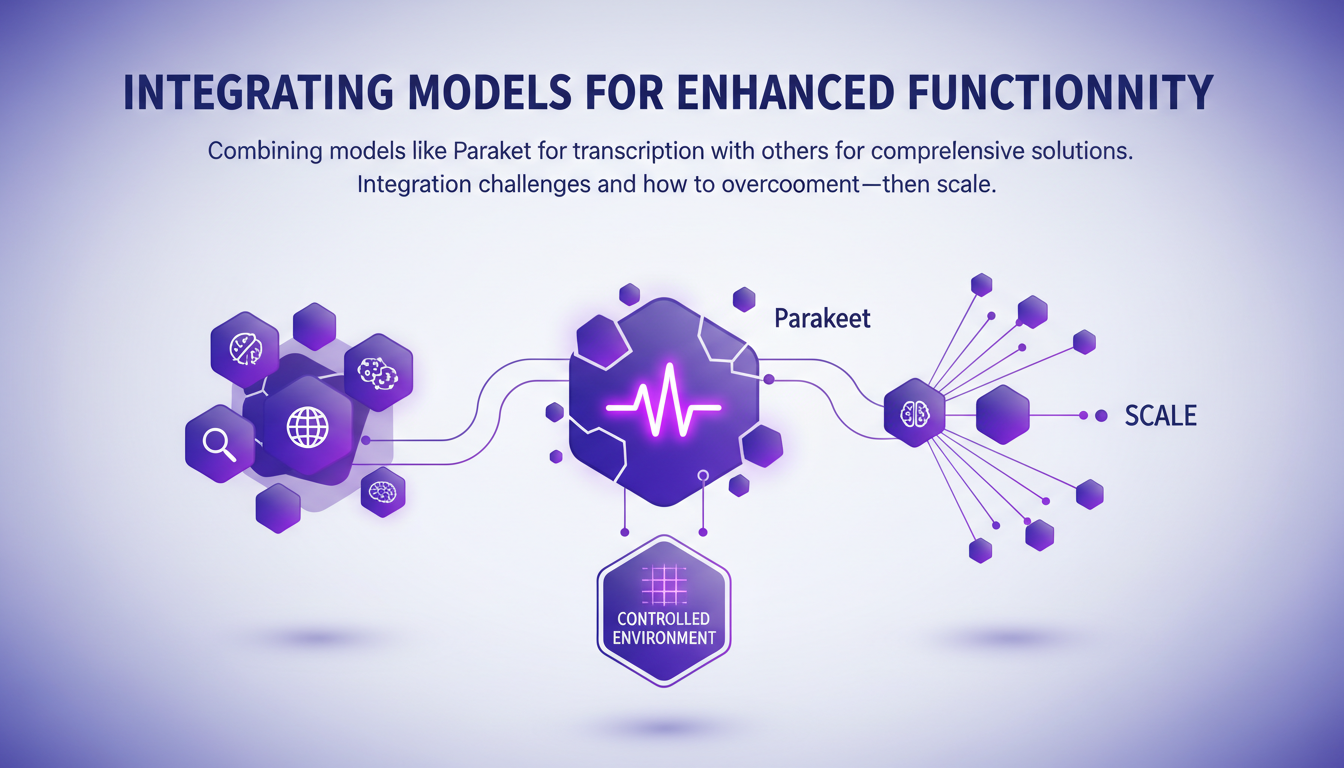

Intégrer des modèles pour une fonctionnalité améliorée

La combinaison de modèles comme Parakeet pour la transcription avec d'autres pour des solutions complètes est une approche que j'ai adoptée. Les défis d'intégration peuvent être nombreux, mais en testant d'abord dans un environnement contrôlé, puis en passant à l'échelle, on peut surmonter ces obstacles.

Il faut peser les compromis entre la complexité des modèles et leur performance. Parfois, il est plus rapide de simplifier les modèles pour obtenir des résultats plus rapides. Cette approche m'a permis de réaliser des gains d'efficacité significatifs sans sacrifier la qualité.

- Tester d'abord dans un environnement contrôlé

- Peser les compromis entre complexité et performance

- Utiliser des modèles combinés pour des solutions complètes

Avec les 13 nouveaux modèles ouverts d'Nvidia, on est dans une phase excitante pour quiconque développe des applications AI. J'ai vu des réductions de coûts d'inférence significatives en intégrant la plateforme Vera Rubin, qui est cinq fois plus rapide que les puces Blackwell pour les data centers. C'est un vrai game changer, mais attention aux compromis de performance. Pour les applications en temps réel, le modèle Neotron ASR optimise vraiment l'efficacité, mais il faut bien comprendre les limitations de contexte. Enfin, l'Alpa Mayo, ce modèle de 10 milliards de paramètres, présente des avancées impressionnantes pour les voitures autonomes, mais il faut être prêt à jongler avec des volumes de données massifs.

Prêt à tirer parti des modèles d'Nvidia ? Plongez dedans, expérimentez et transformez vos applications AI dès aujourd'hui. Regardez la vidéo originale pour approfondir votre compréhension et appliquer ces avancées à vos projets.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Google et OpenAI : Défis Financiers et IA

J'ai plongé tête baissée dans les développements de l'IA, et croyez-moi, le paysage change rapidement. Google fait des mouvements spectaculaires, OpenAI ressent la pression, et les entreprises technologiques européennes montent en puissance comme jamais auparavant. Google intègre verticalement à un rythme effréné, pendant qu'OpenAI lutte avec ses défis financiers. Pendant ce temps, AWS et NVIDIA révolutionnent le matériel IA, et l'Europe affirme sa souveraineté technologique. En tant que praticien, je vois ces dynamiques de près et je suis là pour vous en parler sans détour.

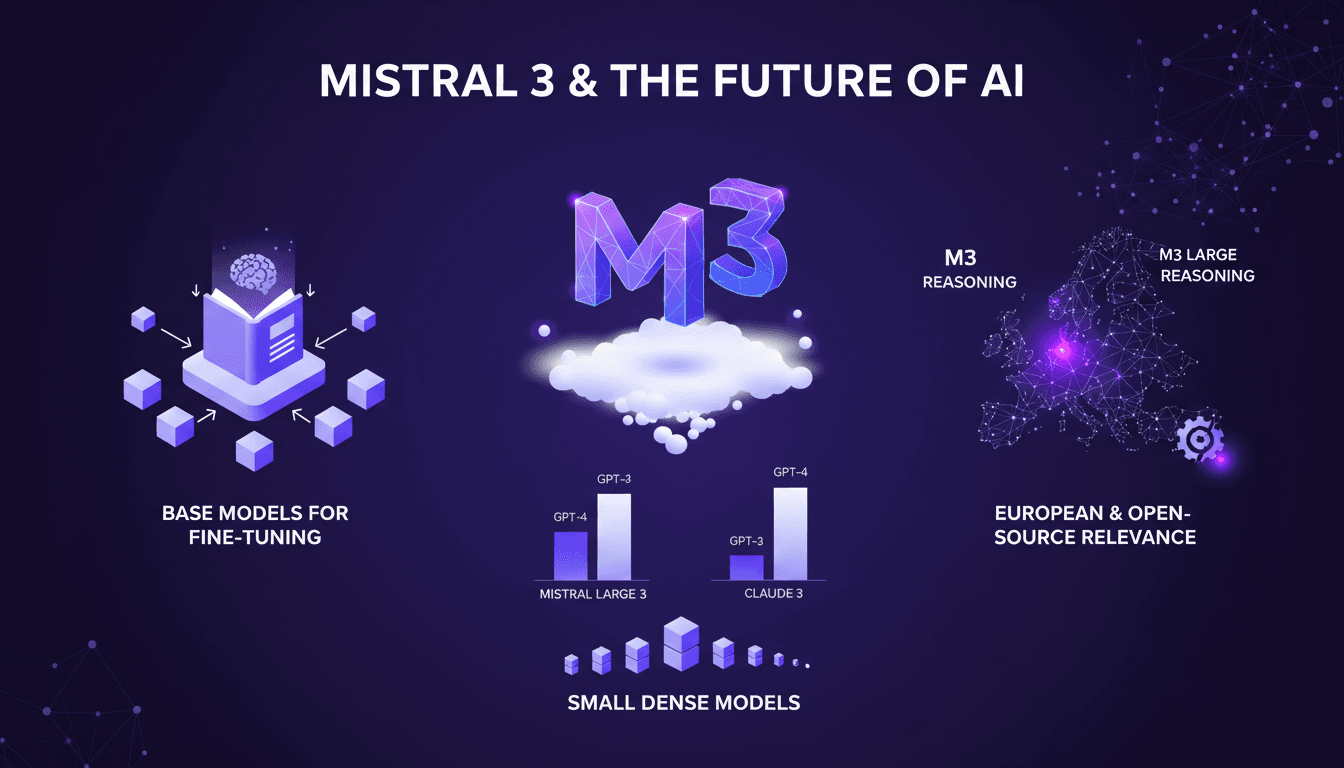

Mistral 3 : Percée Européenne ou Trop Tard?

Depuis que j'ai mis la main sur Mistral 3, je suis plongé dans les entrailles de ce modèle. Ce n'est pas juste un modèle AI de plus; c'est le pari audacieux de l'Europe dans la course à l'IA. Avec ses 675 milliards de paramètres, Mistral 3 se positionne en rival sérieux, mais est-ce suffisant face à des géants comme Deep Seek? Je connecte les points entre les performances, les stratégies de fine-tuning, et les implications pour l'innovation européenne. Allez, on va décortiquer tout ça ensemble.

Évolution des deepfakes : Ce que vous devez savoir

J'ai rencontré les deepfakes pour la première fois lorsqu'un client m'a apporté une vidéo qui semblait étrange. C'était un électrochoc, révélant à quel point la technologie AI avait progressé—et tout ce qu'elle pourrait encore accomplir. Avec l'évolution rapide de l'intelligence artificielle, les deepfakes deviennent de plus en plus sophistiqués et accessibles. Ils offrent des possibilités créatives, mais posent aussi des risques de sécurité majeurs. Dans cet article, je vous emmène à travers les avancées technologiques, les défis de la détection et ce que nous devons savoir pour rester en avance sur les menaces potentielles. On parle d'impacts sur les secteurs de la finance et des médias, et des implications éthiques et légales. Je partage des stratégies pour contrer ces menaces, en m'appuyant sur cinq ans d'expérience à entraîner des systèmes spécifiques pour détecter les deepfakes. Si vous êtes constructeur comme moi, vous savez que rester en tête est essentiel, mais il faut aussi être conscient des dangers que présente cette technologie.