Mistral 3 : Percée Européenne ou Trop Tard?

Depuis que j'ai mis la main sur Mistral 3, je suis plongé dans les entrailles de ce modèle. Ce n'est pas juste un modèle AI de plus; c'est le pari audacieux de l'Europe dans la course à l'IA. Avec ses 675 milliards de paramètres, Mistral 3 se positionne en rival sérieux, mais est-ce suffisant face à des géants comme Deep Seek? Je connecte les points entre les performances, les stratégies de fine-tuning, et les implications pour l'innovation européenne. Allez, on va décortiquer tout ça ensemble.

Dès que j'ai mis la main sur Mistral 3, j'ai plongé dans les détails pour comprendre ce qui le fait vraiment tourner. Ce modèle n'est pas juste une nouvelle itération; c'est la réponse audacieuse de l'Europe dans la compétition mondiale de l'IA. Avec ses 675 milliards de paramètres, il joue dans la cour des grands, mais est-ce suffisant face à des titans comme Deep Seek? En tant que praticien, je me suis plongé dans ses performances (et franchement, avec autant de paramètres, on a de quoi faire) tout en comparant ses résultats à ceux d'autres modèles. Mais ce qui m'intéresse vraiment, c'est la stratégie de Mistral : libérer des modèles de base pour le fine-tuning. Est-ce que cela repositionne l'Europe dans l'espace open-source? On va explorer ça, et bien sûr, regarder de près comment ce modèle dense plus petit peut changer la donne. En gros, on va voir si Mistral 3 est la percée qu'on espérait ou juste un pas de plus dans une course déjà bien lancée.

Comprendre Mistral 3 : Les rouages internes

Quand j'ai découvert le lancement de Mistral 3, j'ai tout de suite su qu'on était face à un tournant. Avec ses 675 milliards de paramètres, ce modèle repousse les limites. Ce qui est fascinant, c'est l'utilisation du modèle Mixture of Experts qui active 41 milliards de paramètres par tâche. Ça, c'est de l'optimisation ! On parle ici d'une performance ciblée, ce qui réduit les coûts de calcul tout en maintenant l'efficacité.

Un autre point fort de Mistral 3, c'est sa licence Apache 2, qui ouvre la porte à la collaboration open-source. En tant que développeur, j'apprécie cette flexibilité pour les ajustements et les expérimentations. Contrairement aux modèles monolithiques, Mistral mise sur la sortie de modèles de base pour le fine-tuning, ce qui permet une adaptabilité et une efficacité accrues. Mais attention, chaque approche a ses limites. Ici, l'enjeu est de ne pas perdre de vue l'équilibre entre personnalisation et performance globale.

Mistral face aux géants : une analyse comparative

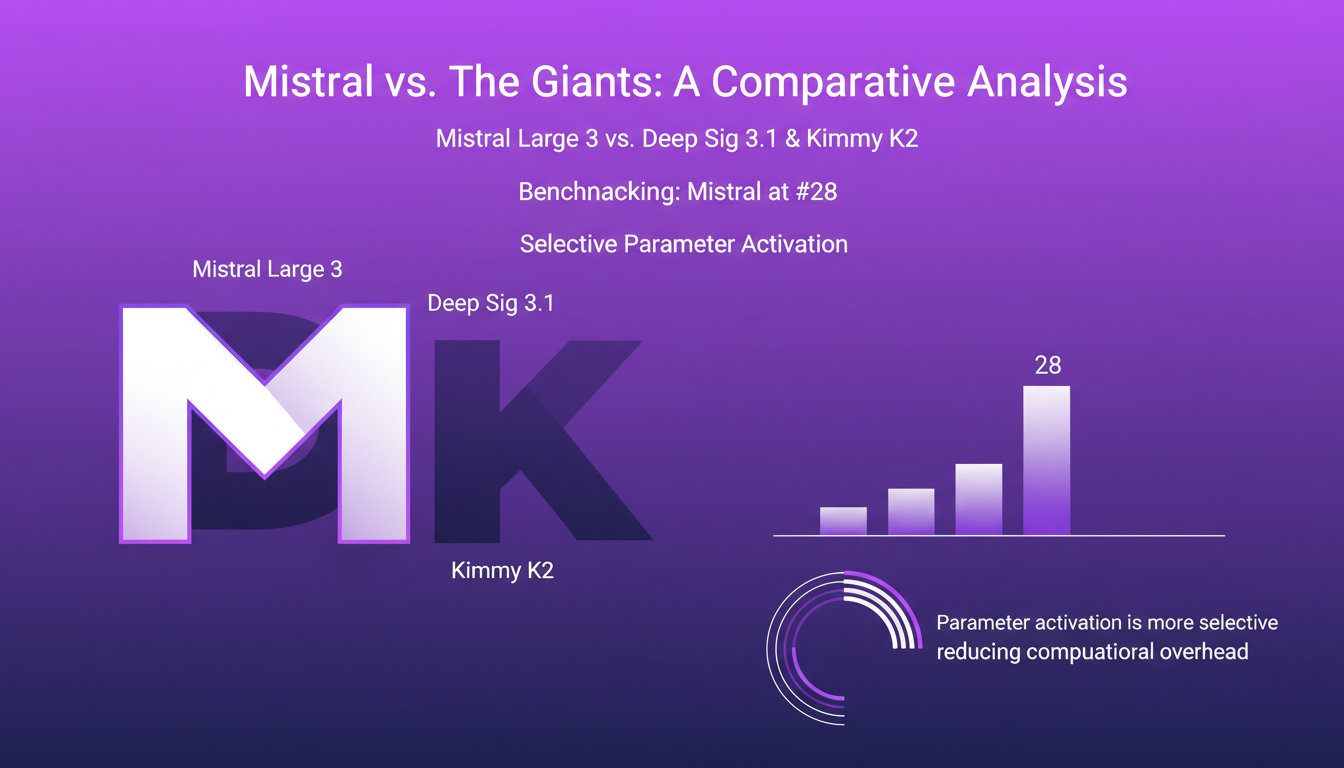

En comparant Mistral Large 3 à Deep Sig 3.1 et Kimmy K2, on se rend compte que Mistral se positionne à la 28ème place des benchmarks. C'est pas mal, mais il y a encore de la marge pour progresser. Ce qui distingue Mistral, c'est sa capacité à activer les paramètres de manière plus sélective, réduisant ainsi la surcharge de calcul.

| Modèle | Performance | Efficacité |

|---|---|---|

| Mistral Large 3 | 28ème position | Paramètres activés : 41 milliards |

| Deep Sig 3.1 | 25ème position | Paramètres activés : N/A |

| Kimmy K2 | 27ème position | Paramètres activés : N/A |

Les implications réelles pour les développeurs résident dans le choix du bon modèle en fonction des besoins spécifiques. Les compromis, comme gérer la complexité par rapport aux gains de performance, sont incontournables. Parfois, il vaut mieux opter pour une solution plus simple, mais plus rapide à déployer.

Des modèles plus petits, un impact plus grand : la stratégie de Mistral

Mistral ne se contente pas de gros modèles. Ils ont aussi introduit des modèles plus petits et denses, comme le Mini Style 3, pour répondre à une demande croissante d'efficacité. Ces modèles plus compacts sont parfaits pour des applications AI spécifiques, sans sacrifier la performance. Mais attention, il faut équilibrer la taille du modèle et sa capacité.

- Coût abordable

- Performance ajustée

- Adaptabilité aux tâches spécifiques

Ces modèles répondent à une demande de solutions plus efficaces, mais il ne faut pas négliger l'importance de la capacité et des fonctionnalités offertes par des modèles plus volumineux.

Le rôle de Mistral dans l'AI européenne et open-source

Avec Mistral, l'IA européenne a un leader qui prône l'innovation et l'adaptabilité. Leur approche open-source, sous Apache 2 License, encourage le développement communautaire. Cela dit, la concurrence avec les géants américains reste un défi, surtout pour capter des parts de marché.

Pour moi, l'open-source est un atout majeur, car il permet d'améliorer les modèles grâce à la collaboration. Mais il ne faut pas sous-estimer les défis que pose cette approche, notamment la nécessité de se démarquer face à des acteurs mieux financés comme OpenAI ou Google.

En perspective : Attentes pour Mistral 3

On attend avec impatience le modèle de raisonnement Mistral 3, qui pourrait bien redéfinir les standards AI en Europe. Les futures mises à jour pourraient corriger certaines limitations actuelles et améliorer les performances.

Pour rester compétitif, Mistral doit balancer innovation et application pratique. À mes yeux, l'avenir réside dans leur capacité à adapter les modèles aux besoins du marché tout en maintenant une stratégie d'innovation continue.

- Améliorations attendues

- Compétition avec les standards actuels

- Innovation vs application pratique

Mistral 3, c'est un vrai pas en avant pour l'IA européenne. Voilà ce que j'ai retenu :

- D'abord, avec ses 675 milliards de paramètres, le modèle Mistral Large 3 est une bête. Mais attention, seulement 41 milliards de ces paramètres sont actifs, donc ne vous laissez pas tromper par les gros chiffres.

- Ensuite, la stratégie de Mistral de publier des modèles de base pour les ajustements personnels est audacieuse. Ça permet de vraiment adapter l'IA à vos besoins spécifiques, mais ça demande aussi un bon niveau de compétence pour en tirer le meilleur.

- Enfin, Mistral cherche à s'imposer dans le paysage technologique européen. C'est prometteur, mais il faut qu'ils continuent d'innover et de se positionner stratégiquement pour vraiment rivaliser avec les géants.

En regardant vers l'avenir, je dirais que Mistral 3 pourrait bien être un game changer en Europe, mais il faut garder un œil sur les développements futurs. Si vous travaillez dans l'IA, suivez l'évolution de Mistral. Ça pourrait être un modèle à considérer pour votre prochain projet. Pour une compréhension plus profonde, je vous conseille de jeter un œil à la vidéo complète, c'est une mine d'informations !

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Stratégies IA Gagnantes : Leçons de Terrain

J'ai été dans les tranchées du développement IA, et croyez-moi, ce n'est pas seulement une question de technologie de pointe. C'est une question de vision, de stratégie et de navigation à travers un labyrinthe de régulations. Parlons franchement des vrais facteurs qui font ou défont les projets IA. De l'AI Act de l'UE aux obstacles culturels et réglementaires, je partage des insights tirés de mon parcours et comment la jeune génération de leaders redessine le paysage technologique. Les clés du succès résident dans une vision claire et une stratégie solide, sans oublier l'impact de l'open source contre le modèle fermé. Mais attention, aller de la preuve de concept à la production est truffé de pièges. Découvrons ensemble ce qui fonctionne réellement.

Modèles StepFun AI : Efficacité et Impact Futur

J'ai plongé dans l'écosystème de StepFun AI, intrigué par ses capacités de génération de vidéo à partir de texte. En explorant ses modèles et ses métriques de performance, j'ai découvert un acteur ambitieux venu de Chine. Avec 30 milliards de paramètres et la capacité de générer jusqu'à 200 images par seconde, StepFun AI promet de secouer le paysage de l'IA. Mais attention, le modèle Step video t2v nécessite 80 Go de mémoire GPU. Comparé à d'autres modèles, il y a des compromis à considérer, mais son potentiel est indéniable. Découvrons ensemble ce qui fait la force de StepFun AI et comment il pourrait redéfinir l'industrie.

Gemini 2.5 Pro : Performances et Comparaisons

J'ai plongé dans le Gemini 2.5 Pro avec des attentes élevées, et il n'a pas déçu. De l'exactitude en codage à l'ancrage de recherche, ce modèle repousse les limites. Mais il y a bien sûr des compromis à envisager. Avec un score de 1443, le plus élevé dans l'arène des LM, et une précision quasi parfaite dans les tâches de reconnaissance de caractères, Gemini 2.5 Pro impressionne. Cependant, l'utilisation excessive des outils et la tendance à sur-analyser peuvent parfois ralentir le processus. Je partage ici mon expérience pratique avec ce modèle, mettant en lumière ses forces et ses pièges potentiels. Préparez-vous à découvrir comment Gemini 2.5 Pro se compare et où il pourrait vous surprendre.

Grok 4 : Tarification et Controverses Dévoilées

J'ai plongé dans le monde des modèles IA depuis des années, mais l'arrivée de Grok 4 a été un véritable électrochoc. D'abord, j'ai exploré son lancement et sa performance, puis je me suis attaqué à sa stratégie de tarification. Ne pas examiner les polémiques aurait été une erreur. Grok 4 promet d'être un acteur majeur dans l'IA, mais attention, le prix est salé et les controverses ne manquent pas. Je vous dévoile mes découvertes, des performances de référence à l'empoisonnement de prompts, sans oublier la super intelligence artificielle. Vraiment, c'est un mélange de promesses et de défis.

Llama 4 : Déploiement et Défis Open Source

Je me suis plongé tête baissée dans le monde de l'IA avec Llama 4, décidé à exploiter sa puissance tout en naviguant dans les eaux parfois troubles du code source ouvert. Alors, après quatre jours intensifs, qu'est-ce que j'ai appris ? D'abord, Llama 4 crée des vagues dans le développement de l'IA, mais sa classification suscite des débats houleux. Est-il véritablement open-source ou joue-t-on sur les mots ? J'ai connecté les points entre Llama 4 et le concept d'IA open-source, en explorant comment ces mondes s'entrelacent, se heurtent parfois. En tant que praticien, je vous emmène dans les tranchées de cette révolution technologique, où chaque ligne de code compte, et où chaque choix technique a ses conséquences. Il est temps de démystifier ce qui se cache derrière la terminologie : modèle ouvert versus open-source. Et attention, il y a des limites à ne pas franchir, et des erreurs à éviter. Allons-y !