Fonctionnalités cachées pour agents IA prêts

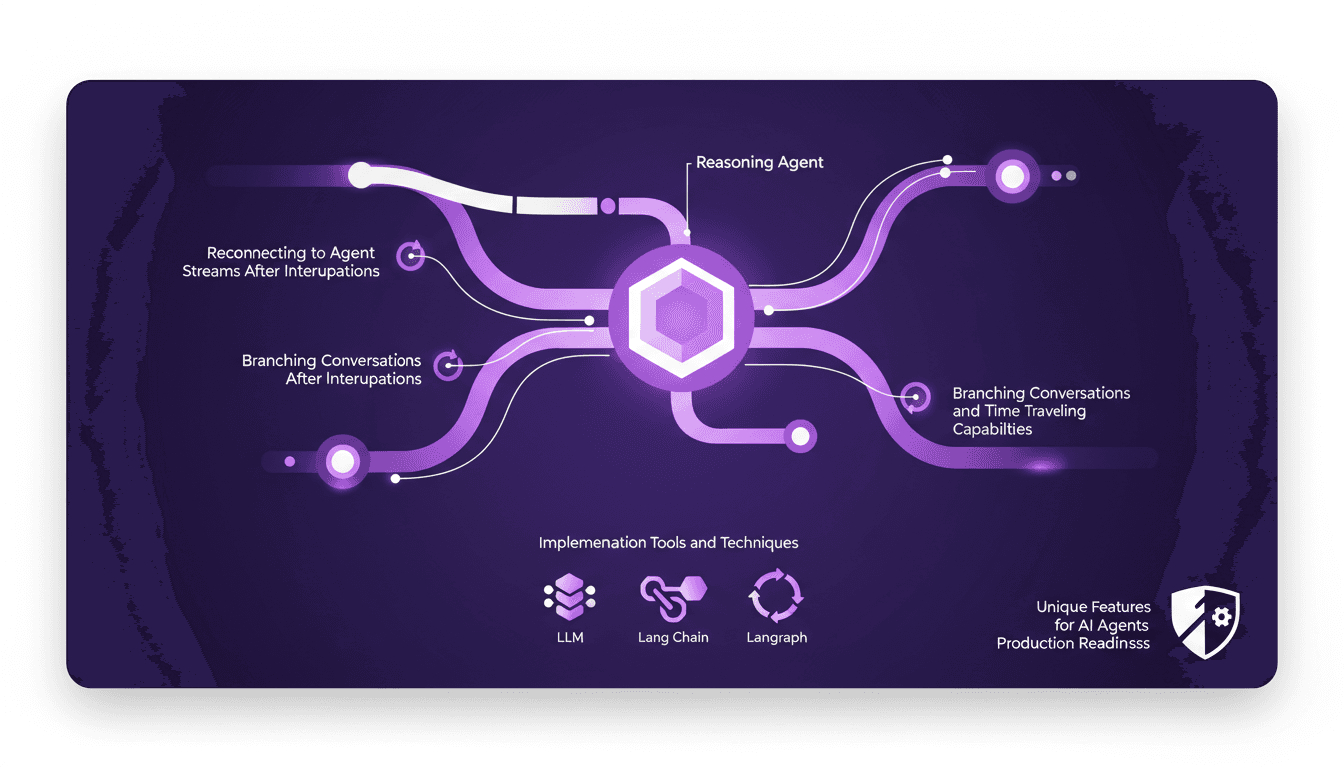

J'ai passé d'innombrables heures sur le terrain à peaufiner des agents IA qui ne se contentent pas d'être intelligents, mais qui sont vraiment prêts pour la production. Plongeons dans trois fonctionnalités cachées qui ont réellement changé la donne dans mon workflow. Vous savez, les agents IA évoluent rapidement, mais les rendre robustes pour des applications réelles nécessite de creuser plus profondément dans des fonctionnalités moins connues. Voici comment j'exploite ces capacités pour améliorer l'efficacité et la fiabilité. On parle ici de la manière dont j'utilise les agents de raisonnement et les processus de pensée en streaming, la reconnexion aux flux d'agents après des interruptions, et les conversations à embranchements avec des capacités de voyage dans le temps. Si vous cherchez à rendre vos agents IA prêts pour la production, ces fonctionnalités uniques sont indispensables.

Je me suis plongé dans le monde des agents IA pendant des heures interminables, et je peux vous dire que les rendre vraiment prêts pour la production, c'est un vrai défi. D'accord, la plupart des gens vont se contenter des fonctionnalités de base, mais si on veut vraiment faire la différence, il faut explorer des pistes moins évidentes. Alors, je vais vous parler de trois fonctionnalités cachées qui ont vraiment transformé mon approche. La première chose que je fais, c'est d'exploiter les agents de raisonnement couplés à des processus de pensée en streaming, ça change tout pour garder le fil en temps réel. Ensuite, il y a la reconnexion aux flux après une interruption. Croyez-moi, ça m'a sauvé plus d'une fois. Et enfin, les conversations à embranchements avec la capacité de revenir en arrière dans le temps, c'est comme avoir une machine à voyager dans le temps pour vos agents. Ces techniques, je les ai peaufinées avec des outils comme LLM et langchain, et elles ont rendu mes agents vraiment prêts pour le terrain.

Agents de Raisonnement et Processus de Pensée en Streaming

Quand j'ai commencé à travailler avec des agents de raisonnement, j'ai réalisé l'importance de streamer leur pensée. Au lieu de simplement fournir une réponse finale, il est crucial de montrer le processus de réflexion. Cela aide non seulement l'utilisateur à suivre le cheminement, mais aussi à intervenir si nécessaire. L'utilisation de ces agents permet de maintenir le contexte tout au long de l'interaction.

Mais attention, il y a un équilibre délicat entre la complexité et la performance. Trop de détails dans le processus de pensée peuvent surcharger le système et ralentir l'expérience utilisateur. J'ai été brûlé par ce piège plusieurs fois avant de trouver le bon compromis.

- Configurer les agents de raisonnement pour des décisions dynamiques.

- Maintenir le contexte avec des processus de pensée en streaming.

- Éviter les pièges courants liés à la complexité excessive.

Reconnexion aux Flux d'Agents Après des Interruptions

La gestion des interruptions est un défi constant. Avec l'utilisation de l'ID de thread et du Reconnect on Mount, j'ai pu assurer une continuité des conversations même après des coupures de page ou de connexion. Cela est crucial dans des scénarios réels où chaque seconde compte.

Il existe cependant des compromis entre la rapidité de reconnexion et l'intégrité des données. Dans mon expérience, il est parfois préférable de prioriser l'intégrité, même si cela signifie un léger retard dans la récupération des données.

- Utilisation de l'ID de thread pour stocker l'état de la conversation.

- Activation du reconnect on mount pour récupérer les conversations après une interruption.

- Stratégies pour minimiser les temps d'arrêt.

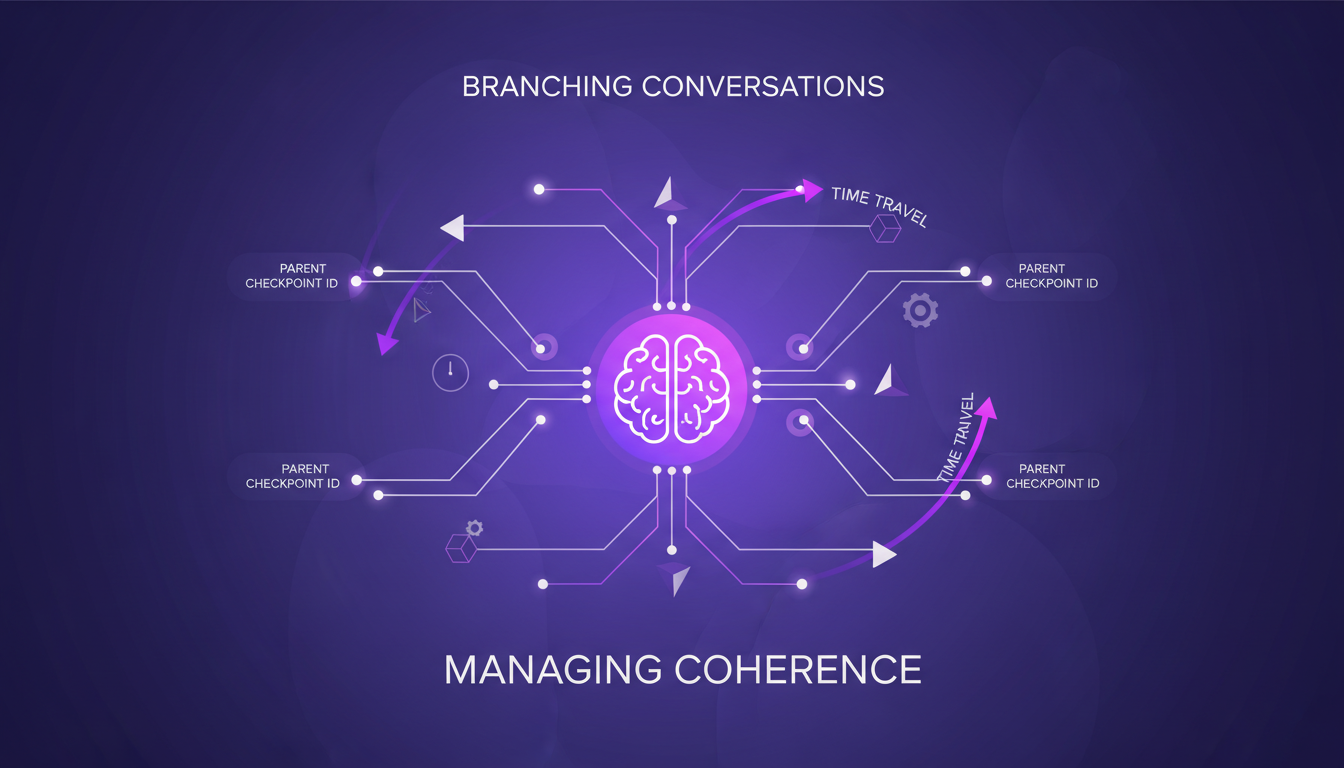

Conversations Ramifiées et Capacités de Voyage dans le Temps

Les conversations ramifiées sont un autre outil précieux. Avec les Parent Checkpoint IDs, je peux reprendre une conversation à partir de n'importe quel point dans le temps, ce qui est incroyablement utile pour modifier ou réorienter le fil de la discussion.

Cependant, dans des scénarios complexes, il est facile de perdre la cohérence si les branches ne sont pas gérées correctement. C'est pourquoi je m'assure toujours de bien structurer les points de contrôle pour éviter la confusion.

- Mise en œuvre de conversations ramifiées avec des Parent Checkpoint IDs.

- Usage efficace des capacités de voyage dans le temps.

- Gestion des branches pour maintenir la cohérence.

Outils et Techniques de Mise en Œuvre : LLM, Lang Chain, Langraph

Pour intégrer ces fonctionnalités, j'ai opté pour des outils comme LLM, Lang Chain et Langraph. Leur intégration dans mon flux de travail s'est avérée être un véritable atout. En passant par chaque étape, j'ai appris à maximiser leur potentiel tout en gardant un œil sur les coûts et l'efficacité.

J'ai souvent dû ajuster mes approches pour éviter les pièges de performance et de coût. Par exemple, l'utilisation excessive de certains outils peut mener à des surcharges inutiles.

- Pourquoi choisir LLM, Lang Chain et Langraph.

- Étapes d'intégration dans le flux de travail.

- Leçons apprises et considérations de coût et d'efficacité.

Fonctionnalités Uniques pour la Production d'Agents AI

Enfin, il y a des fonctionnalités moins connues de longchain qui se démarquent, comme la rendu des tokens de raisonnement ou la reconnexion aux flux. Ces outils répondent à des questions difficiles et équilibrent innovation et application pratique.

Ces fonctionnalités ont un impact direct sur la performance globale des agents, en rendant les applications plus robustes et prêtes pour la production.

- Trois fonctionnalités longchain méconnues mais cruciales.

- Deux questions difficiles que ces fonctionnalités aident à résoudre.

- Impact sur la performance et préparation à la production.

En appliquant ces fonctionnalités cachées, j'ai littéralement transformé la manière dont je construis des agents d'IA prêts pour la production. D'abord, en mettant l'accent sur le raisonnement et le processus de pensée en flux continu, j'ai pu améliorer l'efficacité et la fiabilité. Ensuite, la reconnexion aux flux d'agents après des interruptions — un vrai game changer, mais attention aux complications de synchronisation. Enfin, grâce aux capacités de bifurcation des conversations et de voyage temporel, j'ai ouvert de nouvelles voies d'interaction. Mais ne vous laissez pas emporter par l'enthousiasme : il y a des limites, notamment en termes de ressources et de complexité. J'encourage fortement à commencer à intégrer ces techniques dans vos projets. Partagez vos expériences, et ensemble, repoussons les limites de ce qui est possible avec les agents d'IA. Pour plus de détails, regardez la vidéo complète ici : lien YouTube.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

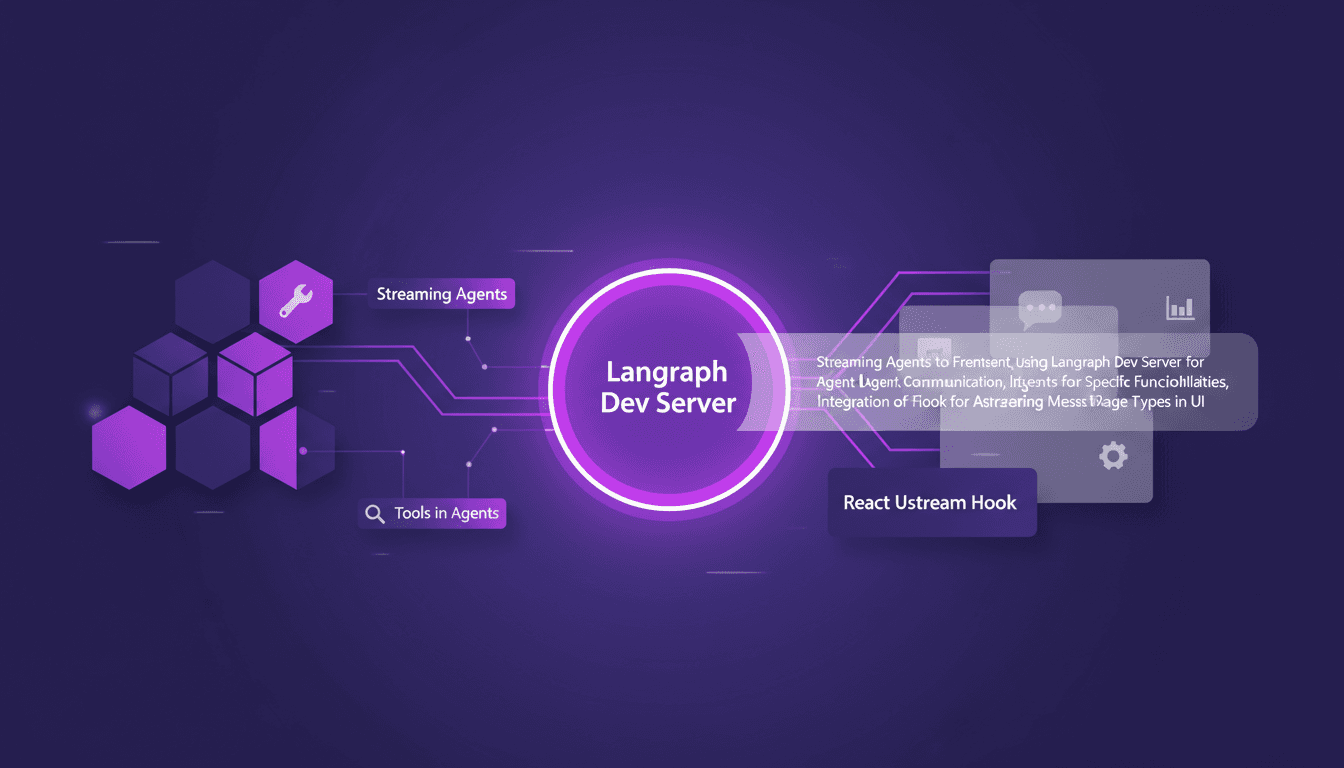

LangChain et React: Messages d'agents en streaming

Je me souviens de la première fois où j'ai tenté de streamer des messages d'agents dans une application React. C'était un vrai bazar... jusqu'à ce que je découvre LangChain et Langraph. Je vais vous expliquer comment j'ai configuré tout ça pour créer une interaction fluide entre le frontend et les agents IA. Dans ce tutoriel, je vous montre comment connecter LangChain et React en utilisant Langraph Dev Server. On plongera dans le streaming de messages d'agents, avec des outils comme la météo et la recherche web, et on verra comment les rendre efficacement dans l'interface utilisateur. Vous verrez comment j'intègre ces messages grâce au hook React Ustream, et comment je gère différents types de messages dans l'UI. Prêt à transformer vos interactions IA ? Allons-y.

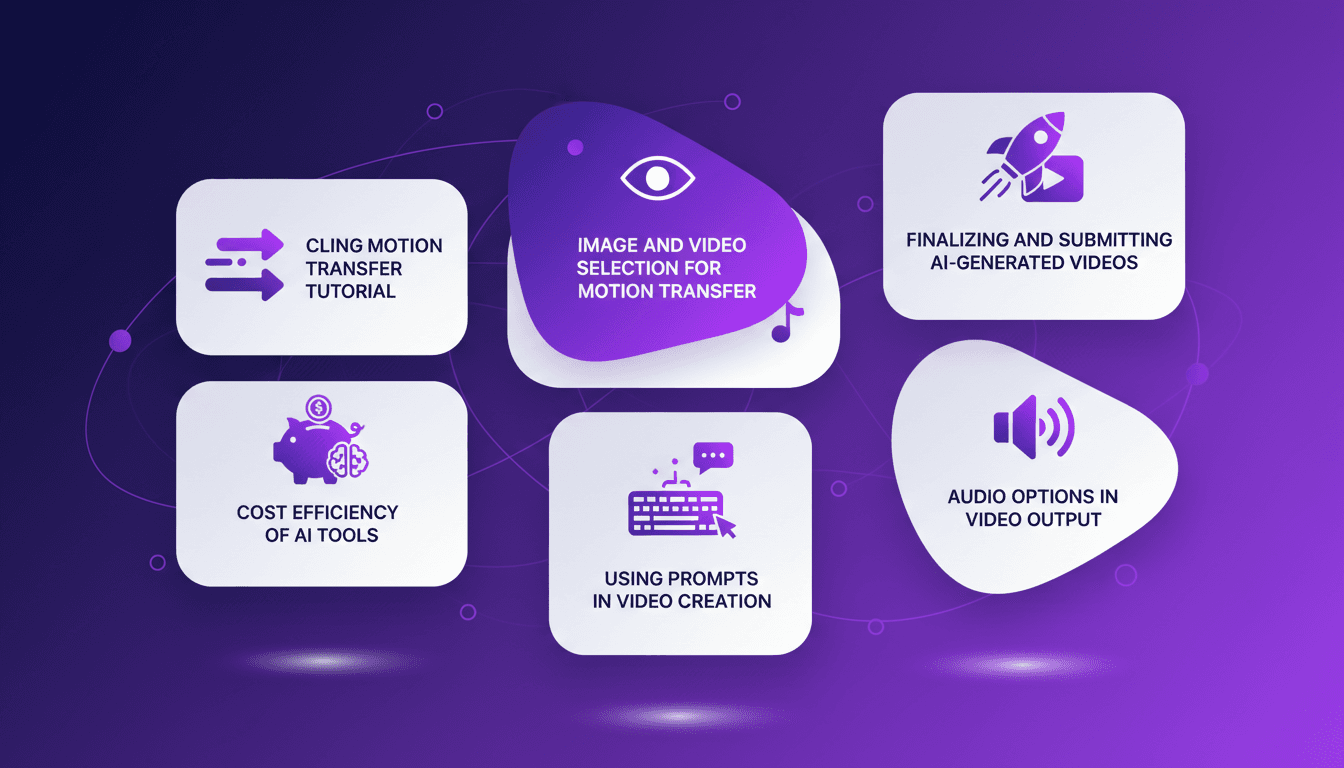

Tutoriel Cling Motion Transfer: Maîtrisez-le

Je me souviens encore de la première fois où j'ai essayé le Cling Motion Transfer. C'était une vraie révolution. Pour moins d'un dollar, j'ai transformé une simple vidéo en un contenu viral. Dans cet article, je vais vous montrer comment je l'ai fait, étape par étape. Cling Motion Transfer est un outil AI abordable qui se distingue dans le monde de la création vidéo, surtout pour les plateformes comme TikTok. Mais attention, comme tout outil, il a ses caprices et ses limites. Je vais vous guider à travers le choix des images et vidéos, l'utilisation des prompts, et comment finaliser et soumettre votre contenu AI. C'est parti.

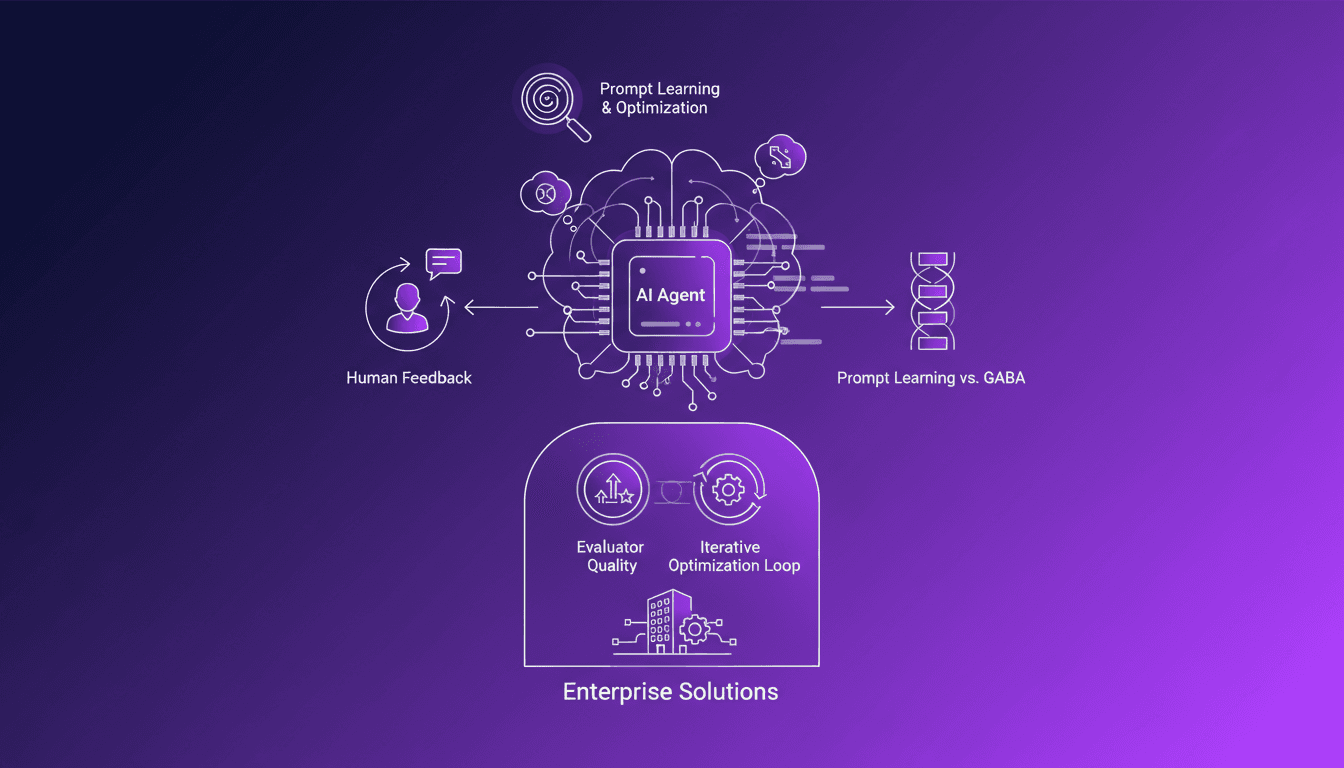

Optimiser les Boucles d'Apprentissage de Prompts

J'ai passé des mois à perfectionner comment mes agents IA apprennent. Ce n'est pas juste une question de balancer des prompts et de croiser les doigts. Non, il s'agit de construire une boucle d'apprentissage robuste qui évolue à chaque itération. Les défis dans le développement d'agents IA sont nombreux, et optimiser ces prompts est là où le vrai travail commence. Dans cette vidéo, je partage les techniques et solutions que j'ai découvertes, du rôle crucial du feedback humain à l'importance de la qualité de l'évaluateur. C'est un voyage dans le monde complexe de l'optimisation des prompts, et je vous montre comment j'ai craqué le code.

Construire un Agent AI: Défis et Solutions

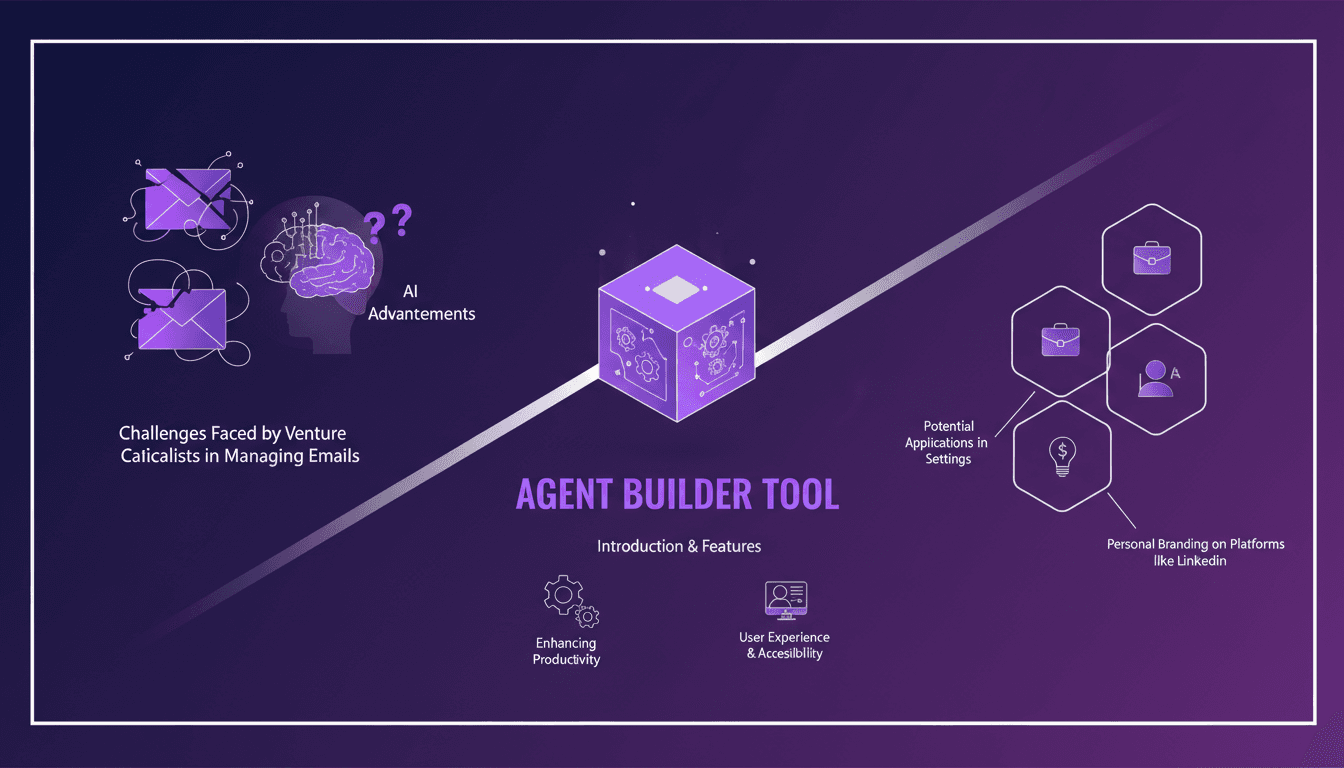

Plongé jusqu'au cou dans le monde du capital-risque, je passe mes journées à jongler avec des tonnes d'emails. C'est un cauchemar, vraiment. Heureusement, j'ai récemment découvert le LangSmith Agent Builder, et ça a changé la donne. Imaginez un outil qui automatise et simplifie la gestion de vos tâches quotidiennes, vous libérant du temps pour ce qui compte vraiment. Mais attention, ne vous laissez pas entraîner par l'excitation, il y a des limites à connaître. Par exemple, si vous dépassez les 100K tokens, ça devient compliqué. Pourtant, dans le tumulte du travail quotidien, cet outil est une vraie bouffée d'air frais. Il optimise non seulement votre productivité, mais renforce aussi votre présence sur LinkedIn. Bref, un indispensable pour nous, professionnels du capital-risque.

Sommet du Code IA 2025 : Avancées et Nouveautés

Je suis entré au Sommet du Code IA 2025 à New York, et l'énergie était palpable. Ce n'était pas juste un autre événement tech; c'était un rassemblement des esprits qui façonnent l'avenir du codage IA. Avec l'expansion du rôle de l'IA dans les entreprises, comprendre les derniers outils et collaborations est crucial. DeepMind se démarque avec ses nouveaux lancements comme Gemini 3 et Nano Banana Pro. Ces innovations ne sont pas seulement des gadgets; elles transforment la façon dont nous abordons le développement logiciel. J'ai expérimenté ces outils, et je peux vous dire qu'ils redéfinissent la manière dont nous orchestrons nos projets. C'est une période passionnante pour l'IA, et ce sommet est le point de convergence de ces bouleversements.