Modèle Seed AI: Révolutionne la Vidéo

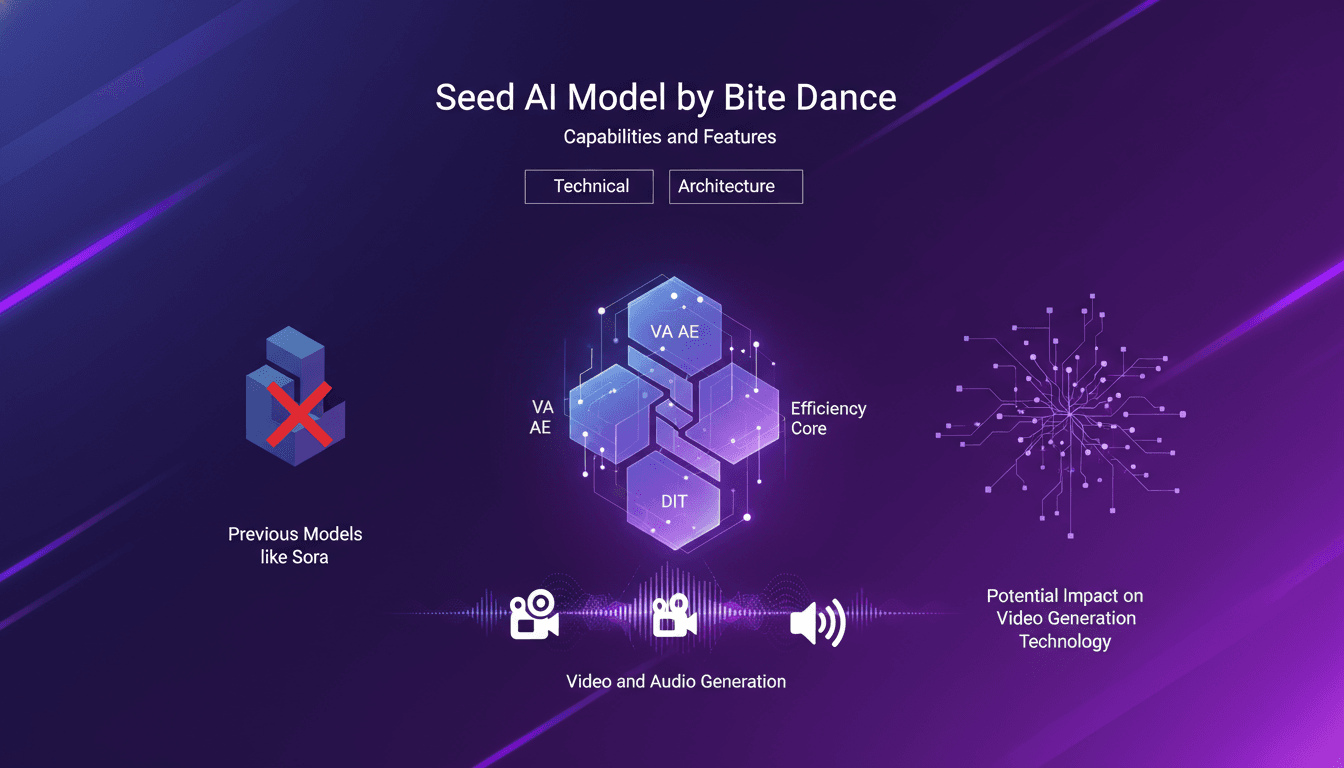

Je me suis plongé dans le nouveau modèle Seed AI de ByteDance, et franchement, c'est plus qu'un simple modèle d'IA — c'est un vrai game changer pour la génération vidéo. Avec ses 7 milliards de paramètres, il pousse les limites de la création vidéo et audio. Mais avant de sauter de joie, voyons ce qui rend ce modèle vraiment spécial. D'abord, il utilise une architecture VA AE et DIT, ce qui optimise l'efficacité et réduit les ressources nécessaires. Ensuite, comparons-le à Sora, son prédécesseur. La différence? Seed est conçu pour produire des vidéos HD 720p avec une vitesse et une précision impressionnantes. Mais attention, ce n'est pas une solution miracle pour tout le monde. Découvrons ensemble où Seed excelle vraiment et comment il pourrait bouleverser la technologie vidéo.

J'ai plongé tête la première dans le nouveau modèle Seed AI de ByteDance, et croyez-moi, ce n'est pas juste une énième IA — c'est un véritable tournant pour la génération vidéo. Avec ses 7 milliards de paramètres, Seed est conçu pour repousser les frontières de la création vidéo et audio. Mais avant de trop s'emballer, voyons ce qui rend ce modèle vraiment unique. Premièrement, son architecture VA AE et DIT optimise l'efficacité et réduit les ressources de calcul nécessaires, ce qui est crucial quand on parle de 665 000 heures de GPU H100. Et comparons-le à Sora, son prédécesseur. La différence est frappante : Seed est conçu pour produire des vidéos HD 720p avec une rapidité et une précision impressionnantes. Mais attention, ce n'est pas une solution miracle pour tout le monde. Vous devez comprendre où Seed excelle vraiment et comment il pourrait bouleverser la technologie vidéo. Suivez-moi, on va explorer tout ça ensemble.

Introduction du Modèle Seed AI par ByteDance

ByteDance, la maison mère de TikTok, a récemment lancé un modèle d'intelligence artificielle révolutionnaire nommé Seed. Ce modèle se distingue par ses capacités avancées de génération vidéo et audio. Avec ses 7 milliards de paramètres, le modèle Seed promet des performances impressionnantes dans le domaine de la création multimédia. Ce n'est pas juste un autre modèle sur le marché ; c'est une puissance de calcul qui a été conçue pour être à la fois efficace et de haute qualité, un équilibre rare et précieux dans le domaine technologique.

Le modèle Seed se concentre sur l'efficacité et la production de vidéos de haute qualité, avec la possibilité de s'adapter à divers cas d'utilisation. Lors de mes premiers essais, j'ai été frappé par sa capacité à générer des vidéos à partir d'images, à créer des transitions fluides entre les scènes, et à associer des vidéos avec un audio d'entrée. Avec 665 000 heures de GPU H100 utilisées pour sa construction, Seed est une vitrine technologique qui mérite toute notre attention, surtout si l'on considère ses applications potentielles dans le domaine créatif et au-delà.

Capacités et Fonctionnalités du Modèle Seed

Le modèle Seed est capable de produire des vidéos en haute définition 720p à 24 images par seconde, ce qui est idéal pour des plateformes comme TikTok. En termes de synthèse audio, le modèle ne se contente pas de générer des vidéos : il produit également des pistes sonores pertinentes qui s'accordent parfaitement avec le contenu visuel. J'ai testé ces fonctionnalités dans plusieurs scénarios, et je dois dire que la synchronisation audio-vidéo est impressionnante.

Les applications réelles sont vastes : des filtres TikTok aux vidéos promotionnelles, en passant par les simulations réalistes où le son et l'image doivent être en parfaite harmonie. Cela ouvre des portes non seulement pour les créateurs de contenu, mais aussi pour les industries nécessitant des simulations réalistes, comme l'automobile ou le gaming.

- Génération de vidéos HD 720p

- Synthèse audio avancée

- Applications variées dans les industries créatives

Architecture Technique : VA AE et DIT

Plongeons dans l'architecture technique de Seed. Le modèle utilise un autoencodeur variationnel VA AE et un transformateur de diffusion latent DIT. Ces technologies ne sont pas nouvelles, mais leur application dans Seed est novatrice. Le VA AE est essentiel pour compresser les données tout en préservant les caractéristiques importantes, tandis que le DIT facilite la génération de nouvelles données à partir de celles déjà acquises.

Les architectures basées sur les transformateurs de diffusion permettent d'améliorer la qualité de génération de contenu tout en maîtrisant la complexité. Cependant, attention : ces systèmes peuvent être gourmands en ressources, et leur déploiement doit être bien pensé pour éviter des coûts de calcul excessifs. C'est une leçon que j'ai apprise à mes dépens, en orchestrant des projets similaires où l'équilibre entre performance et coût est critique.

- Compression efficace avec VA AE

- Génération de données avancée avec DIT

- Équilibre entre complexité et performance

Efficacité et Ressources Informatiques

Le modèle Seed a nécessité 665 000 heures de GPU H100 pour son développement, ce qui est colossal. Mais que signifie ce chiffre pour nous, praticiens ? D'abord, cela souligne l'importance des ressources informatiques dans le développement de modèles de cette envergure. Ensuite, cela nous pousse à réfléchir à l'efficacité de notre infrastructure : comment pouvons-nous optimiser l'utilisation des GPU pour maximiser la qualité des résultats tout en minimisant les coûts ?

Dans mes projets, j'ai souvent opté pour des modèles plus petits pour des itérations rapides et des ajustements fréquents. Cependant, Seed offre une solution puissante là où la qualité prime sur la rapidité. Gardez en tête que le coût de l'échelle peut devenir prohibitif si l'on ne planifie pas correctement. C'est là que l'expérience et une bonne orchestration des ressources jouent un rôle crucial.

Applications et Comparaison avec Sora

En termes d'applications, Seed se distingue par sa capacité à générer du contenu de haute qualité, tant en vidéo qu'en audio. Comparé à des modèles précédents comme Sora, Seed offre des améliorations notables en termes de fluidité et de réalisme. Cependant, tout n'est pas parfait : il existe encore des limites, notamment dans la gestion de scènes complexes ou de transitions très rapides.

La question est donc : quand utiliser Seed ? Pour des projets où la qualité visuelle et sonore est critique, Seed est un choix judicieux. Mais pour des tâches nécessitant rapidité et flexibilité, d'autres modèles peuvent s'avérer plus adaptés. Cette évaluation dépendra toujours du contexte et des besoins spécifiques de votre projet.

- Améliorations par rapport à Sora

- Limites dans la gestion de scènes complexes

- Impact potentiel sur le futur de la technologie vidéo

Alors, qu'est-ce que je retiens de ce modèle Seed AI de Bite Dance ? D'abord, avec ses 7 milliards de paramètres, il bouleverse vraiment la génération vidéo et audio. C'est une avancée majeure (un vrai game changer), mais attention, son utilisation exige une compréhension fine de sa consommation de ressources — 665,000 heures GP H100, ce n'est pas rien ! Ensuite, produire des vidéos en 720p HD, c'est top, mais il faut s'assurer que ça s'intègre bien dans notre flux de travail sans tout exploser en termes de coûts ou de temps. Enfin, son architecture VA AE et DIT est efficace, mais elle demande une bonne maîtrise technique pour être exploitée à fond. À l'avenir, je pense qu'on va voir ce type de modèle s'imposer, mais il faudra rester vigilant sur les compromis à faire. Je t'invite à plonger dans la vidéo originale pour vraiment comprendre comment ce modèle fonctionne et comment il pourrait transformer tes projets vidéos. Regarde ici : https://www.youtube.com/watch?v=Gn2HlDfdCOA.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Modèles StepFun AI : Efficacité et Impact Futur

J'ai plongé dans l'écosystème de StepFun AI, intrigué par ses capacités de génération de vidéo à partir de texte. En explorant ses modèles et ses métriques de performance, j'ai découvert un acteur ambitieux venu de Chine. Avec 30 milliards de paramètres et la capacité de générer jusqu'à 200 images par seconde, StepFun AI promet de secouer le paysage de l'IA. Mais attention, le modèle Step video t2v nécessite 80 Go de mémoire GPU. Comparé à d'autres modèles, il y a des compromis à considérer, mais son potentiel est indéniable. Découvrons ensemble ce qui fait la force de StepFun AI et comment il pourrait redéfinir l'industrie.

Llama 4 : Déploiement et Défis Open Source

Je me suis plongé tête baissée dans le monde de l'IA avec Llama 4, décidé à exploiter sa puissance tout en naviguant dans les eaux parfois troubles du code source ouvert. Alors, après quatre jours intensifs, qu'est-ce que j'ai appris ? D'abord, Llama 4 crée des vagues dans le développement de l'IA, mais sa classification suscite des débats houleux. Est-il véritablement open-source ou joue-t-on sur les mots ? J'ai connecté les points entre Llama 4 et le concept d'IA open-source, en explorant comment ces mondes s'entrelacent, se heurtent parfois. En tant que praticien, je vous emmène dans les tranchées de cette révolution technologique, où chaque ligne de code compte, et où chaque choix technique a ses conséquences. Il est temps de démystifier ce qui se cache derrière la terminologie : modèle ouvert versus open-source. Et attention, il y a des limites à ne pas franchir, et des erreurs à éviter. Allons-y !

OpenAI et Sécurité Nucléaire : Déploiement et Impacts

Je me souviens de la première fois où j'ai lu sur la collaboration d'OpenAI avec le gouvernement américain. C'était un vrai bouleversement, mais avec des nuances complexes. Cette alliance entre OpenAI et les Laboratoires Nationaux change la donne dans le déploiement de l'IA, et elle n'est pas seulement une question de technologie. On parle ici de leadership, d'innovation et de l'équilibre délicat du pouvoir dans un monde compétitif. Avec des figures clés comme Elon Musk et Donald Trump impliquées, et des acteurs technologiques comme Nvidia et Azure en soutien, les enjeux autour de la sécurité nucléaire et de la cybersécurité prennent une toute autre dimension. Et puis, il y a cette compétition États-Unis-Chine qui pèse. Accrochez-vous, car je vais vous expliquer comment tout cela se déroule.

Supercalculateur AI Nvidia : Puissance et applications

J'ai branché le nouveau supercalculateur AI personnel de Nvidia, et laissez-moi vous dire, c'est comme passer de la bicyclette au jet. On parle ici d'un appareil qui surpasse votre ordinateur portable moyen par mille fois. Ce bijou est capable de gérer des modèles de 200 milliards de paramètres grâce à la puce gb10 Grace Blackwell. Mais attention, cette puissance colossale vient avec ses propres défis. C'est un véritable changeur de jeu pour les utilisateurs individuels, mais il faut savoir où poser les limites pour ne pas s'y brûler. Plongeons dans ce qui rend cet outil exceptionnel et où vous pourriez rencontrer quelques obstacles.

Nvidia DIGITS : Supercalculateur IA Personnel

J'ai été plongé dans des projets d'IA pendant des années, mais quand Nvidia a annoncé leur supercalculateur IA personnel, j'ai su que c'était un vrai tournant. Alimenté par la puce gb10 Grace Blackwell, ce monstre promet de gérer des modèles allant jusqu'à 200 milliards de paramètres. Ce n'est pas juste du marketing, c'est une transformation de notre façon de construire et déployer des solutions IA. Avec une puissance mille fois supérieure à celle d'un ordinateur portable moyen, ce n'est pas pour les amateurs. Attention aux pièges : avant de plonger, il faut comprendre les spécifications et le coût. Je vous explique ce qui change concrètement dans nos workflows et ce qu'il faut savoir pour ne pas se planter.