API Gemini Interactions : Guide Pratique

Je me suis plongé tête baissée dans l'API Gemini Interactions, et laissez-moi vous dire, c'est un vrai game changer si vous savez comment l'utiliser. D'abord, j'ai relié ses fonctionnalités à mon flux de travail quotidien, puis j'ai commencé à en voir le véritable potentiel. Mais attention, ce n'est pas tout rose; il y a quelques bizarreries à naviguer. En comprenant sa multimodalité, en gérant efficacement les tokens et en tirant parti de la persistance de l'état côté serveur, j'ai pu intégrer des interactions IA avancées dans mes applications. Mais franchement, je me suis fait avoir plus d'une fois avant de maîtriser ses subtilités. Alors, prêt à explorer ce que l'API Gemini peut vraiment faire pour vous?

Je me suis plongé tête baissée dans l'API Gemini Interactions, et laissez-moi vous dire, c'est un vrai game changer si vous savez comment l'utiliser. Dès le début, j'ai connecté les points entre ses fonctionnalités et mon flux de travail quotidien. Et là, j'ai commencé à voir le potentiel réel. Mais attention, ce n'est pas tout rose; il y a des bizarreries à naviguer. Par exemple, comprendre sa multimodalité et gérer efficacement les tokens est crucial pour éviter les pièges. La persistance de l'état côté serveur, c'est un autre casse-tête que j'ai dû résoudre—je me suis fait avoir au moins trois fois avant de vraiment comprendre comment l'orchestrer. Mais une fois que j'ai pris le coup, l'impact sur mon application a été direct. En utilisant les outils comme la recherche Google, l'exécution de code et l'outil de contexte URL, j'ai pu construire des interactions IA avancées qui ont transformé mon produit. Alors, prêt à voir ce que l'API Gemini peut vraiment faire pour vous d'ici 2025?

Commencer avec l'API Gemini Interactions

Plonger dans l'API Gemini Interactions de Google, c'est comme ouvrir une boîte à outils sophistiquée pour les développeurs. Je me suis d'abord connectée en utilisant la version 1.55.0 du SDK Google Gen AI, indispensable pour tirer le meilleur parti de cette API. Dès le début, trois outils principaux se sont démarqués : la recherche Google, l'exécution de code, et le contexte URL. Ces outils ne sont pas seulement des gadgets, mais des leviers pour des interactions plus intelligentes.

Mes premières impressions ont été mitigées. D'un côté, l'accès à des agents comme Gemini Research est un atout majeur, mais la navigation dans la documentation m'a fait perdre un temps précieux. L'efficacité réside dans la capacité à jongler entre les différentes sections du guide sans perdre le fil. Attention, une mauvaise lecture peut vous faire perdre des heures.

- Google Gen AI SDK version 1.55.0 est nécessaire.

- Trois outils principaux : recherche Google, exécution de code, contexte URL.

- Documentation dense mais essentielle.

Fonctionnalités et Multimodalité : Exploiter le Potentiel

La multimodalité dans l'API, c'est un peu comme avoir un couteau suisse. Vous pouvez traiter des images, des audios, voire des fichiers PDF. J'ai intégré ces fonctionnalités dans mes systèmes existants, mais cela n'a pas été sans défis. La gestion des tokens est cruciale pour équilibrer les tokens de sortie et de raisonnement. J'ai découvert que l'API commence un cache implicite au-delà de 1000 tokens, ce qui peut être un avantage ou un inconvénient selon vos besoins.

Intégrer ces fonctionnalités a nécessité de jongler avec la complexité et la fonctionnalité. Plus de fonctionnalités, c'est souvent plus de complexité, et je me suis parfois retrouvée à repenser mon approche pour éviter de transformer un gain de temps en gouffre.

- Support multimodal : images, audio, PDF.

- Cache implicite au-delà de 1000 tokens.

- Équilibre entre complexité et fonctionnalité.

Persistence de l'État côté Serveur et Exécution en Arrière-plan

L'une des fonctionnalités qui m'a le plus impressionnée est la persistence de l'état côté serveur. Cela permet des interactions fluides, surtout dans des scénarios de chat multi-turn. Vous pouvez enfin arrêter de tout renvoyer à chaque requête. Pour l'exécution en arrière-plan, c'est une révolution. Imaginez pouvoir déléguer des tâches longues à l'agent sans garder la connexion ouverte. J'ai utilisé cela pour des traitements audio en arrière-plan, et honnêtement, c'est un gain de temps énorme.

Attention toutefois aux pièges : mal orchestrer ces exécutions peut entraîner des conflits d'état ou des pertes de données. Je me suis fait avoir plusieurs fois avant de comprendre les subtilités de l'orchestration des agents.

- Persistence de mémoire pour interactions multi-turn.

- Exécution en arrière-plan pour tâches longues.

- Attention aux conflits d'état.

Sorties Structurées et Appel de Fonction : Une Exploration Approfondie

Les sorties structurées, c'est le graal pour la gestion des données. Avec l'API, je peux manipuler les réponses comme des objets JSON, ce qui simplifie énormément le traitement. J'ai implémenté des appels de fonction directement dans l'API, et voir ça en action dans des scénarios réels est bluffant. Cependant, il y a des limites. Parfois, l'API ne répond pas comme prévu, et il faut bricoler pour contourner ces obstacles.

Un conseil : ne surchargez pas les appels de fonction. Trop d'appels peuvent ralentir votre système et vous faire perdre l'avantage que vous cherchiez à obtenir.

- Sorties sous forme de JSON pour une manipulation facile.

- Appels de fonction intégrés.

- Ne surchargez pas les appels.

Outils, Fonctionnalités, et Perspectives d'Avenir

L'API propose une panoplie d'outils, et je dois avouer que certains sont encore en développement. Mais d'ici 2025, des améliorations sont attendues, notamment avec l'intégration des modèles Gemini 3. Mon expérience pratique souligne quelques critiques : certains outils sont encore trop rudimentaires, et la documentation gagnerait à être plus concise.

En tant que développeur, il est crucial de garder un œil critique sur ce qui fonctionne et ce qui est simplement du bruit. J'ai hâte de voir comment cette API évoluera, mais pour l'instant, il faut jongler entre attentes et capacités actuelles.

- Attentes d'améliorations d'ici 2025.

- Outils encore en développement.

- Critiques basées sur l'expérience pratique.

Pour en savoir plus, consultez les guides comme le Guide d'intégration Claude Code-LangSmith et Apprentissage des prompts système pour agents de code.

Alors, après avoir plongé dans l'API Gemini Interactions, j'ai découvert son potentiel et ses petites bizarreries. D'abord, comprendre ses fonctionnalités et ses limites est essentiel pour vraiment exploiter sa puissance. Attention aux compromis, notamment avec la gestion des tokens et la persistance de l'état côté serveur. Ensuite, n'oubliez pas que la version 1.55.0 du Google Gen AI SDK est indispensable. Enfin, avec des outils comme la recherche Google, l'exécution de code, et l'outil de contexte URL, vous pouvez vraiment booster vos projets. Le tout, c'est de continuer à expérimenter et à apprendre. Alors, prêt à plonger? Débutez avec l'API Gemini aujourd'hui, et voyez comment elle peut transformer vos projets. Et pour creuser plus loin, visionnez la vidéo originale "The Gemini Interactions API" sur YouTube: https://www.youtube.com/watch?v=aZgH_wnmedQ. Ça vaut le coup pour mieux comprendre les subtilités.

Questions Fréquentes

Thibault Le Balier

Co-fondateur & CTO

Issu de l'écosystème startup tech, Thibault a développé une expertise en architecture de solutions IA qu'il met aujourd'hui au service de grands groupes (Atos, BNP Paribas, beta.gouv). Il intervient sur deux axes : la maîtrise des déploiements IA (LLM locaux, sécurisation MCP) et l'optimisation des coûts d'inférence (offloading, compression, gestion des tokens).

Articles liés

Découvrez d'autres articles sur des sujets similaires

Intégration Claude Code-LangSmith : Guide Complet

Plongez dans un univers où l'IA s'intègre harmonieusement à votre flux de travail. Découvrez Claude Code et LangSmith. Ce guide vous montre comment ces outils transforment la façon dont vous interagissez avec la technologie. De la traçabilité des workflows aux applications pratiques, maîtrisez les fonctionnalités avancées de Claude Code. Imaginez obtenir des données météo en temps réel en quelques lignes de code. Apprenez à configurer cette intégration puissante et à tirer parti des hooks et transcriptions de Claude Code. Prêt à révolutionner votre routine numérique? Suivez le guide!

Innovation: Relever les défis techniques

Dans le monde effervescent de la technologie, les plus grandes innovations naissent souvent des défis les plus audacieux. Êtes-vous prêt à relever ces défis ? Cet article plonge dans l'art de s'attaquer à des idées techniquement exigeantes. Il révèle comment le courage et des compétences aiguisées sont essentiels pour innover. Ne restez pas isolé : découvrez l'importance cruciale des retours clients pour affiner vos produits. Apprenez à équilibrer la préparation du produit avec l'interaction client. Lisez la suite pour comprendre comment les plus grands esprits de notre temps poursuivent les problèmes difficiles pour façonner l'avenir.

Apprentissage par Prompts pour Agents de Code: Guide

Imaginez des agents de code capables d'apprendre en continu, s'adaptant à chaque nouvelle ligne de code. C'est la promesse de l'apprentissage par prompts. Dans le domaine de l'IA, cette méthode émerge comme une technique puissante, en particulier pour les agents de codage. Cet article plonge dans les subtilités de cette approche et la compare à des méthodes traditionnelles comme l'apprentissage par renforcement. Découvrez comment le benchmarking avec SWEBench et des outils comme Claude et Klein permettent de mesurer l'efficacité de cette technique. Explorez également le rôle des modèles de langage avancé (LLM) en tant que juges dans l'évaluation de ces prompts et comment cette méthode se compare à d'autres comme GEA. L'article met en lumière l'impact de l'apprentissage par prompts sur la performance des agents de codage, et souligne l'importance des prompts d'évaluation dans ce contexte.

Optimiser le Code avec Juny: Intégration Efficace

Je suis tombé sur Juny en cherchant à rationaliser mon flux de travail de codage. Sponsorisé par JetBrains, cet outil promet de couper à travers le bruit pour se concentrer sur l'essentiel : un codage efficace et minimaliste. Imaginez un IDE qui s'intègre parfaitement avec IntelliJ IDEA ou PyCharm pour booster votre productivité sans l'encombrement habituel. Juny se positionne comme un outil anti-vibe, parfait pour les développeurs professionnels qui souhaitent optimiser leur code avec le moins de frictions possible. En plus, il supporte plusieurs langages et frameworks, facilitant l'adaptation pour les équipes et la compréhension des bases de code. Que vous soyez en train d'intégrer une nouvelle équipe ou de peaufiner votre projet solo, Juny pourrait bien être le game changer que vous attendiez.

Exécuter Deepseek OCR sur GPU Cloud: Guide Pratique

J'ai exploré des solutions OCR pendant un moment, mais le jour où j'ai lancé Deepseek OCR sur un GPU cloud, j'ai compris que je touchais à quelque chose de puissant. Dans ce guide pratique, je vais vous montrer comment j'ai configuré cela avec Data Crunch et pourquoi c'est un vrai atout pour la confidentialité et la durabilité. On va plonger dans la configuration, les coûts et comment optimiser votre utilisation GPU. Avec Deepseek OCR, on parle d'un outil open-source parfait pour la transcription médicale et la reconnaissance d'écriture manuscrite. Je vais partager avec vous les étapes techniques sur Jupyter Lab et comment gérer efficacement les instances pour maximiser votre retour sur investissement.

Optimisez vos coûts avec Gemini 3 Flash OCR

J'ai plongé dans les tâches OCR depuis des années, et quand Gemini 3 Flash est arrivé, j'ai su que je devais tester ses promesses de réduction de coûts et de performances. Imaginez un modèle qui coûte quatre fois moins cher que le Gemini 3 Pro, à seulement 0,50 $ par million de tokens en entrée et 3 $ pour ceux en sortie. Je vous explique comment ce modèle se compare aux gros calibres et pourquoi c'est un véritable atout pour l'OCR multilingue. De la rentabilité aux capacités multilingues, en passant par les benchmarks techniques, je vous livre mes découvertes pratiques. Ne vous laissez pas avoir par le battage, venez découvrir comment Gemini 3 Flash transforme le jeu pour les tâches OCR.

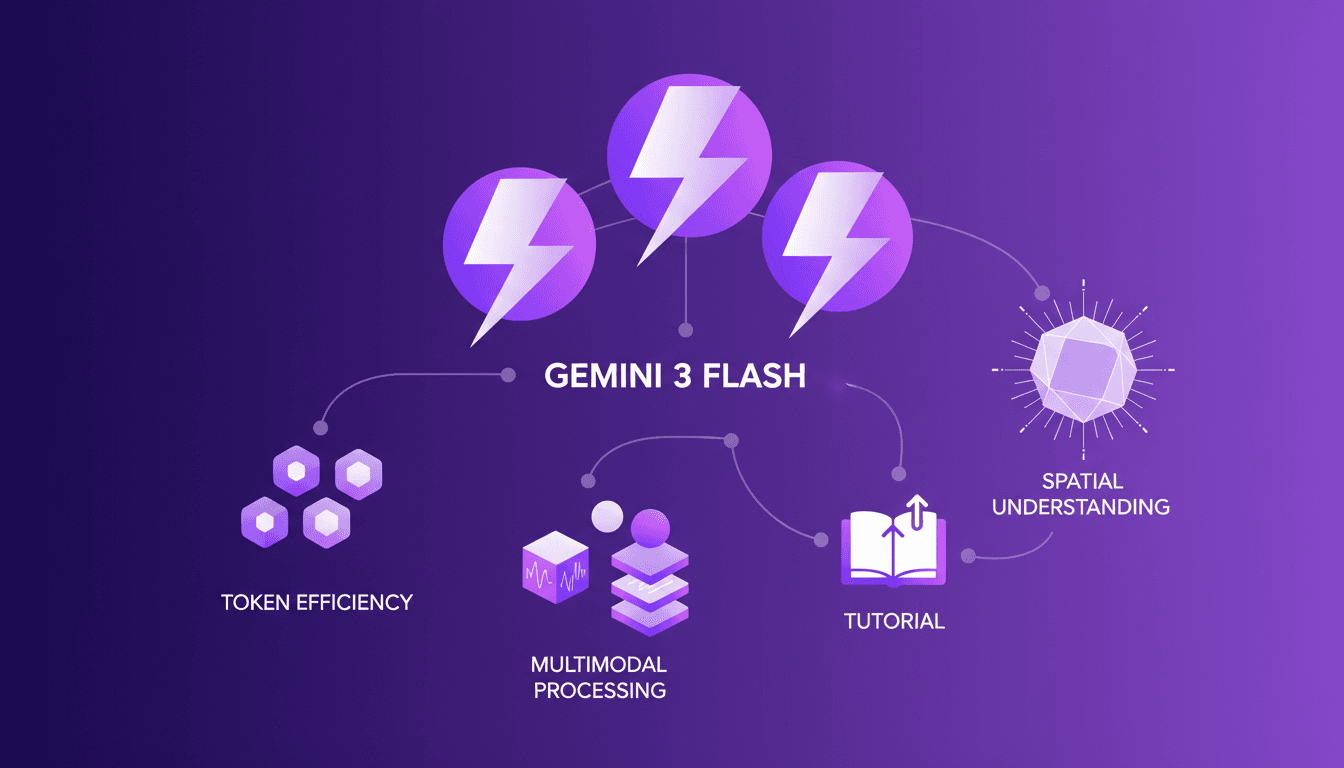

Gemini 3 Flash : Optimisez votre flux de travail

Je pataugeais dans les problèmes d'utilisation de jetons quand j'ai mis la main sur le Gemini 3 Flash. Franchement, c'était comme passer du vélo à la voiture de sport. Je l'ai intégré dans mon flux de travail quotidien, et il est devenu mon outil incontournable. Avec ses capacités multimodales et sa compréhension spatiale améliorée, il redéfinit l'efficacité. Mais attention, il y a des limites. Au-delà de 100K tokens, ça devient compliqué. Je vous explique comment j'ai optimisé mes opérations et les erreurs à éviter.

Fonction Gemma : Appels de Fonction à la Périphérie

J'ai plongé dans la Fonction Gemma pour voir comment elle pouvait révolutionner les appels de fonction à la périphérie. En mettant la main sur le modèle Gemma 3270M, le potentiel est devenu immédiatement clair. Avec ses 270 millions de paramètres et un entraînement sur 6 trillions de tokens, ce modèle est conçu pour gérer efficacement des tâches complexes. Mais comment en tirer le meilleur parti ? Je l'ai affiné pour des tâches spécifiques et déployé avec Light RT. Attention, il y a des pièges à éviter. Allons-y, je vous explique tout.